-

【翻译】Global Voices: Crossing Borders in Automatic News Summarization

Abstract

我们构建了一个名为“Global Voices”的多语言数据集,用于评估跨语言摘要方法。我们从Global Voices新闻文章中提取社交网络描述,以廉价的方式收集评估数据,用于15种语言的英译和译英摘要。特别是对于英译摘要任务,我们通过众包方式创建了一个高质量的评估数据集,基于强调准确性、覆盖范围和可理解性的指南。为了确保这个数据集的质量,我们收集了人工评级来筛选掉糟糕的摘要,并对人类进行了一项调查,结果显示剩下的摘要比社交网络摘要更受欢迎。我们研究了在跨语言摘要中翻译质量的影响,将一种翻译然后摘要的方法与几种基线方法进行了比较。我们的结果突显了在单语摘要中被忽视的ROUGE指标的局限性。我们的数据集可以在以下链接下载:https://forms.gle/gpkJDT6RJWHM1Ztz9。

Introduction

跨语言摘要是一项重要但鲜有探索的任务。能够以大规模的方式总结任何语言中的书面或口头信息将使人类拥有更多有关多元世界的知识。尽管自动摘要技术发展迅速(Allahyari等,2017;Dong,2018;Gambhir和Gupta,2017),但目前的技术主要集中在单语言摘要上。目前几乎没有用于评估跨语言摘要方法的标准高质量多语言数据(例如,Giannakopoulos(2013);Li等(2013);Elhadad等(2013))。构建这样一个数据集面临两个主要挑战。首先,众包人工编写摘要的成本很高。人类通常需要很长时间来总结一份文档,因为他们不仅需要阅读和理解文章中的信息,还需要在筛选和改写信息方面做出复杂的决策。其次,为人类设计摘要指南很困难,因为任务通常定义不清楚:在摘要中选择哪些内容是“重要”的是基于主观和常识规则的,这些规则在个体之间有所不同,并且难以精确地用文字表达。

即使在单语言摘要中,也只有少数尝试通过众包方式构建摘要数据集(Over等,2007;Dang和Owczarzak,2008,2010)。这些数据集主要用于评估,因为它们规模较小。为了构建大规模的训练数据集,研究人员从新闻来源中挖掘人工编写的摘要(Hermann等,2015;Sandhaus,2008),或从文档标题构建人工摘要(Rush等,2015)。以这种方式收集的摘要可能不太适合用于评估,因为它们是根据未知的指南生成的(或根本没有指南)。先前关于跨语言摘要的研究使用人工判断进行评估(?),或使用由自动翻译系统生成的自动度量标准和嘈杂的源文章进行评估(Wan等,2010;Ouyang等,2019)。前一种方法昂贵且不可重复,而后一种方法容易受到翻译系统引发的偏见的影响,这些偏见可能会被摘要系统进一步放大。

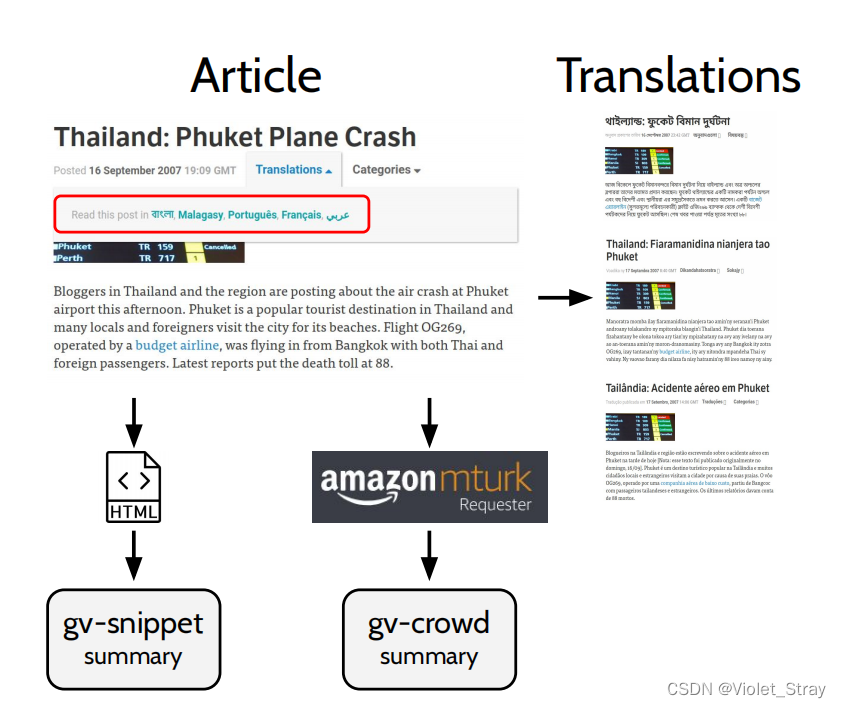

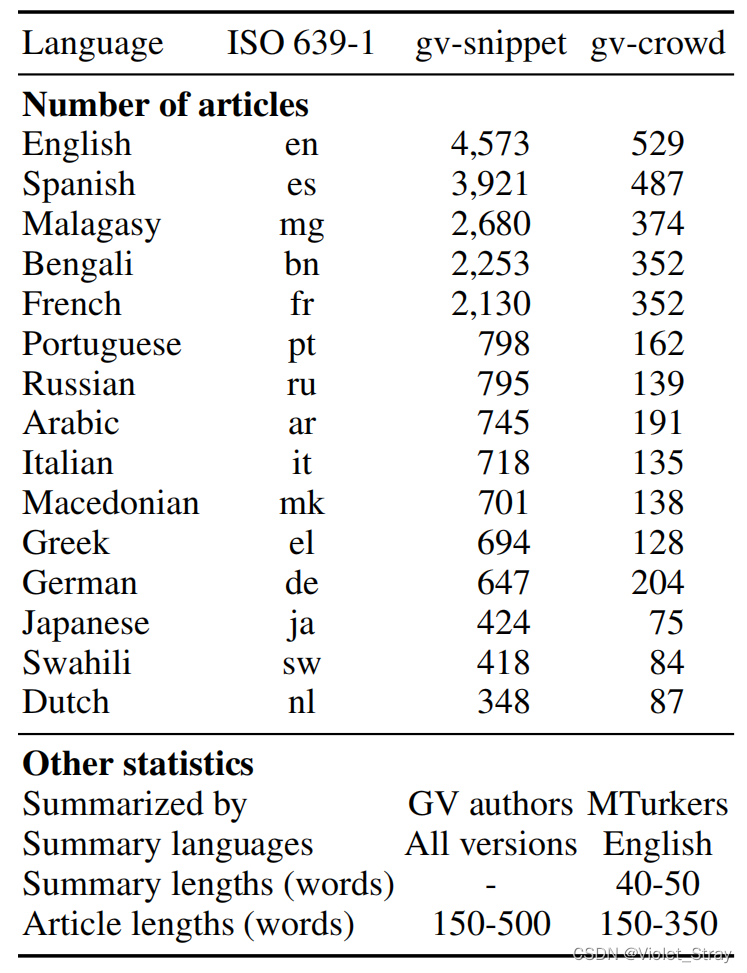

本文介绍了Global Voices,这是一份高质量的多语言新闻摘要数据集。该数据集可用作多语言和跨语言摘要领域的标准基准。Global Voices是一个多语言网站,报道并翻译全球范围内未被听闻的声音的新闻。该网站的翻译由Lingua团队执行,该团队由志愿者翻译人员组成。截至2019年8月,Global Voices 提供了51种语言的新闻文章翻译;许多文章被翻译成多种语言。图1展示了Global Voices的一个示例文章。我们从这些文章中提取社交网络描述,以(廉价的方式)构建了gv-snippet,这是一个用于多语言和跨语言新闻摘要的评估集。然而,这些描述通常对原始内容的覆盖较差,因为它们是为了吸引用户点击查看更多文章而编写的。因此,除了gv-snippet,我们还根据明确强调准确性、覆盖范围和可理解性的指南构建了一个较小但更高质量的人工编写的英语摘要数据集,称为gv-crowd。Global Voices数据集在表2中进行了总结。目前,它支持15种语言,涵盖了九种语言属(罗曼斯、巴里托、印度、斯拉夫、闪族、希腊、日耳曼、日本、班托伊德)和五种语言家族(印欧语、南岛语、日本语、尼日尔-刚果语、阿非罗-亚非语)。

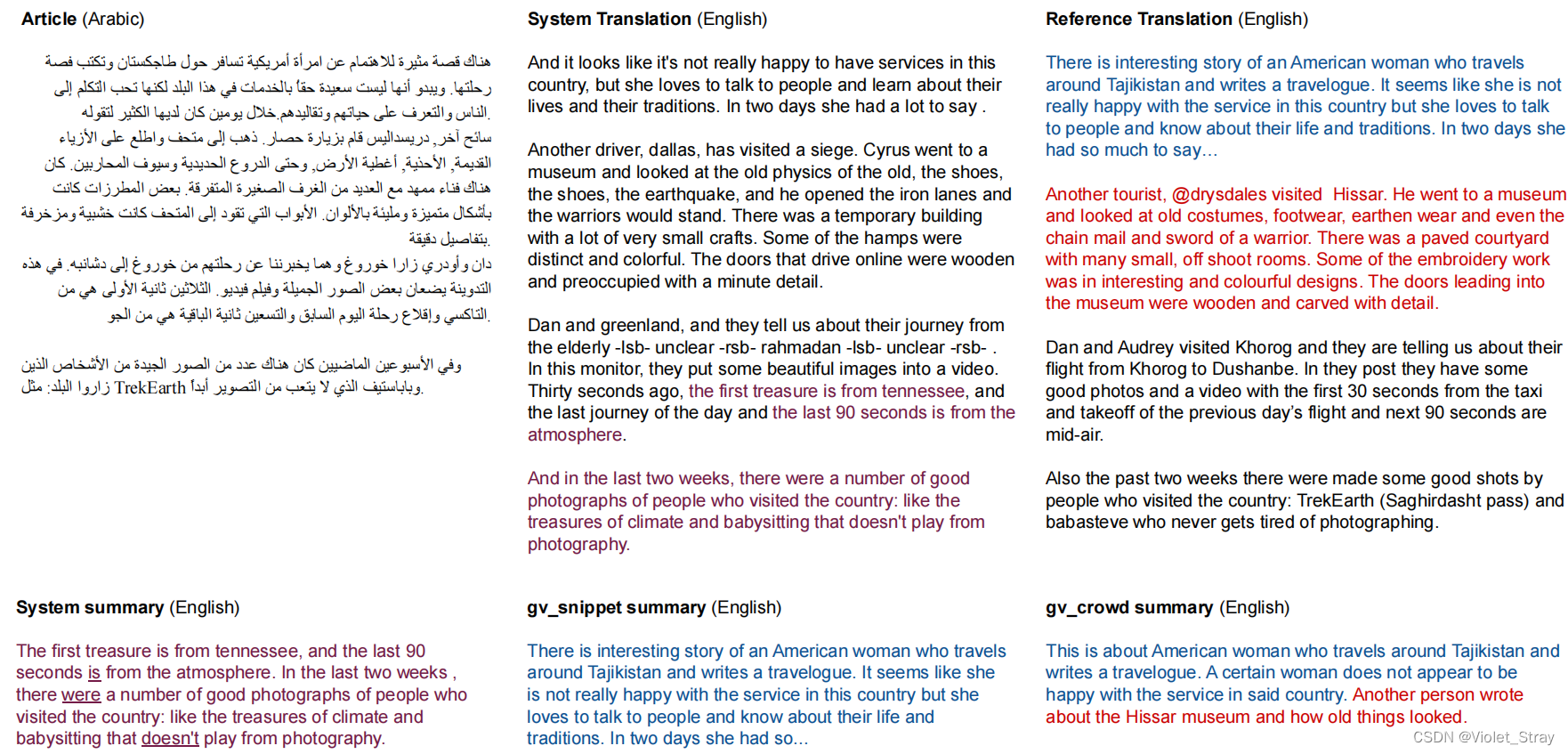

图1:数据构建流程。我们收集了两种类型的摘要:(a) 文章的社交网络描述(gv-snippet)和(b) 根据我们的指南由Mechanical Turk工作者编写的50字摘要(gv-crowd)。

表格1:Global Voices数据集概要。该数据集包含15种语言的文章。所有非英语文章均包括英语版本。gv-snippet分组包含所有文章的社交网络摘要,而gv-crowd分组包含英语文章的众包摘要。Dataset Construction

**数据收集与预处理。**我们使用Scrapy,爬取并下载了41,939篇英语文章及其翻译的HTML源代码。接下来,我们使用bs4来提取每篇文章的主要内容并删除图像标题。然后,我们使用html2text来将主要内容的HTML源代码转换为普通文本,删除网页和图像的URL。由于一篇文章可能包含原始语言写成的块引用,我们检测每个段落的语言并删除不属于文章主要语言的段落。语言检测通过四个包的投票决策来进行:langdetect、langid、polyglot、fastText(Joulin等,2016a,b)。

构建gv-snippet。这个分组包括英语版本的长度在150到500字之间的文章。对于每篇文章,我们通过提取HTML源代码中具有属性og:description的meta标签来提取其Open Graph描述,并将该描述用作文章的参考摘要。这些描述是短文本片段,用作文章在社交网络(例如Facebook、Twitter)上出现时的标题。

众包gv-crowd。我们选择包含150-350字的英语文章,并从Mechanical Turk(MT)请求工作者对它们进行40-50字的摘要。每个HIT要求一个工作者在35分钟内总结五篇文章。我们在加拿大和美国招募了具有硕士资格、HIT批准率大于或等于97%以及批准的HIT数量大于或等于1,000的Turker。平均而言,收集一个摘要的成本为1.50美元(包括税收和额外费用)。我们向工作者介绍了我们的评估指南,重点关注三个标准:

- 准确性:摘要中的信息应仅基于原始文章。它可以是从原文改写的,但不应与文章中的信息相抵触。

- 覆盖范围:摘要应反映原始文章中最重要的信息/故事。每个信息/故事应尽可能详细地呈现,不应漏掉其他重要的信息/故事。

- 可理解性:摘要必须用标准、流利的英语编写。读者必须能够在不阅读原文的情况下理解摘要。理解摘要不应需要任何超出理解文章所需的额外知识。

相比之下,DUC-2004数据集(Over等,2007)仅提供了轻微的格式建议,几乎完全由写手决定摘要的内容:

想象一下,为了节省时间,您不是先阅读一组完整的文件,而是首先阅读这些文件的非常简短的摘要列表,并根据这些摘要来选择哪些文件要完整阅读。创建您的非常简短的摘要,以在这种情况下具有用途。非常简短的摘要可以看起来像报纸标题,是由逗号分隔的重要术语或短语的列表,一个句子等。它不应包含任何格式,即不应有缩进的列表等。请随意使用您自己的措辞。

来源: https://duc.nist.gov/duc2004我们的指南标准与TAC 2010的有导向摘要任务(Dang和Owczarzak,2010)类似,但我们不限制使用领域特定的模板来构建摘要。由于删除了图像和视频,有些文章可能阅读时会受到干扰,并可能包含非英语文本。为确保摘要仅基于英语文本,我们建议工作者不要(a)在网络上搜索原始内容,以及(b)忽略非英语内容。我们还强调正确拼写单词,并建议从原文章中复制难拼写的单词。最终,我们收集了738篇文章的840份摘要。

对于gv-crowd的人工评估。总结收集任务获得了工作者们的大多数积极反馈。该任务被普遍认为是“有趣”、“有趣”和“具有挑战性”的。然而,许多工作者对严格的时间限制表示担忧。为了评估数据集的质量,我们启动了另一个MT任务,要求工作者评分和编辑在前一个任务中收集的摘要。每个任务HIT要求在60分钟内评估十份摘要。我们在加拿大和美国招募了HIT批准率大于或等于97%,并且批准的HIT数量大于或等于1,000的工作者。具体来说,我们要求工作者提供两种类型的评分:基于标准的评分和整体评分。每位工作者被要求首先在我们的三个标准(准确性、覆盖范围、可理解性)中为每份摘要分别给出1到5的评分,然后给出摘要的整体评分。我们定义了三个整体评分级别:

-

Bad:摘要误传了原文章。它包含与文章内容不符的事实错误,或者没有涵盖文章最重要的信息/故事,或者缺少其他重要的点,可以在不违反50字的限制下轻松包括。

-

Acceptable:摘要涵盖了文章最重要的信息/故事。它没有包含事实错误。它可能缺少一两个难以在50字摘要中包含的重要点。

-

Good:摘要涵盖了文章最重要的信息/故事。它没有包含事实错误。所有重要的点都被包括了进来。

此外,工作者需要写短小的理由(每个理由在5-25字之间)来证明他们的评分。

在840份摘要中,383份(45.60%)被评为“好”,264份(31.43%)被评为“可以接受”,193份(22.98%)被评为“不好”。我们观察到,在三个标准中,可理解性最容易满足,而覆盖范围最具挑战性:平均可理解性评分为4.06,而平均覆盖范围评分仅为3.47;约90%的摘要达到了至少3的可理解性评分。通过计算皮尔逊相关系数,我们发现整体评分与覆盖范围评分之间存在最强的线性相关性(0.81),与可理解性评分之间相关性最弱(0.57)。人工评估员们发现的常见问题包括:遗漏重要的要点、事实错误、晦涩和/或冗长的写作。为了构建gv-crowd分组,我们将每篇文章与其最高评分的摘要配对,并排除了以下情况的文章:(a) 与差评摘要配对的文章或(b) 具有低于3的基于标准的评分。我们还要求工作者纠正差评摘要中的拼写和事实错误,但这些经过后期编辑的摘要需要进一步评估,才能在将来纳入数据集中。为了便于总结评估研究,我们将发布所有摘要,附带它们的评分、理由和后期编辑版本。

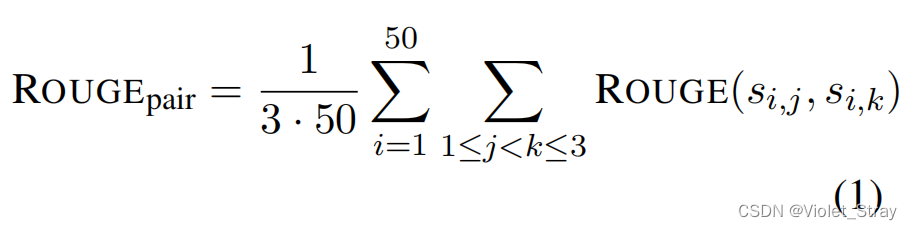

对于随机选择的50篇文章的子集,我们收集每篇文章的三份摘要,以研究同一份文档的人工编写摘要在质量和语言使用方面的多样性。我们发现摘要的质量变化不大:在这些文章中,最高评分和最低评分摘要之间的整体评分差异在74%的文章中最多只有1分。为了量化摘要的多样性,我们计算了ROUGE得分对,使用一份摘要作为参考,另一份作为预测

其中, S i , j S_{i,j} Si,j和 S i , k S_{i,k} Si,k是第i篇文章的不同摘要。 R O U G E p a i r − 1 , 2 , L F − 1 ROUGE_{pair}-1,2,L F-1 ROUGEpair−1,2,LF−1得分相对较低(分别为39.44、12.39和32.85),表明这些摘要在词汇和句子结构方面差异很大。

对gv-snippet和gv-crowd的人工比较。为确保gv-crowd的摘要质量高于gv-snippet的摘要,我们进行了一项调查,要求MT工作者比较这两种类型的摘要。具体来说,每位工作者阅读一篇文章以及其gv-snippet和gv-crowd的摘要。我们要求工作者在三个标准中指定哪个摘要(或都不选)在每个标准中更好,并在整体上更好。我们删除了gv-snippet摘要中以“…”结尾的部分句子,以确保工作者主要根据其内容对比两种类型的摘要,而不是根据任何奇怪的特征。我们还随机洗牌了摘要对中的摘要顺序,以使工作者无法依赖顺序来确定摘要类型。每位工作者有45分钟的时间来比较五对摘要。每对摘要由三位工作者评估。我们招募了与gv-crowd评估任务中的工作者具有相似资格的工作者。

这项调查的结果是积极的。在调查中包括的30篇文章中,有22篇(75.9%)至少有3位工作者中的2位更喜欢gv-crowd的摘要。总体而言,90名工作者中有63名(70.0%)更喜欢gv-crowd的摘要,而不是其gv-snippet摘要。正如预期的那样,在所有标准中,gv-crowd摘要对比gv-snippet摘要显示出最强的覆盖范围,偏好比例为83.3%(25/30),而准确性和可理解性的偏好比例为66.7%(20/30)。

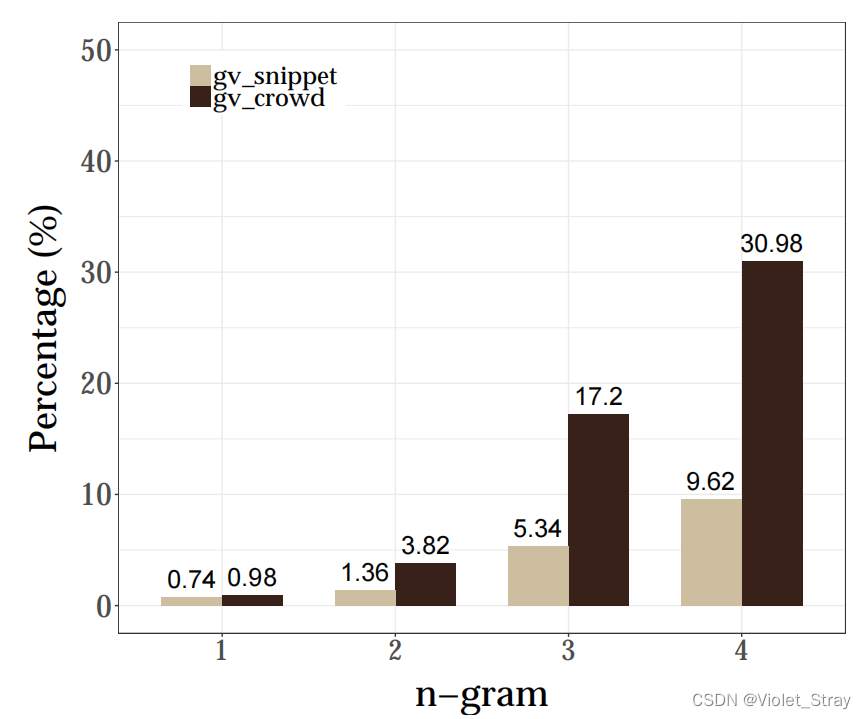

我们还评估了这两种类型的摘要,以了解它们相对于原始文章而言的新颖性。图2显示了每种摘要类型的平均新颖n-gram的比例。总体而言,摘要大部分重复使用文章中的单词。与gv-snippet摘要相比,gv-crowd摘要包含更多新颖的3-gram和4-gram,部分原因是gv-crowd摘要的每个句子通常包括原始文章中多个句子的信息。在gv-crowd分组的73%的文章中,gv-crowd摘要在新颖n-gram的比例方面高于gv-snippet摘要(其中n = 1, 2, 3, 4)。

图2:摘要中未在原始文章中出现的n-gram的平均比例。

表2:用于训练和验证翻译和摘要模型的数据。3 Experiments

我们研究了生成非英语新闻文章的英语摘要的任务。这个任务可以自然地分解为两个子任务:翻译和摘要。我们采用了一个“先翻译再摘要”的方法,其中每篇文章首先使用预训练的机器翻译模型翻译成英语,然后使用预训练的英语摘要模型对翻译进行摘要。在这两个子任务中用于训练模型的数据是公开可用的,允许以zero-shot方式解决联合任务,意味着在训练过程中不提供(原始文档,英语摘要)的并行对。另一方面,由于缺乏用于训练非英语语言中可靠摘要模型的大规模数据集,采用“先摘要再翻译”的方法在实践中难以实现。

(zero-shot:它指的是模型在没有接受过与特定任务或类别相关的显式训练样本的情况下,仍然能够执行该任务或分类到该类别。)翻译模型。我们的目标是研究在这个任务中翻译质量的影响。因此,我们使用在不同资源量下训练的翻译模型进行实验。我们在四种源语言上进行实验:西班牙语(es)、法语(fr)、德语(de)和阿拉伯语(ar)。具体来说,我们使用大规模的CommonCrawl和News Commentary数据集训练{es,fr}-en模型,并使用资源较少的多语言TED数据集(Duh, 2018)训练{de,ar}-en模型。我们应用标准的机器翻译预处理步骤,使用Moses脚本对数据进行规范化和分词处理。我们使用PyArabic工具对阿拉伯文本进行分词。我们的翻译模型实现了Transformer架构(Vaswani等,2017)。{es,fr}-en模型具有与Vaswani等人(2017)中表3描述的基本Transformer架构相同的超参数。{de,ar}-en模型具有更少的参数,使用4个注意力头和1024的前馈隐藏大小。我们使用fairseq-py工具包(Ott等,2019)训练这些模型。由于这些模型是训练用于句级翻译的,我们==将源文章分成句子,进行翻译,然后将输出的句子组合成文章。==训练设置与Vaswani等人(2017)相同,只是:(a)每批次的最大令牌数为4,000,(b) {es,fr}-en模型和{de,ar}-en模型分别训练5·104和8·105次迭代,© {de,ar}-en模型使用0.3的丢弃率。使用Nvidia Titan Xp GPU进行训练,较小的模型大约需要5小时,较大的模型需要3.5天。

摘要模型。我们使用了最先进的Bi-LSTM自下而上的抽象式摘要模型(Gehrmann等人,2018)。我们利用了OpenNMT-py(Klein等人,2017)提供的该模型的预训练实例,并在CNN/DailyMail数据集(Hermann等人,2015)上进行了训练。

基线模型。我们比较了以下方法:

- FIRST50:复制源文章英文版本的前50个单词。

- PERFECTTRANS:直接总结源文章的英文版本。

- TRANSTHENSUM:我们的方法,首先将源文章翻译成英文,然后总结翻译结果。

评估。翻译质量通过语料库级别的BLEU(双语评估)来衡量,将每篇文章视为一个数据点。摘要质量通过计算ROUGE-1、ROUGE-2和ROUGE-L F-1得分来确定。

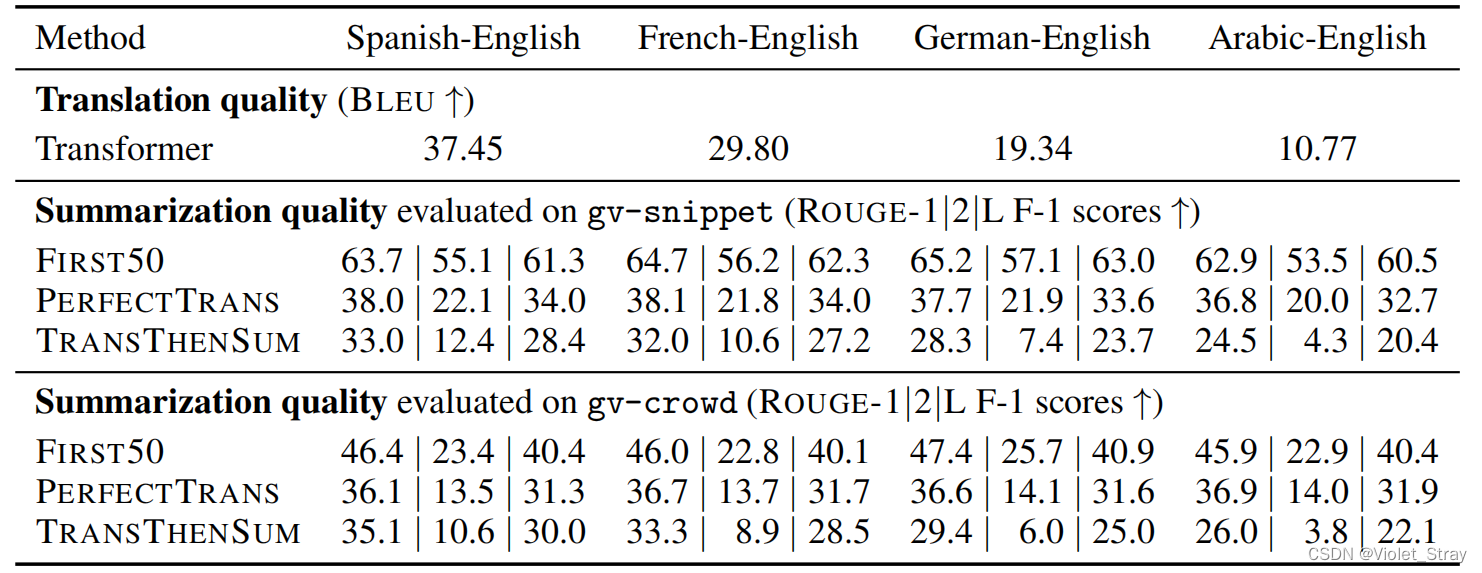

结果。表3呈现了我们的结果。图3展示了一个定性的例子。正如预期的那样,不同语言对之间的翻译质量有所不同。西班牙语-英语模型由于训练数据的数量和语言对的相似性而达到了最高的BLEU分数(34.45);在另一极端,阿拉伯语-英语模型提供了最差的翻译(10.77)。然而,尽管BLEU分数存在很大差距,但我们观察到ROUGE-1和ROUGE-L分数之间的差异要小得多。例如,在阿拉伯语-英语的极端情况下,即使从参考翻译切换到预测翻译时BLEU下降了近90%,ROUGE-L F1分数仅下降了约30%。这一观察突显了ROUGE-1和ROUGE-L的一个主要局限性:它们对摘要的可读性不敏感。即使源文件可能包含无意义、不合语法的内容(反映在低BLEU分数中),一个只是简单复制短语来进行摘要的模型也可以轻松获得较高的ROUGE-1和ROUGE-L分数。在单语摘要的背景下,很难观察到这一局限性,因为源文件来自自然来源,因此大部分是语法正确且有意义的。另一个有趣的发现是,在评估gv-snippet和gv-crowd时,FIRST50基线在gv-snippet上的ROUGE分数高于gv-crowd。这一观察表明,gv-snippet摘要与文章的开始部分高度重叠,从而证实了我们的人工偏好调查结果,即这些摘要相较于gv-crowd摘要通常对整篇文章的覆盖范围较差。

图3:我们数据集中的一个示例。源文件最初是用英文写的,由Global Voices的翻译员翻译成阿拉伯语。我们的翻译系统将阿拉伯语文章翻译成英语时表现不佳。摘要系统主要复制了翻译中的一些部分,并在摘要中保留了翻译中的语法错误(下划线部分)。gv-snippet摘要只是英文版本文章的前几句的简单复制(尽管在其他文章中可能不总是如此)。另一方面,gv-crowd摘要提供了更好的覆盖范围,包括第二段的信息。请注意,这篇文章很难在50个词内完美摘要,因为它同时涵盖了四个不同的平行故事。在这里,gv-crowd摘要更注重故事的具体性而牺牲了覆盖范围。

表3:使用不同方法进行的跨语言摘要结果。翻译质量是在gv-snippet文章上进行测量的,而gv-crowd文章是其中的一个子集。4 Conclusion

这项工作介绍了一个用于评估多语言和跨语言摘要方法的数据集,涵盖了多种语言。未来的工作旨在将数据集扩展到更多语言,并构建一个大规模的训练数据集。另一个有趣的方向是研究多任务学习是否有助于跨语言摘要。为了充分利用这一事实,即不一定需要翻译整篇源文章,有必要教导模型通过告知它们下游的摘要目标来设计更高效的翻译策略。

Acknowledgement

本研究部分基于美国国家情报总监办公室(ODNI)情报高级研究计划署(IARPA)通过合同#FA8650-17-C-9117的支持。本文中包含的观点和结论是作者的观点,不应被解释为必然代表ODNI、IARPA或美国政府的官方政策,无论是明示的还是隐含的。美国政府有权以政府用途为目的复制和分发再版,尽管其中可能有版权注释。本研究还部分基于美国国家科学基金会在Grant No. IIS-1618193下的支持。本材料中表达的任何意见、发现、结论或建议都是作者的观点,不一定反映国家科学基金会的观点。

-

相关阅读:

Hadoop高手之路4-HDFS

10.STM32外部中断实验

关于游戏公司组织架构的小讨论

VSCode 快速移动光标至行尾

通过Node + SSE 做了一个构建日志推送

操作系统(1)---操作系统的概念、并发、共享、虚拟、异步、以及操作系统的运行机制及体系结构。

java基于微信小程序的校园服务平台 uniapp 小程序

数仓模块ods层—每日行情数据入库(01)

高斯混合滤波

Codeforces Round #803 (Div. 2)(A-D)

- 原文地址:https://blog.csdn.net/weixin_45454859/article/details/133645179