-

Redis高可用之哨兵模式、集群

一、Redis哨兵模式

1.1 简介

主从模式,当主节点宕机之后,从节点是可以作为主节点顶上来,继续提供服务的。

但是有一个问题,主节点的IP已经变动了,此时应用服务还是拿着原主节点的地址去访问,这…

于是,在Redis 2.8版本开始引入,就有了哨兵这个概念。

哨兵模式的核心功能是在主从复制的基础上,引入了主节点的自动故障转移。

端口号:26379

1.2 哨兵模式的作用

1)监控:哨兵会不断地检查主节点和从节点是否运作正常。

2)自动故障转移:当主节点不能正常工作时,哨兵会开始自动故障转移操作,它会将失效主节点的其中一个从节点升级为新的主节点,并让其它从节点改为复制新的主节点。

3)通知(提醒):哨兵可以将故障转移的结果发送给客户端。

1.3 哨兵结构

哨兵结构由两部分组成,哨兵节点和数据节点

哨兵节点:哨兵系统由一个或多个哨兵节点组成,哨兵节点是特殊的redis节点,不存储数据。

数据节点:主节点和从节点都是数据节点。1.4 故障转移机制(重要)

-

由哨兵节点定期监控发现主节点是否出现了故障。

每个哨兵节点每隔1秒会向主节点、从节点及其它哨兵节点发送一次ping命令做一次心跳检测。

如果主节点在一定时间范围内不回复或者是回复一个错误消息,那么这个哨兵就会认为这个主节点主观下线了(单方面的)。

当超过半数哨兵节点认为该主节点主观下线了,这样就客观下线了。

-

当主节点出现故障,此时哨兵节点会通过Raft算法(选举算法)实现选举机制共同选举出一个哨兵节点为leader,来负责处理主节点的故障转移和通知。

所以整个运行哨兵的集群的数量不得少于3个节点。

-

由leader哨兵节点执行故障转移。

##故障转移过程## 将某一个从节点升级为新的主节点,让其它从节点指向新的主节点; 若原主节点恢复也变成从节点,并指向新的主节点; 通知客户端主节点已经更换。- 1

- 2

- 3

- 4

客观下线是主节点才有的概念;

如果从节点和哨兵节点发生故障,被哨兵主观下线后,不会再有后续的客观下线和故障转移操作。

1.5 主节点选举机制

1)过滤掉不健康的(已下线的),没有回复哨兵 ping 响应的从节点。

2)选择配置文件中从节点优先级配置最高的。(replica-priority,默认值为100)

3)选择复制偏移量最大,也就是复制最完整的从节点。

二、部署Redis哨兵模式

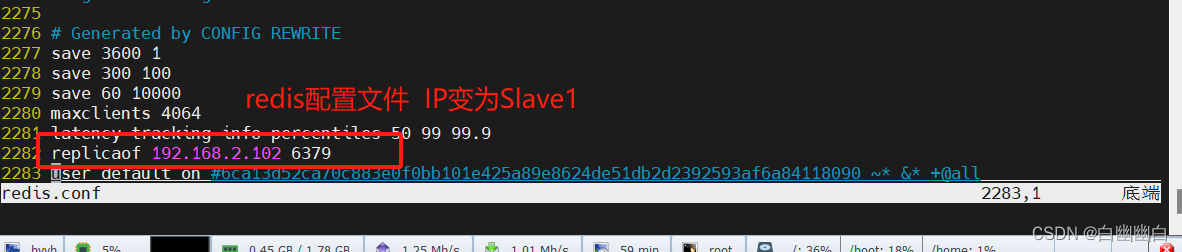

节点服务器 IP地址 Master 192.168.2.100 Slave1 192.168.2.102 Slave2 192.168.2.103 redis-cli -a abc123 info replication -aStep1 修改 Redis 哨兵模式的配置文件(所有节点操作)

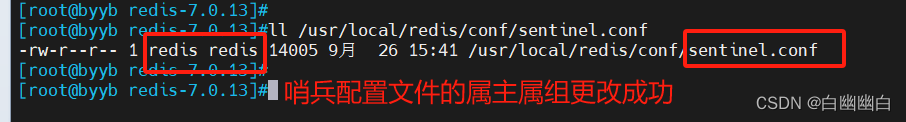

cp /opt/redis-7.0.13/sentinel.conf /usr/local/redis/conf/ chown redis.redis /usr/local/redis/conf/sentinel.conf- 1

- 2

- 3

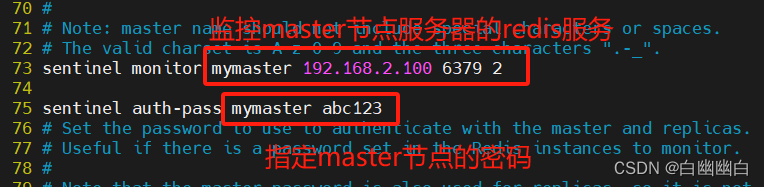

vim /usr/local/redis/conf/sentinel.conf protected-mode no #6行,关闭保护模式 port 26379 #10行,Redis哨兵默认的监听端口 daemonize yes #15行,指定sentinel为后台启动 pidfile /usr/local/redis/log/redis-sentinel.pid #20行,指定 PID 文件 logfile "/usr/local/redis/log/sentinel.log" #25行,指定日志存放路径 dir /usr/local/redis/data #54行,指定数据库存放路径 sentinel monitor mymaster 192.168.2.100 6379 2 #73行 #指定该哨兵节点监控192.168.2.100:6379这个主节点 #该主节点的名称是mymaster, #最后的2的含义与主节点的故障判定有关:至少需要2个哨兵节点同意,才能判定主节点故障并进行故障转移 sentinel auth-pass mymaster abc123 #76行指定Master节点的密码,仅在Master节点设置了requirepass sentinel down-after-milliseconds mymaster 3000 #114行,判定服务器down掉的时间周期,默认3000毫秒(3秒) sentinel failover-timeout mymaster 180000 #214行,同一个sentinel对同一个master两次failover之间的间隔时间(180秒)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

Step2 实现基于VIP(虚拟IP)的故障转移(所有节点)

#VIP地址漂移 #修改哨兵配置文件279行,添加脚本路径 sentinel client-reconfig-script mymaster /usr/local/redis/conf/fail.sh- 1

- 2

- 3

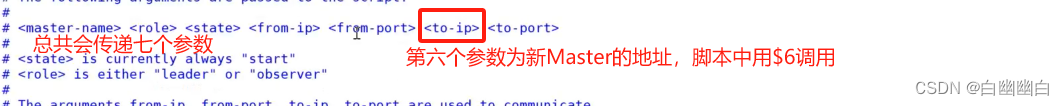

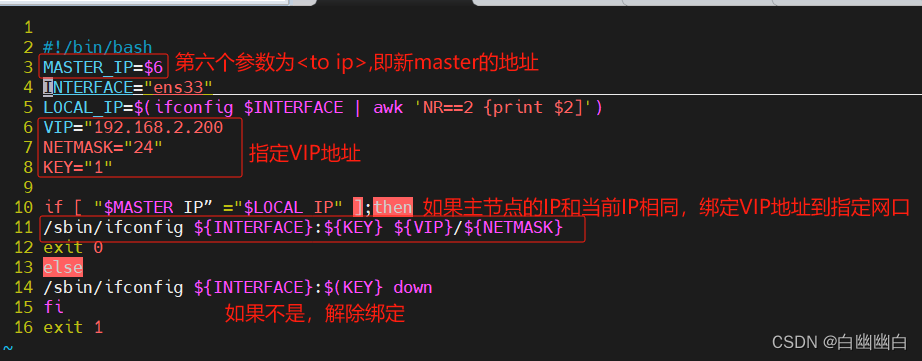

脚本 #!/bin/bash MASTER_IP=$6 #表示传递的第六个参数,即新Master的地址 INTERFACE="ens33" LOCAL_IP=$(ifconfig $INTERFACE | awk 'NR==2 {print $2}') #本机IP 网卡ens33对应 VIP="192.168.2.200" #设定VIP NETMASK="24" KEY="1" #判断当前节点是否为主节点 if [ "$MASTER_IP” = "$LOCAL_IP" ];then /sbin/ifconfig ${INTERFACE}:${KEY} ${VIP}/${NETMASK} #如果是,将设定的VIP绑定到指定的网络接口上 exit 0 else /sbin/ifconfig ${INTERFACE}:${KEY} down #如果不是,将指定的网络接口和绑定的VIP停止 fi exit 1 #给脚本加执行权限 chmod +x fail.sh- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

#Master节点的脚本和配置文件传输给Slave1 scp /usr/local/redis/conf/sentinel.conf 192.168.2.102:/usr/local/redis/conf/sentinel.conf scp /usr/local/redis/conf/fail.sh 192.168.2.102:/usr/local/redis/conf/ #Master节点的脚本和配置文件传输给Slave2 scp /usr/local/redis/conf/sentinel.conf 192.168.2.103:/usr/local/redis/conf/sentinel.conf scp /usr/local/redis/conf/fail.sh 192.168.2.103:/usr/local/redis/conf/ #复制过去后 要更改属组属主 chown redis.redis /usr/local/redis/conf/sentinel.conf- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

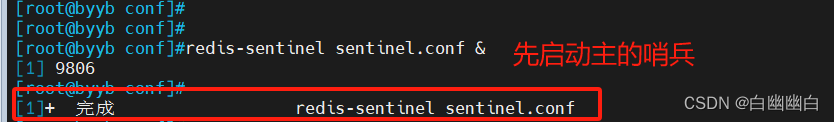

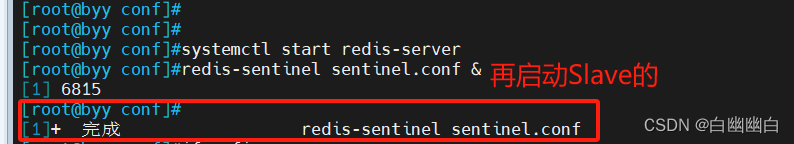

Step3 启动哨兵模式

注意:先启master,再启slave

cd /usr/local/redis/conf/ redis-sentinel sentinel.conf &- 1

- 2

- 3

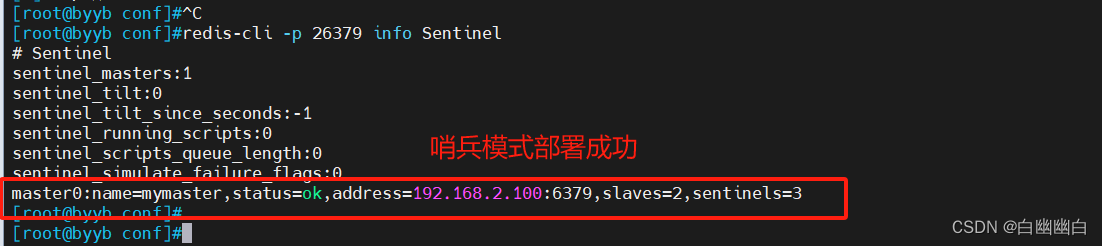

Step4 查看哨兵信息

redis-cli -p 26379 info Sentinel- 1

#执行脚本 #添加VIP bash fail.sh 1 1 1 1 1 192.168.2.100 1- 1

- 2

- 3

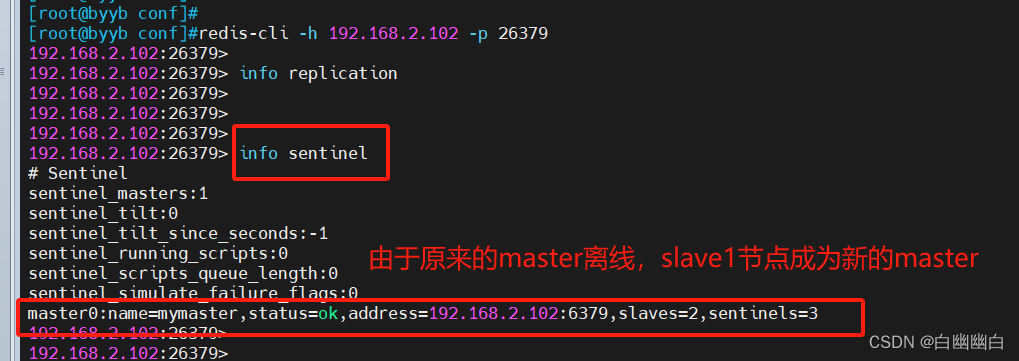

Step5 故障模拟,观察能否故障切换

通过观察各个节点的master、slave状态,还有VIP地址能否自动漂移。

1.关闭主节点的Redis服务

systemctl stop redis-server- 1

2.观察是否自动故障转移

#通过哨兵看 redis-cli -h 192.168.2.102 -p 26379 info sentinel- 1

- 2

- 3

- 4

4.观察VIP地址是否漂移

#Slave1 ifconfig- 1

- 2

5.重新启动master节点的redis服务

systemctl start redis-server #连接到redis redis-cli -a abc123 info replication #观察两个配置文件 #可以看到配置文件自动被修改,原来的master状态变为slave- 1

- 2

- 3

- 4

- 5

- 6

- 7

三、Redis集群

3.1 集群的定义

1)集群,即Redis Cluster,是Redis 3.0开始引入的分布式存储方案。

2)集群由多组节点(Node)组成,Redis的数据分布在这些节点中。

3)集群中的节点分为主节点和从节点:只有主节点负责读写请求和集群信息的维护;从节点只进行主节点数据和状态信息的复制。

3.2 集群的作用

3.2.1 数据分区

数据分区(或称数据分片)是集群最核心的功能。

集群将数据分散到多个节点,一方面突破了Redis单机内存大小的限制,存储容量大大增加;

另一方面每个主节点都可以对外提供读服务和写服务,大大提高了集群的响应能力。

#补充 Redis单机内存大小受限问题,在介绍持久化和主从复制时都有提及; 例如,如果单机内存太大,bgsave和bgrewriteaof的fork操作可能导致主进程阻塞,主从环境下主机切换时可能导致从节点长时间无法提供服务,全量复制阶段主节点的复制缓冲区可能溢出。- 1

- 2

- 3

- 4

3.2.2 高可用

集群支持主从复制和主节点的自动故障转移(与哨兵类似);

当任一节点发生故障时,集群仍然可以对外提供服务。

3.3 Redis集群的数据分片

Redis集群将整个数据集切分成多个数据分片,并将这些分片存储在不同的节点上。每个节点负责存储其中一个或多个数据分片

1)Redis集群引入了哈希槽的概念;

2)Redis集群有16384个哈希槽(编号0-16383);

3)集群的每组节点负责一部分哈希槽;

4)每个Key通过CRC16校验后对16384取余来决定放置哪个哈希槽,通过这个值,去找到对应的插槽所对应的节点,然后直接自动跳转到这个对应的节点上进行存取操作。

#以3个节点组成的集群为例: 节点A包含0到5460号哈希槽 节点B包含5461到10922号哈希槽 节点C包含10923到16383号哈希槽 #Redis集群的主从复制模型 集群中具有A、B、C三个节点,如果节点B失败了,整个集群就会因缺少5461-10922这个范围的槽而不可以用。 为每个节点添加一个从节点A1、B1、C1整个集群便有三个Master节点和三个slave节点组成,在节点B失败后,集群选举B1位为的主节点继续服务。当B和B1都失败后,集群将不可用。- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

五、部署Redis集群

Redis的集群一般需要6个节点,3主3从。

方便起见,这里在同一台服务器上模拟。

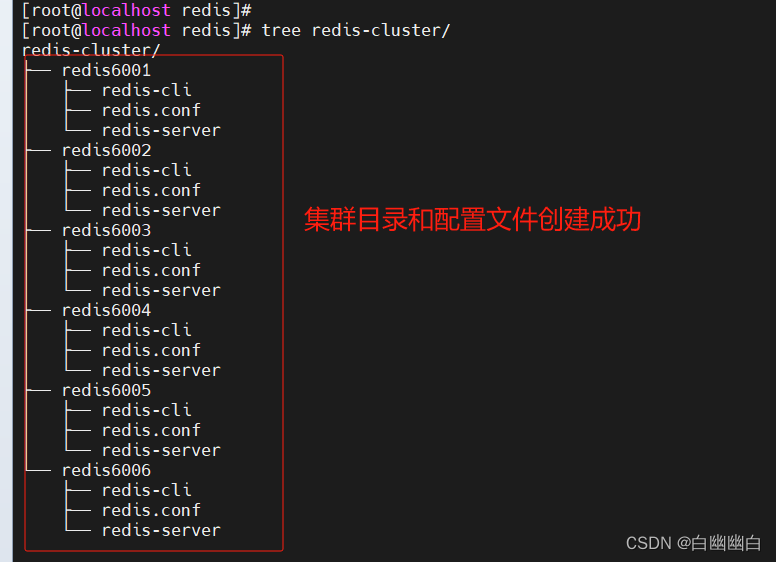

服务器 主机名 IP 主端口 从端口 Node1节点 node 192.168.2.106 6001 6004 Node2节点 node 192.168.2.106 6002 6005 Node3节点 node 192.168.2.106 6003 6006 Step1 创建集群配置目录及文件

cd /usr/local/redis/ mkdir -p redis-cluster/redis600{1..6} #复制 Redis 配置文件和可执行文件到不同目录 for i in {1..6} do #执行复制 循环6次 cp /opt/redis-7.0.13/redis.conf /usr/local/redis/redis-cluster/redis600$i cp /opt/redis-7.0.13/src/redis-cli /opt/redis-7.0.13/src/redis-server /usr/local/redis/redis-cluster/redis600$i done- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

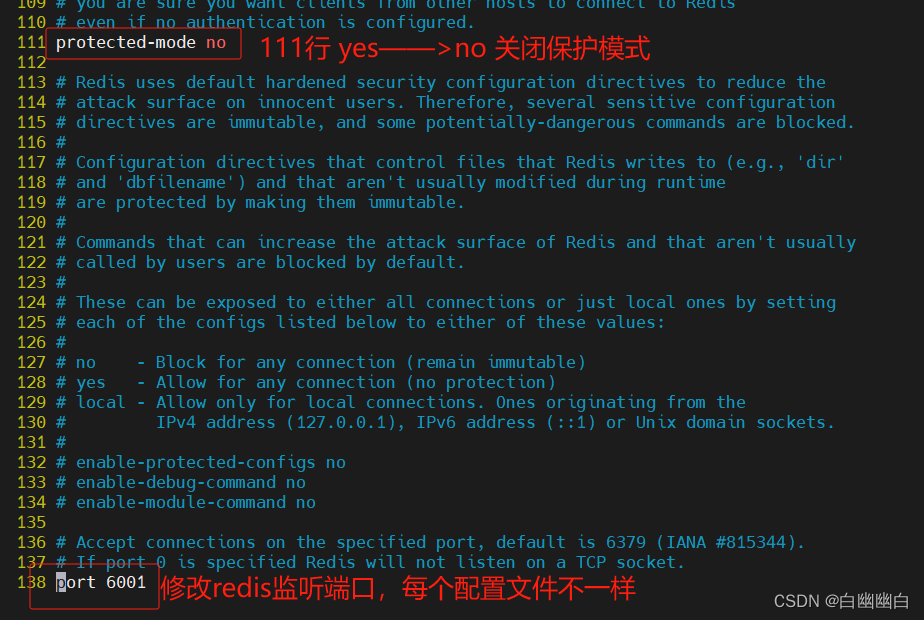

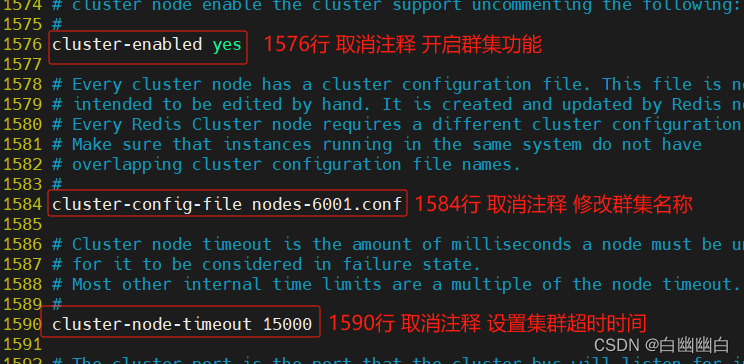

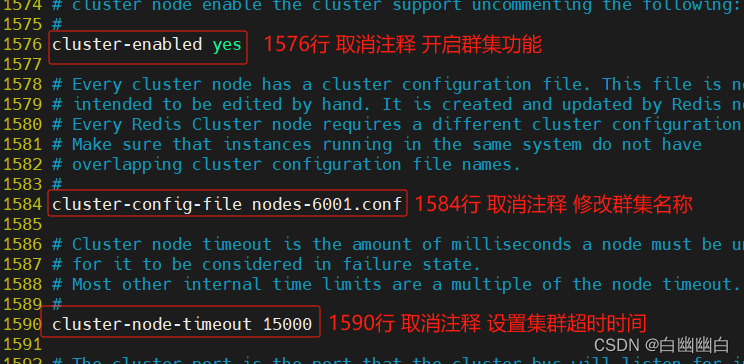

Step2 开启群集功能

其他5个文件夹的配置文件配置类似,6个端口都要不一样。

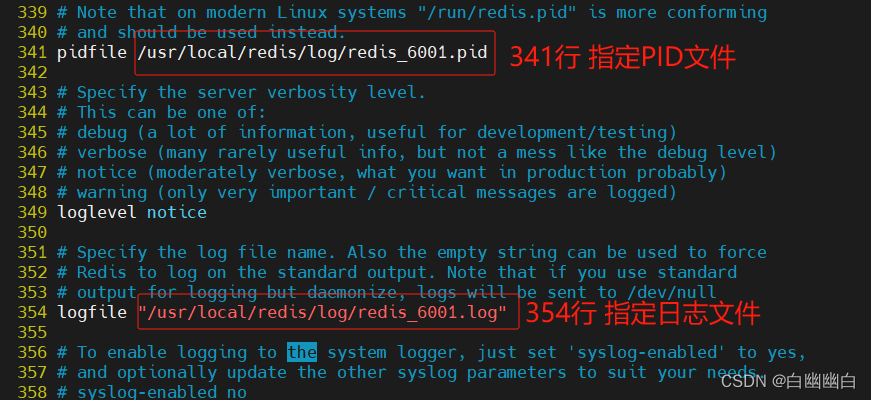

cd /usr/local/redis/redis-cluster/redis6001 vim redis.conf #bind 127.0.0.1 #87行,注释掉bind项,默认监听所有网卡 protected-mode no #111行,关闭保护模式 port 6001 #138行,修改redis监听端口 daemonize yes #309行,设置为守护进程,后台启动 pidfile /usr/local/redis/log/redis_6001.pid #341行,指定 PID 文件 logfile "/usr/local/redis/log/redis_6001.log" #354行,指定日志文件 dir ./ #504行,指定持久化文件所在目录 appendonly yes #1379行,开启AOF cluster-enabled yes #1576行,取消注释,开启群集功能 cluster-config-file nodes-6001.conf #1584行,取消注释,群集名称文件设置 cluster-node-timeout 15000 #1590行,取消注释群集超时时间设置- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

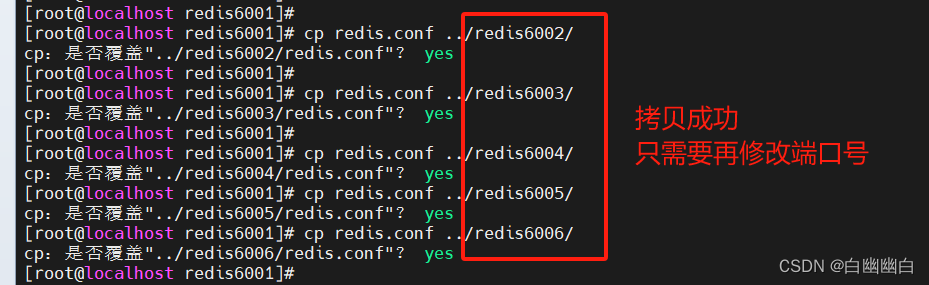

#执行5次,将6001的配置文件,分别复制给2-5 cp redis.conf ../redis6002/- 1

- 2

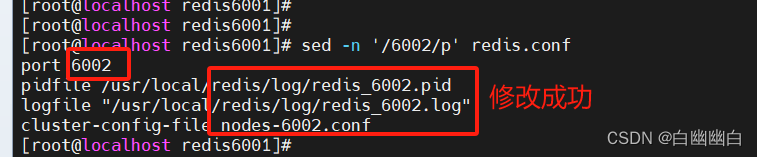

#使用sed,可以直接替换端口号,不需要用vim sed -i 's/6001/6002/' ../redis6002/redis.conf #以6002为例,其余操作相同- 1

- 2

- 3

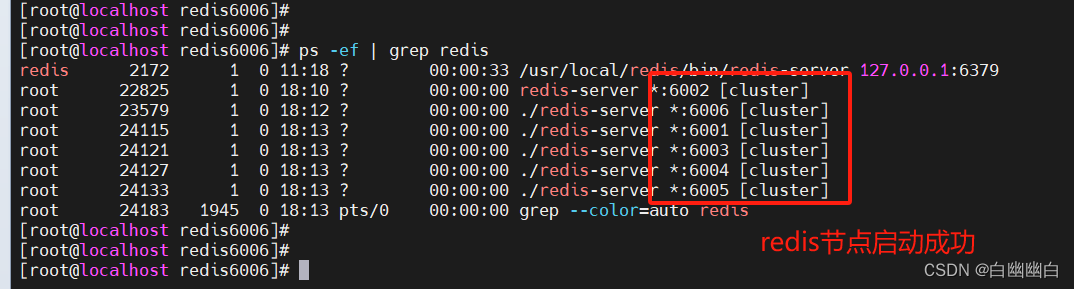

Step3 启动redis节点

分别进入那六个文件夹,执行命令:

redis-server redis.conf,来启动redis节点cd /usr/local/redis/redis-cluster/redis6001 redis-server redis.conf #从 1 到 6 的范围循环,将 $d 替换成循环变量的值 #进入对应的目录并启动 Redis 服务器 for d in {1..6} do cd /usr/local/redis/redis-cluster/redis600$d ./redis-server redis.conf done ps -ef | grep redis- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

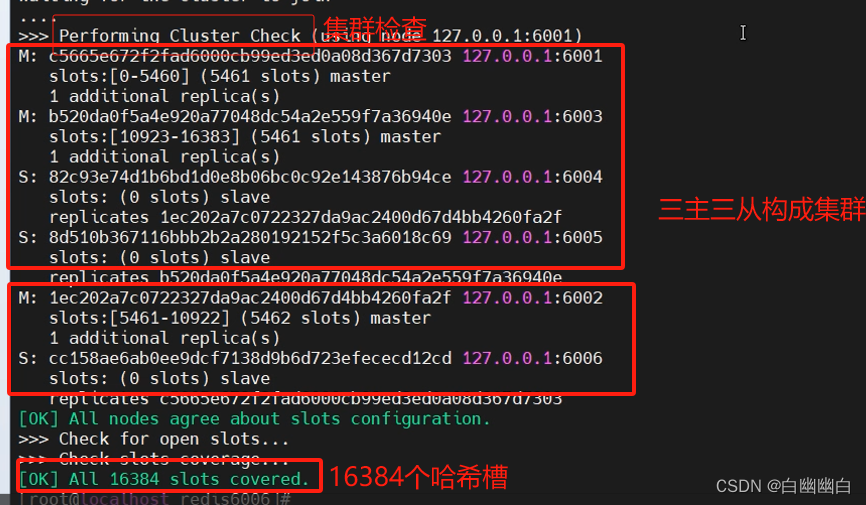

Step4 启动集群

redis-cli --cluster create 127.0.0.1:6001 127.0.0.1:6002 127.0.0.1:6003 127.0.0.1:6004 127.0.0.1:6005 127.0.0.1:6006 --cluster-replicas 1 #六个实例分为三组,每组一主一从,前面的做主节点,后面的做从节点。下面交互的时候 需要输入 yes 才可以创建。 #--replicas 1 表示每个主节点有1个从节点。- 1

- 2

- 3

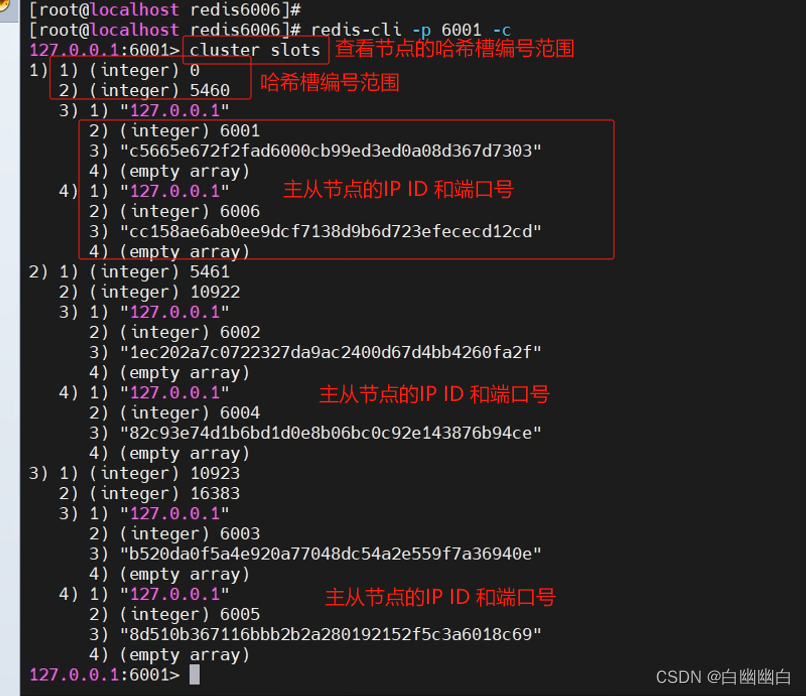

Step5 测试群集

#登录6001 redis-cli -p 6001 -c #加-c参数,节点之间就可以互相跳转 127.0.0.1:6001> cluster slots #查看节点的哈希槽编号范围- 1

- 2

- 3

- 4

- 5

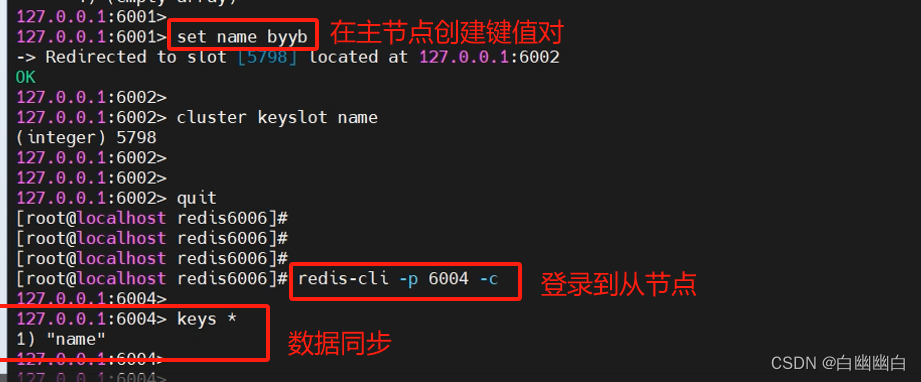

127.0.0.1:6001> set name byyb 127.0.0.1:6001> cluster keyslot name #查看name键的槽编号 redis-cli -p 6004 -c 127.0.0.1:6004> keys * #对应的slave节点也有这条数据,但是别的节点没有- 1

- 2

- 3

- 4

- 5

- 6

- 7

#连接到6001节点并获取集群中的节点信息 redis-cli -p 6001 -c cluster nodes- 1

- 2

-

-

相关阅读:

2003-2022年飞机航线信息数据

栈和队列的实现及相关面试题

Windows下hadoop单点部署

【微搭低代码】家校协同管理系统实战开发教程

LeetCode_回溯_BFS_中等_784.字母大小写全排列

磁盘阵列(RAID)级别的简单介绍

Perameter estimation for text analyse (下)

外包干了2个月,技术退步明显...

支付、结算、对账流程

哈希应用: 位图 + 布隆过滤器

- 原文地址:https://blog.csdn.net/q2524607033/article/details/133578106