-

机器学习(17)---支持向量机(SVM)

一、概述

1.1 介绍

1. 支持向量机(SVM,也称为支持向量网络),最擅长分类问题。

2.(1)从实际应用来看,SVM在各种实际问题中都表现非常优秀。它在手写识别数字和人脸识别中应用广泛,在文本和超文本的分类中举足轻重,因为SVM可以大量减少标准归纳(standard inductive)和转换设置(transductivesettings)中对标记训练实例的需求。 (2)从学术的角度来看,SVM是最接近深度学习的机器学习算法。线性SVM可以看成是神经网络的单个神经元(虽然损失函数与神经网络不同),非线性的SVM则与两层的神经网络相当,非线性的SVM中如果添加多个核函数,则可以模仿多层的神经网络。

1.2 工作原理

1. 超平面:在几何中,超平面是一个空间的子空间,它是维度比所在空间小一维的空间。 如果数据空间本身是三维的,则其超平面是二维平面;而如果数据空间本身是二维的,则其超平面是一维的直线。在二分类问题中,如果一个超平面能够将数据划分为两个集合,其中每个集合中包含单独的一个类别,我们就说这个超平面是数据的“决策边界”。

2. 先来看看下面这一组数据的分布,这是一组两种标签的数据,两种标签分别由圆和方块代表。支持向量机的分类方法,是在这组分布中找出一个超平面作为决策边界,使模型在数据上的分类误差尽量接近于小,尤其是在未知数据集上的分类误差(泛化误差)尽量小。

3. 决策边界一侧的所有点在分类为属于一个类,而另一侧的所有点分类属于另一个类。如果我们能够找出决策边界,分类问题就可以变成探讨每个样本对于决策边界而言的相对位置。比如上面的数据分布,我们很容易就可以在方块和圆的中间画出一条线,并让所有落在直线左边的样本被分类为方块,在直线右边的样本被分类为圆。如果把数据当作我们的训练集,只要直线的一边只有一种类型的数据,就没有分类错误,我们的训练误差就会为0。

4. 但是,对于一个数据集来说,让训练误差为0的决策边界可以有无数条。在此基础上,我们无法保证这条决策边界在未知数据集(测试集)上的表现也会优秀。对于现有的数据集来说,我们有B1和B2两条可能的决策边界。我们可以把决策边界B1向两边平移,直到碰到离这条决策边界最近的方块和圆圈后停下,形成两个新的超平面,分别是b11和b12。并且我们将原始的决策边界移动到b11和b12的中间,确保B1到b11和b12的距离相等。在b11和b12中间的距离,叫做 这条决策边界的边际(margin),通常记作d。

对B2也执行同样的操作,然后我们来对比一下两个决策边界。现在两条决策边界右边的数据都被判断为圆,左边的数据都被判断为方块,两条决策边界在现在的数据集上的训练误差都是0,没有一个样本被分错。

5. 我们引入和原本的数据集相同分布的测试样本(红色所示),平面中的样本变多了,此时我们可以发现,对于B1而言,依然没有一个样本被分错,这条决策边界上的泛化误差也是0。但是对于B2而言,却有三个方块被误分类成了圆,二有两个圆被误分类成了方块,这条决策边界上的泛化误差就远远大于B1了。这个例子表现出,拥有更大边际的决策边界在分类中的泛化误差更小,这一点可以由结构风险最小化定律来证明(SRM)。如果边际很小,则任何轻微扰动都会对决策边界的分类产生很大的影响。边际很小的情况,是一种模型在训练集上表现很好,却在测试集上表现糟糕的情况,所以会“过拟合”。所以我们在找寻决策边界的时候,希望边际越大越好。

6. 支持向量机,就是通过找出边际最大的决策边界,来对数据进行分类的分类器。也因此,支持向量分类器又叫做最大边际分类器。这个过程在二维平面中看起来十分简单,但将上述过程使用数学表达出来,就不是一件简单的事情了。

1.3 三层理解

二、sklearn.svm.SVC

2.1 查看数据集

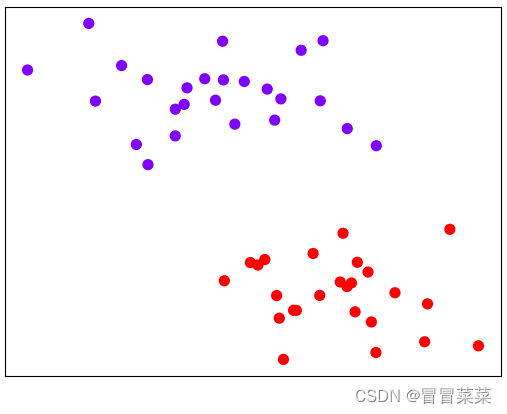

from sklearn.datasets import make_blobs #生成聚类数据集 from sklearn.svm import SVC import matplotlib.pyplot as plt import numpy as np x,y=make_blobs(n_samples=100,centers=2,random_state=0,cluster_std=0.6) plt.scatter(x[:,0],x[:,1],c=y,s=50,cmap='rainbow') plt.show()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

2.2 contour函数

1. 函数:

matplotlib.axes.Axes.contour([X, Y,] Z, [levels], **kwargs)。2. Contour是我们专门用来绘制等高线的函数。等高线,本质上是在二维图像上表现三维图像的一种形式,其中两维X和Y是两条坐标轴上的取值,而Z表示高度。Contour就是将由X和Y构成平面上的所有点中,高度一致的点连接成线段的函数,在同一条等高线上的点一定具有相同的Z值。我们可以利用这个性质来绘制我们的决策边界。

参数 含义 X和Y 选填。两维平面上所有的点的横纵坐标取值,一般要求是二维结构并且形状需要与Z相同,往往通过numpy.meshgrid()这样的函数来创建。如果X和Y都是一维,则Z的结构必须为(len(Y), len(X))。如果不填写,则默认X = range(Z.shape[1]),Y = range(Z.shape[0])。 Z 必填。平面上所有的点所对应的高度。 levels 可不填,不填默认显示所有的等高线,填写用于确定等高线的数量和位置。如果填写整数n,则显示n个数据区间,即绘制n+1条等高线。水平高度自动选择。如果填写的是数组或列表,则在指定的高度级别绘制等高线。列表或数组中的值必须按递增顺序排列。 2.3 画决策边界:制作网格

ax = plt.gca() xlim = ax.get_xlim() # 返回上面图的x轴的最小值和最大值 ylim = ax.get_ylim() # 返回上面图的y轴的最小值和最大值 # print(xlim,ylim) #(-0.7425578984849813, 3.3721920271976598) (-0.41872382476349596, 5.754870487889891) axisx = np.linspace(xlim[0], xlim[1], 30) # 根据xlim和ylim绘制网格点 axisy = np.linspace(ylim[0], ylim[1], 30) print(axisx, axisy) axisx, axisy = np.meshgrid(axisx, axisy) # 将axisx和axisy分别向y轴和x轴进行扩充(广播) xy = np.vstack([axisx.ravel(), axisy.ravel()]).T # 扩充为30*30的坐标点,后面基于这900个点绘制决策边界 plt.scatter(xy[:, 0], xy[:, 1], s=1, cmap="rainbow") plt.show()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

2.4 建模画图

clf=SVC(kernel='linear').fit(x,y) #建模 z=clf.decision_function(xy).reshape(axisx.shape) #每个样本所对应的到决策边界的距离 def plot_svc_decision_funtion(model, ax=None): if ax is None: ax = plt.gca() xlim = ax.get_xlim() ylim = ax.get_ylim() x = np.linspace(xlim[0], xlim[1], 30) y = np.linspace(ylim[0], ylim[1], 30) y, x = np.meshgrid(y, x) xy = np.vstack([x.ravel(), y.ravel()]).T P = model.decision_function(xy).reshape(x.shape) ax.contour(x, y, P, colors='k', levels=[-1, 0, 1], alpha=0.5, linestyles=['--', '-', '--']) ax.set_xlim(xlim) ax.set_ylim(ylim) plt.show() plt.scatter(x[:,0],x[:,1],c=y,s=50,cmap='rainbow') plot_svc_decision_funtion(clf)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

三、非线性情况推广

3.1 查看数据集

from sklearn.datasets import make_circles from sklearn.svm import SVC import matplotlib.pyplot as plt import numpy as np X,y = make_circles(100, factor=0.1, noise=.1) plt.scatter(X[:,0],X[:,1],c=y,s=50,cmap="rainbow") plt.show()- 1

- 2

- 3

- 4

- 5

- 6

- 7

3.2 线性画图

明显,现在线性SVM已经不适合于我们的状况了,我们无法找出一条直线来划分我们的数据集,让直线的两边分别是两种类别。这个时候,如果我们能够在原本的X和y的基础上,添加一个维度r,变成三维,我们再可视化这个数据,来看看添加维度让我们的数据如何变化。

def plot_svc_decision_function(model, ax=None): if ax is None: ax = plt.gca() xlim = ax.get_xlim() ylim = ax.get_ylim() x = np.linspace(xlim[0], xlim[1], 30) y = np.linspace(ylim[0], ylim[1], 30) y, x = np.meshgrid(y, x) xy = np.vstack([x.ravel(), y.ravel()]).T P = model.decision_function(xy).reshape(x.shape) ax.contour(x, y, P, colors='k', levels=[-1, 0, 1], alpha=0.5, linestyles=['--', '-', '--']) ax.set_xlim(xlim) ax.set_ylim(ylim) plt.show() clf = SVC(kernel = "linear").fit(X,y) plt.scatter(X[:,0],X[:,1],c=y,s=50,cmap="rainbow") plot_svc_decision_function(clf)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

3.3 为非线性数据增加维度并绘制3D图像

r = np.exp(-(X**2).sum(1)) rlim = np.linspace(min(r),max(r),1) def plot_3D(elev=30,azim=30,X=X,y=y): ax = plt.subplot(projection="3d") ax.scatter3D(X[:,0],X[:,1],r,c=y,s=50,cmap='rainbow') ax.view_init(elev=elev,azim=azim) ax.set_xlabel("x") ax.set_ylabel("y") ax.set_zlabel("r") plt.show() plot_3D()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

四、核函数

1. 是一种能够使用数据原始空间中的向量计算来表示升维后的空间中的点积结果的数学方式。具体表现为:

2. 核函数确保了高维空间中任意两个向量的点积一定可以被低维空间中的这两个向量的某种计算来表示(多数时候是点积的某种变换)。选用不同的核函数,就可以解决不同数据分布下的寻找超平面问题。在SVC中,这个功能由参数“kernel”和一系列与核函数相关的参数来进行控制。之前的代码中我们一直使用这个参数并输入"linear"。参数“kernel"在sklearn中可选以下几种选项:

3. 使用其它的核函数画决策边界:

clf = SVC(kernel = "rbf").fit(X,y) plt.scatter(X[:,0],X[:,1],c=y,s=50,cmap="rainbow") plot_svc_decision_function(clf)- 1

- 2

- 3

-

相关阅读:

class类的常用基础用法

B2B企业如何做好谷歌Google广告推广营销布局?

Tomcat下载安装以及配置(详细教程)

JAVA 递归算法- 椰子汁5元一瓶,4个盖子可以换一瓶椰子汁,3个空瓶可以换一瓶椰子汁,那么 100 块钱可以喝多少瓶椰子汁,剩下瓶盖和空瓶各多少?

RabbitMQ简介

stdmap和stdmultimap的使用总结

对于Oracle,MySQL,SQL Server重复数据删除

全网最全Python系列教程(非常详细)---字符串讲解(学Python入门必收藏)

【ManageEngine卓豪 】助力世界顶尖音乐学院--茱莉亚学院,提升终端安全

STM32CUBEMX开发GD32F303(7)----配置printf

- 原文地址:https://blog.csdn.net/m0_62881487/article/details/132940522