-

大模型对外提供应用的三种服务方式及示例

最近在研究Llama大模型的本地化部署和应用测试过程中,为了给大家提供更多的应用方式,研究了如何利用python快速搭建各种应用访问服务,一般来说,我们开发完成的软件模块为了体现价值,都需要对外提供服务,最原始的方式就是将源码或编译好的类库提供给需要使用的客户进行引入使用,但对于大模型的应用来说,这种方式显然不行,一个是由于模型太大,需要更多的存储资源和计算资源等,客户侧一般没有相应的资源,一个是由于部署运行环境的复杂性和可运维性,导致这种应用方式的成功率和可移植性较低,因此,目前比较多的是以下三种方式,主要有终端Terminal、Web应用服务和Rest服务等。下面就逐个举例说明。

一、终端Terminal服务

这种方式需要在客户端安装相应的Terminal工具,比如putty,xterm等,同时需要给客户开放bash用户,并将需要执行的服务打包成sh命令或python命令,存放到用户的env下,否则会找不到命令,但这种方式的优点是软件模块对应的服务返回直接迅速,基本不延迟,用户很快能拿到相应的信息,但只能手动或半自动化操作使用。大模型预测的示例如下

运行命令:python llama2Test2.py Chinese-Llama-2

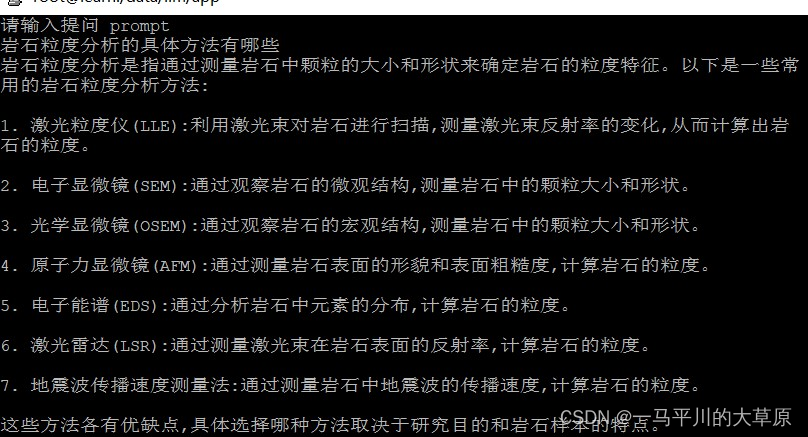

输出结果:大模型服务会根据用户的prompt反馈相应结果,详见下图。

二、Web应用服务

这种方式对客户的要求最低,耦合性最小,特别是面向那种初级用户来说&#

-

相关阅读:

数据库访问中间件--springdata-jpa的基本使用

element的tabs组件使用问题解决

【服务器数据恢复】戴尔某型号服务器raid故障的数据恢复案例

dirsearch网站目录暴力破解

NGS基础---Plink文件格式ped/map和bed/bim/fam

tx.origin 与 msg.sender

bclinux aarch64 ceph 14.2.10 云主机 4节点 fio

一文带你玩转offer-01

Xml转json

docker创建镜像

- 原文地址:https://blog.csdn.net/hhue2007/article/details/132868501