-

Stable Diffuse AI 绘画 之 ControlNet 插件及其对应模型的下载安装

Stable Diffuse AI 绘画 之 ControlNet 插件及其对应模型的下载安装

目录

Stable Diffuse AI 绘画 之 ControlNet 插件及其对应模型的下载安装

一、简单介绍

Stable Diffusion是一个文本到图像的潜在扩散模型,由CompVis、Stability AI和LAION的研究人员和工程师创建。它使用来自LAION-5B数据库子集的512x512图像进行训练。使用这个模型,可以生成包括人脸在内的任何图像,因为有开源的预训练模型,所以我们也可以在自己的机器上运行它,如下图所示。

Stable Diffusion 是一个AI 绘图软件 (开源模型),可本地部署,可切换多种模型,且新的模型和开源库每天都在更新发布,最重要的是免费,没有绘图次数限制。

Github 网址:GitHub - AUTOMATIC1111/stable-diffusion-webui: Stable Diffusion web UI

玩 Stable Diffusion,就一定要会玩 ControlNet,它是 Stable Diffusion 一个非常重要的扩展插件(sd-webui-controlnet),它不仅可以用来复制构图和人体姿势,还有其他很多强大的功能,要使用 ControlNet(sd-webui-controlnet),就必须先要学会怎么安装它。

ControlNet github 地址:https://github.com/lllyasviel/ControlNet

ControlNet-v1-1-nightly github 地址:https://github.com/lllyasviel/ControlNet-v1-1-nightly

sd-webui-controlnet

github 地址:https://github.com/Mikubill/sd-webui-controlnet

通过上面的方式,ControlNet 可以重用SD编码器作为一个深度,强,鲁棒和强大的骨干来学习不同的控制。许多证据(像这个和这个)验证了SD编码器是一个优秀的骨干。

注意,我们连接层的方式是计算效率高的。原始SD编码器不需要存储梯度(锁定的原始SD编码器块1234和Middle)。所需的GPU内存并不比原来的SD大多少,尽管增加了许多层。

所有的模型和检测器都可以从 our Hugging Face page下载。确保SD模型放在“ControlNet/models”中,检测器放在“ControlNet/annotator/ckpts”中。确保从 our Hugging Face page下载了所有必要的预训练权重和检测器模型,包括HED边缘检测模型、Midas深度估计模型、Openpose等等。

二、ControlNet 插件下载安装

1、运行 Stable Diffuse WebUI ,打开网页,找到扩展-可用-点击加载自,会出现很多可用的扩展插件

注意:这里可能需要魔法上网

2、“Ctrl+F” 搜索 ControlNet ,查找 ControlNet 插件,点击安装

3、安装好后,即可在扩展-已安装中找到 ControlNet 插件

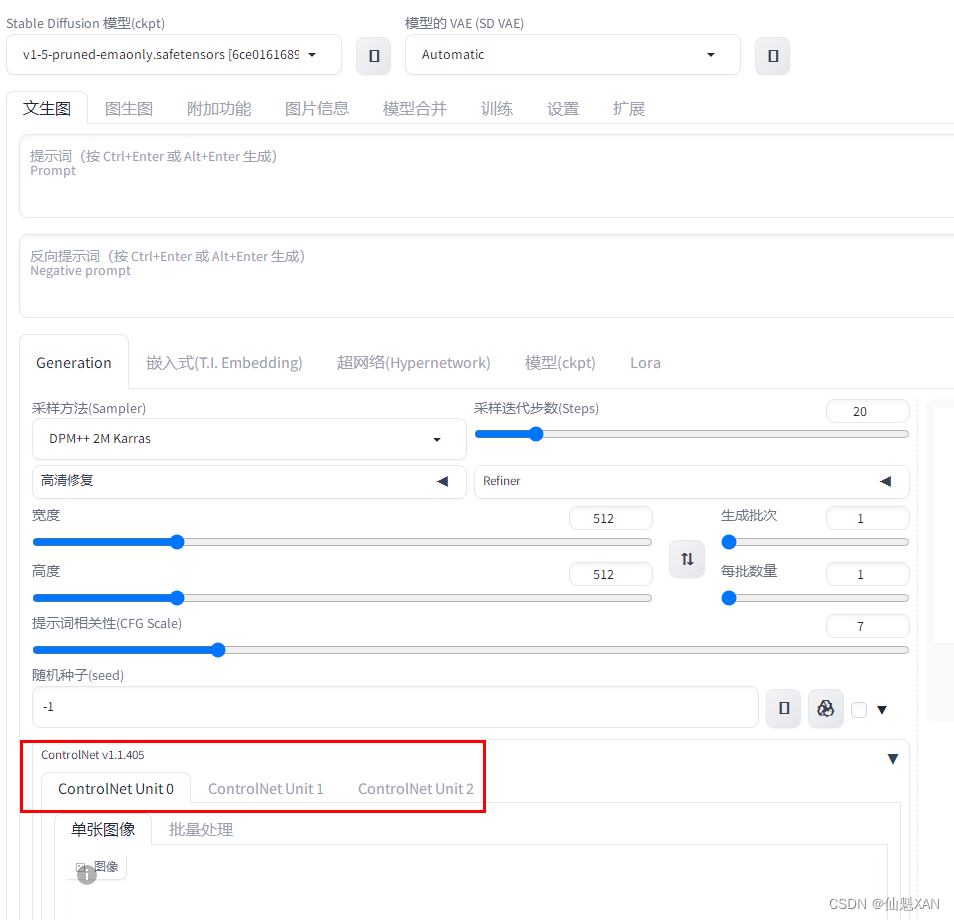

4、ControlNet 插件勾选上,然后点击应用并重启用户界面,界面重启后,就可以看到 ControlNet 相关操作界面

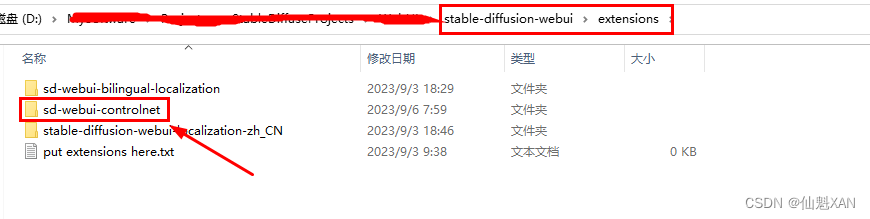

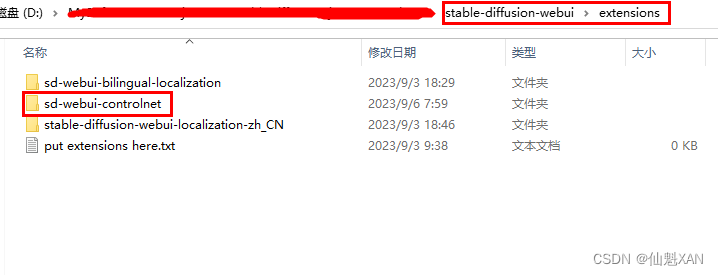

5、在extensions 文件夹即可看到 ControlNet插件文件夹

三、ControlNet 插件模型下载安装

1、在 hugging face 找到 ControlNet 插件下载地址

ControlNet 插件模型网址:lllyasviel/ControlNet-v1-1 at main

2、模型名称的说明,有些模型可用和不可用,以及测试中

在下载的时候要注意文件名中"V11"后面的字母,p:表示可以使用,e:表示还在试验中,u:表示未完成,如果是文件名中的字母是e,就不要下载

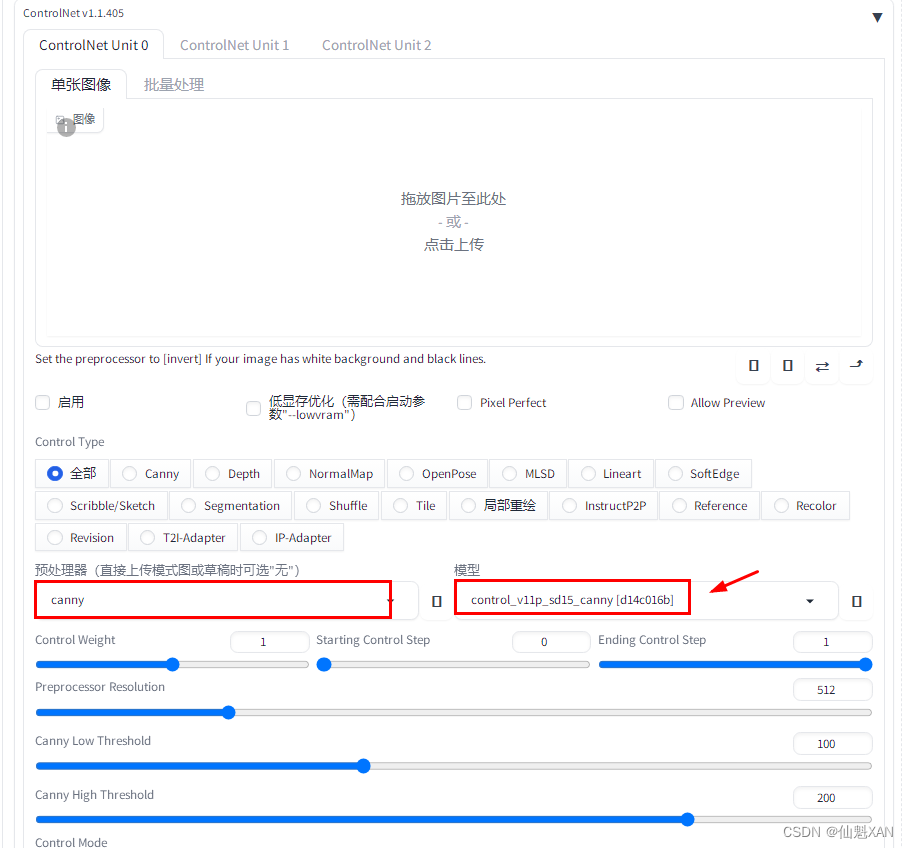

3、模型还是较大的,根据自己需要酌情下载,这里以 canny 为例

注意:对应模型的.pth 和 .yaml 文件都要下载

4、下载好后的模型,放到之前安装好后的 ControlNet 插件文件夹

5、重启界面

6、对应的模型,就可以找到

7、自己去试试吧

四、ControlNet 插件其他的下载安装方式

1、可以在 Github 上拷贝 ControlNet 插件 的 git 地址,然后在 扩展-从网址安装 进行安装

ControlNet 插件 GitHub地址:https://github.com/Mikubill/sd-webui-controlnet

2、可以在 Github 上拷贝 ControlNet 插件 的 git 地址,然后在 git clone 进行安装

注意:在 xxxx\xxxx\stable-diffusion-webui\extensions 文件夹进行克隆

3、可以在 Github 下载 ControlNet 插件包,解压到 xxxx\xxxx\stable-diffusion-webui\extensions 文件夹下

五、ControlNet 插件模型名称说明

-

相关阅读:

洪泛法:计算机网络中的信息洪流——原理、优化与应用全景解析

基于ansible部署lamp架构(源码安装)

深度学习对 MRI 进行分类

2022最新版-李宏毅机器学习深度学习课程-P51 BERT的各种变体

python 引用、浅拷贝、深拷贝

SSH是如何配置的

基于PB的企业人力资源信息系统设计与实现

SpringBoot基础入门

C/C++语言100题练习计划 90——10 进制转 x 进制(进制转换实现)

1325_FreeRTOS队列发送函数的实现分析

- 原文地址:https://blog.csdn.net/u014361280/article/details/132702460