-

ElasticSearch 数据迁移工具elasticdump

ElasticSearch 数据迁移工具elasticdump

Elasticdump 是一个用于导入和导出 Elasticsearch 数据的命令行工具。它提供了一种方便的方式来在不同的 Elasticsearch 实例之间传输数据,或者进行数据备份和恢复。

使用 Elasticdump,你可以将 Elasticsearch 索引中的数据导出为 JSON 文件,或者将 JSON 文件中的数据导入到 Elasticsearch 索引中。它支持各种选项和过滤器,用于指定源和目标,包括索引模式、文档类型、查询过滤器等等。

主要特征包括

- 支持在Elasticsearch实例或者集群之间传输和备份数据。可以将数据从一个集群复制到另一个集群。

- 支持不同格式的数据传输,包括JSON、NDJSON、CSV、备份文件等。

- 可以通过命令行或者程序化的方式使用。命令行方式提供了便捷的操作接口。

- 支持增量式同步,只复制目标集群中不存在的文档。

- 支持各种认证方式连接Elasticsearch,如basic auth、Amazon IAM等。

- 支持多线程操作,可以加快数据迁移的速度。

- 开源免费,代码托管在GitHub上。

一、安装node

首先获取安装包

wget https://nodejs.org/dist/v16.14.0/node-v16.14.0-linux-x64.tar.xz tar axf node-v16.14.0-linux-x64.tar.xz -C /usr/local/ mv /usr/local/node-v16.14.0-linux-x64 /usr/local/node- 1

- 2

- 3

然后配置环境变量

vim /etc/profile export NODE_HOME=/usr/local/node export PATH=$NODE_HOME/bin:$PATH- 1

- 2

- 3

接下来刷新环境变量,然后测试一下安装是否完成

source /etc/profile node -v npm -v- 1

- 2

- 3

如果是mac 的话可以使用

brew安装brew install node@16- 1

二、在线安装elasticdump

执行下面的命令安装

npm install elasticdump -g- 1

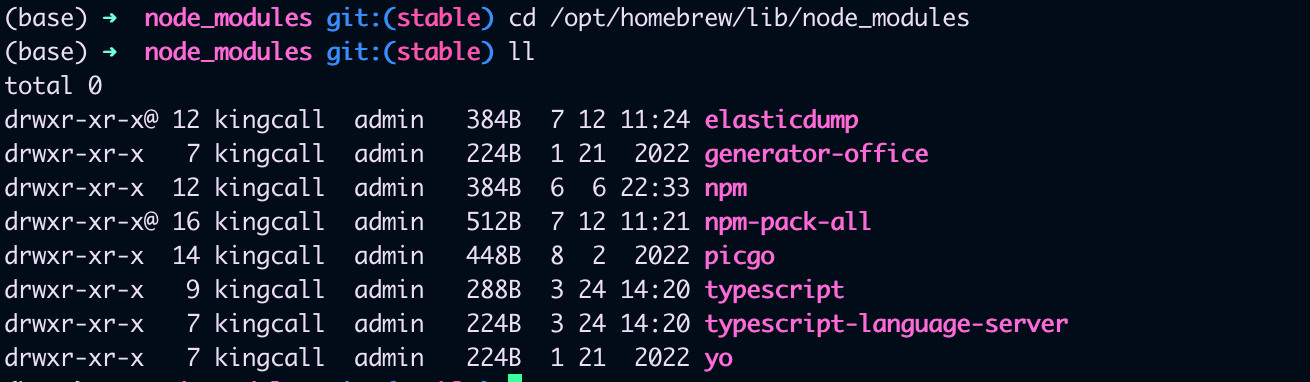

使用下面的命令查看安装目录

npm root -g- 1

我的位置在这里

/opt/homebrew/lib/node_modules

三、离装elasticdump

这里的原理是将node安装包和elasticdump安装报复制到需要离线安装的服务器。

- 获取node 的离线安装包进行安装即可,参考第一步

- 获取elasticdump的安装包安装,所以我们首选需要一个打包工具

npm install -g npm-pack-all- 1

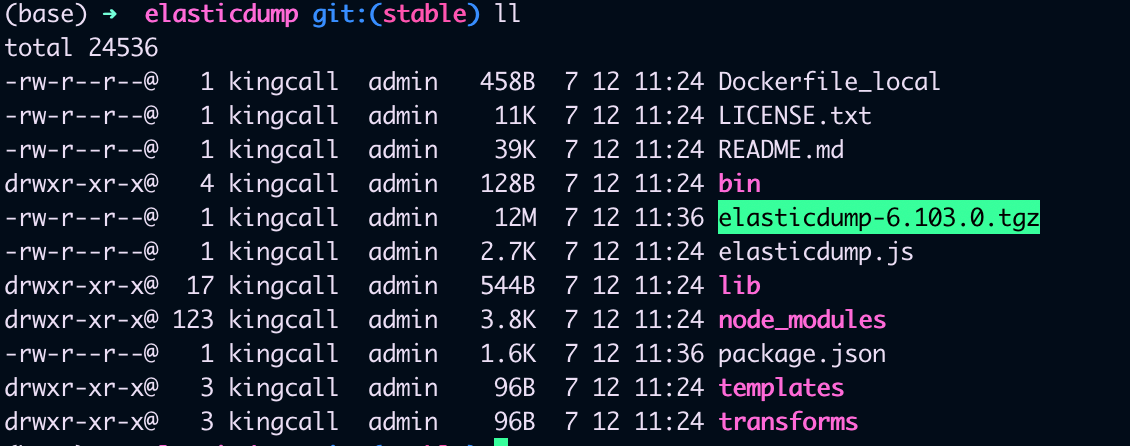

然后我们切换到上面elasticdump的安装路,打包elasticdump,会在当前目录生成

elasticdump-6.103.0.tgz这样一个压缩包,这就是我们离线安装需要的包cd /opt/homebrew/lib/node_modules/elasticdump/ npm-pack-all- 1

- 2

到这里我们看到离线包已经生成好了,接下来我们复制到我们之前已经安装好node 的机器上,执行下面的命令

npm install elasticdump-6.103.0.tgz- 1

后面为了方便使用,我们可以配置一下elasticdump的环境变量

vim ~/.bashrc # 追加以下内容 #node export DUMP_HOME=/opt/homebrew/lib/node_modules/elasticdump/ export PATH=$DUMP_HOME/bin:$PATH # 刷新 source ~/.bashrc- 1

- 2

- 3

- 4

- 5

- 6

- 7

四、使用elasticdump

这里的使用主要分为两种,一种是数据备份,一种是数据迁移

- 备份主要指的是生成备份的数据文件,在需要的时候进行还原

- 数据迁移是指将原来索引里的数据迁移到新的索引

其实数据备份也能达到数据迁移的目的,但是在两个环境的网络不通的时候我们只能使用数据备份

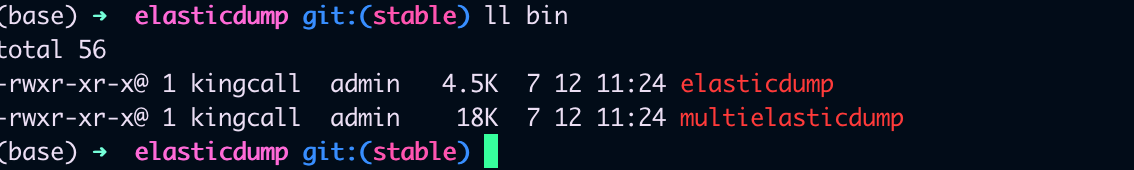

我们安装成功后,在elasticdump的bin目录下其实有两个工具,一个是

elasticdump另外一个是multielasticdump

数据迁移

迁移索引

elasticdump \ --input=http://192.168.1.140:9200/source_index \ --output=http://192.168.1.141:9200/target_index \ --type=mapping- 1

- 2

- 3

- 4

迁移数据

elasticdump \ --input=http://192.168.1.140:9200/source_index \ --output=http://192.168.1.141:9200/target_index \ --type=data \ --limit=2000 # 每次操作的objects数量,默认100,数据量大的话,可以调大加快迁移速度- 1

- 2

- 3

- 4

- 5

这个命令会将源 Elasticsearch 实例中的 “my_index” 索引的所有数据导出,并保存到 “/path/to/output.json” 的 JSON 文件中。

--input:指定输入的 Elasticsearch 实例和索引。可以是一个 URL,也可以是本地 Elasticsearch 实例的路径。--output:指定输出的文件路径,数据将保存为一个 JSON 文件。--type:指定要导出的数据类型,通常为 “data” 表示文档数据。

你还可以使用其他选项来进一步控制导出过程,如

--query,--size,--limit,--filter等,具体取决于你的需求。可以通过运行elasticdump --help命令来数据备份

导出索引和数据

elasticdump \ --input=http://192.168.1.140:9200/source_index \ --output=/data/source_index_mapping.json \ --type=mapping elasticdump \ --input=http://192.168.1.140:9200/source_index \ --output=/data/source_index.json \ --type=data \ --limit=2000- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

导入索引和数据

elasticdump \ --input=/data/source_index_mapping.json \ --output=http://192.168.1.141:9200/source_index \ --type=mapping elasticdump \ --input=/data/source_index.json \ --output=http://192.168.1.141:9200/source_index \ --type=data \ --limit=2000- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

其他用法

还有其他使用的细节,例如压缩,指定query 什么的,我们可以参考下面的例子

# Copy an index from production to staging with analyzer and mapping: elasticdump \ --input=http://production.es.com:9200/my_index \ --output=http://staging.es.com:9200/my_index \ --type=analyzer elasticdump \ --input=http://production.es.com:9200/my_index \ --output=http://staging.es.com:9200/my_index \ --type=mapping elasticdump \ --input=http://production.es.com:9200/my_index \ --output=http://staging.es.com:9200/my_index \ --type=data # Backup index data to a file: elasticdump \ --input=http://production.es.com:9200/my_index \ --output=/data/my_index_mapping.json \ --type=mapping elasticdump \ --input=http://production.es.com:9200/my_index \ --output=/data/my_index.json \ --type=data # Backup and index to a gzip using stdout: elasticdump \ --input=http://production.es.com:9200/my_index \ --output=$ \ | gzip > /data/my_index.json.gz # Backup the results of a query to a file elasticdump \ --input=http://production.es.com:9200/my_index \ --output=query.json \ --searchBody="{\"query\":{\"term\":{\"username\": \"admin\"}}}" # Specify searchBody from a file elasticdump \ --input=http://production.es.com:9200/my_index \ --output=query.json \ --searchBody=@/data/searchbody.json # Copy a single shard data: elasticdump \ --input=http://es.com:9200/api \ --output=http://es.com:9200/api2 \ --input-params="{\"preference\":\"_shards:0\"}" # Backup aliases to a file elasticdump \ --input=http://es.com:9200/index-name/alias-filter \ --output=alias.json \ --type=alias # Import aliases into ES elasticdump \ --input=./alias.json \ --output=http://es.com:9200 \ --type=alias # Backup templates to a file elasticdump \ --input=http://es.com:9200/template-filter \ --output=templates.json \ --type=template # Import templates into ES elasticdump \ --input=./templates.json \ --output=http://es.com:9200 \ --type=template # Split files into multiple parts elasticdump \ --input=http://production.es.com:9200/my_index \ --output=/data/my_index.json \ --fileSize=10mb # Import data from S3 into ES (using s3urls) elasticdump \ --s3AccessKeyId "${access_key_id}" \ --s3SecretAccessKey "${access_key_secret}" \ --input "s3://${bucket_name}/${file_name}.json" \ --output=http://production.es.com:9200/my_index # Export ES data to S3 (using s3urls) elasticdump \ --s3AccessKeyId "${access_key_id}" \ --s3SecretAccessKey "${access_key_secret}" \ --input=http://production.es.com:9200/my_index \ --output "s3://${bucket_name}/${file_name}.json" # Import data from MINIO (s3 compatible) into ES (using s3urls) elasticdump \ --s3AccessKeyId "${access_key_id}" \ --s3SecretAccessKey "${access_key_secret}" \ --input "s3://${bucket_name}/${file_name}.json" \ --output=http://production.es.com:9200/my_index --s3ForcePathStyle true --s3Endpoint https://production.minio.co # Export ES data to MINIO (s3 compatible) (using s3urls) elasticdump \ --s3AccessKeyId "${access_key_id}" \ --s3SecretAccessKey "${access_key_secret}" \ --input=http://production.es.com:9200/my_index \ --output "s3://${bucket_name}/${file_name}.json" --s3ForcePathStyle true --s3Endpoint https://production.minio.co # Import data from CSV file into ES (using csvurls) elasticdump \ # csv:// prefix must be included to allow parsing of csv files # --input "csv://${file_path}.csv" \ --input "csv:///data/cars.csv" --output=http://production.es.com:9200/my_index \ --csvSkipRows 1 # used to skip parsed rows (this does not include the headers row) --csvDelimiter ";" # default csvDelimiter is ','- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

- 105

- 106

- 107

- 108

- 109

- 110

- 111

- 112

- 113

- 114

- 115

- 116

- 117

- 118

- 119

常用参数

--direction dump/load 导出/导入 --ignoreType 被忽略的类型,data,mapping,analyzer,alias,settings,template --includeType 包含的类型,data,mapping,analyzer,alias,settings,template --suffix 加前缀,es6-${index} --prefix 加后缀,${index}-backup-2018-03-13- 1

- 2

- 3

- 4

- 5

总结

elasticdump是ElasticSearch提供的一个工具,我们主要可以用来完成

- 数据备份

- 数据迁移

这一节我们主要介绍了elasticdump的安装和使用,还有就是,Elasticdump 是一个第三方工具,不是官方的 Elasticsearch 产品。虽然它对某些用例很有帮助,但在使用之前,确保与你的 Elasticsearch 版本兼容,并查阅工具的文档以了解任何特定的注意事项或限制。

总体来说,elasticdump是一个非常实用的数据迁移和备份工具。它可以帮助我们轻松地在不同Elasticsearch集群之间进行数据迁移,实现集群之间的无缝数据同步。

-

相关阅读:

这可能是你需要的vue考点梳理

CSDN21天学习挑战赛——计划导航

邻接表存储二叉树

Vue3 企业级优雅实战 - 组件库框架 - 8 搭建组件库 cli

力扣—最长回文子串

YOLOV5----修改损失函数-ShuffleAttention

flink sql 毫秒转date ms转date

树莓派官方系统自带的gpiozero库教程

css知识

Mysql中MyISAM和InnoDB 引擎的区别

- 原文地址:https://blog.csdn.net/king14bhhb/article/details/131716101