-

redis三(3-2)

传统缓存的问题

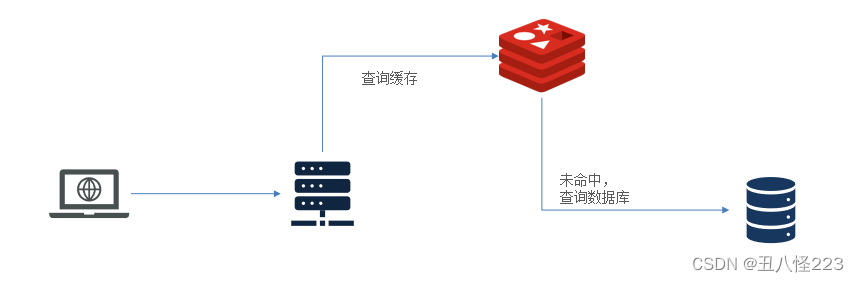

传统的缓存策略一般是请求到达Tomcat后,先查询Redis,如果未命中则查询数据库,存在下面的问题:

- 请求要经过Tomcat处理,Tomcat的性能成为整个系统的瓶颈

- Redis缓存失效时,会对数据库产生冲击

多级缓存方案

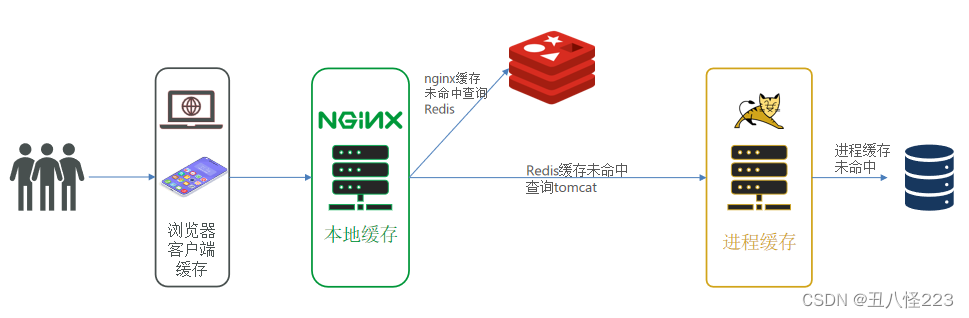

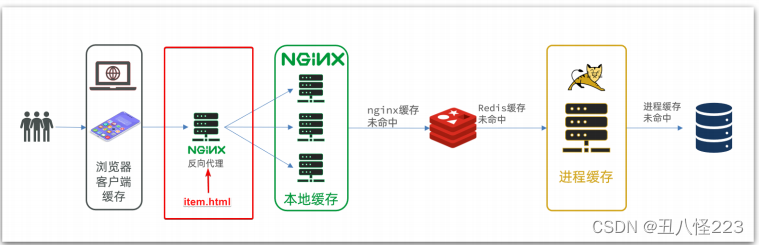

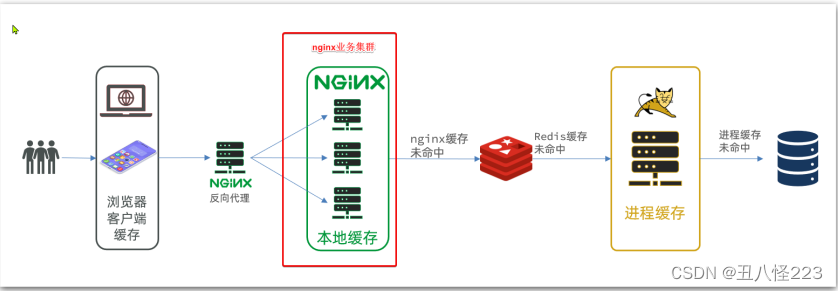

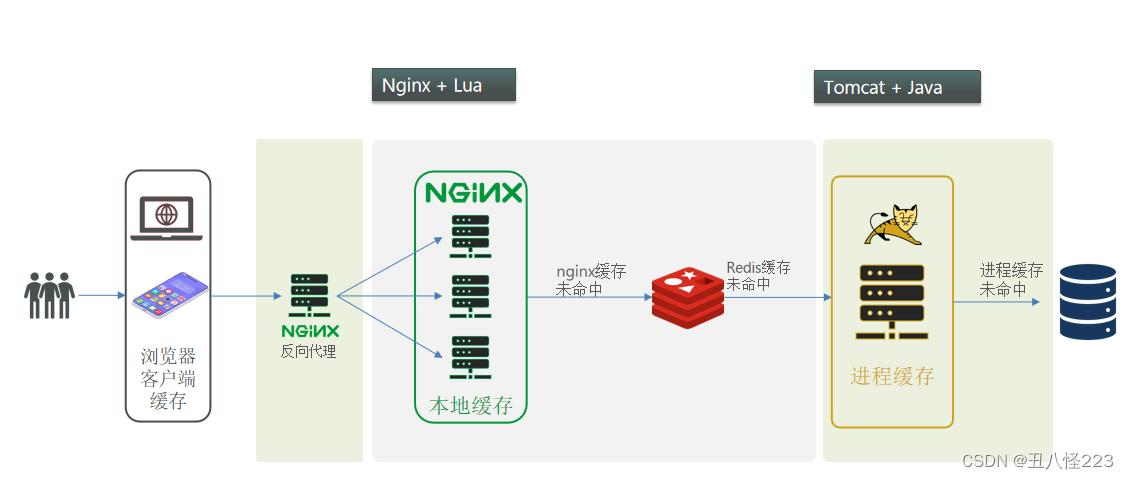

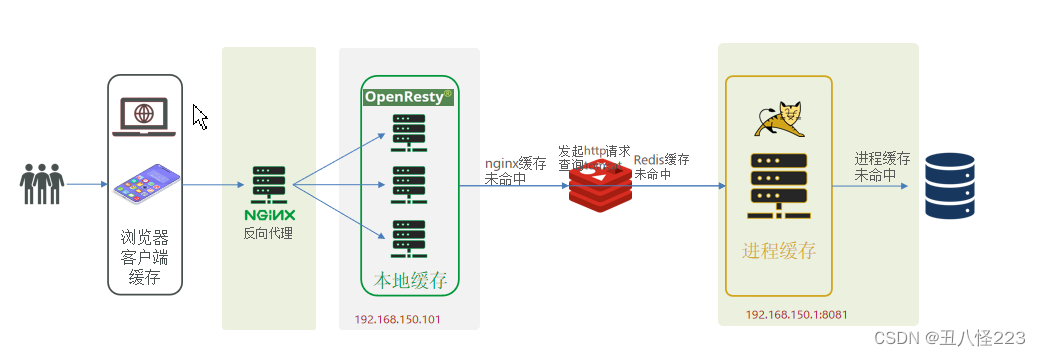

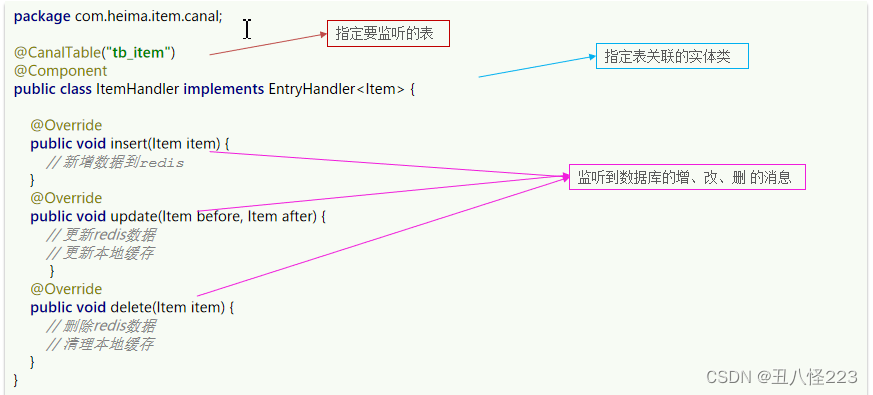

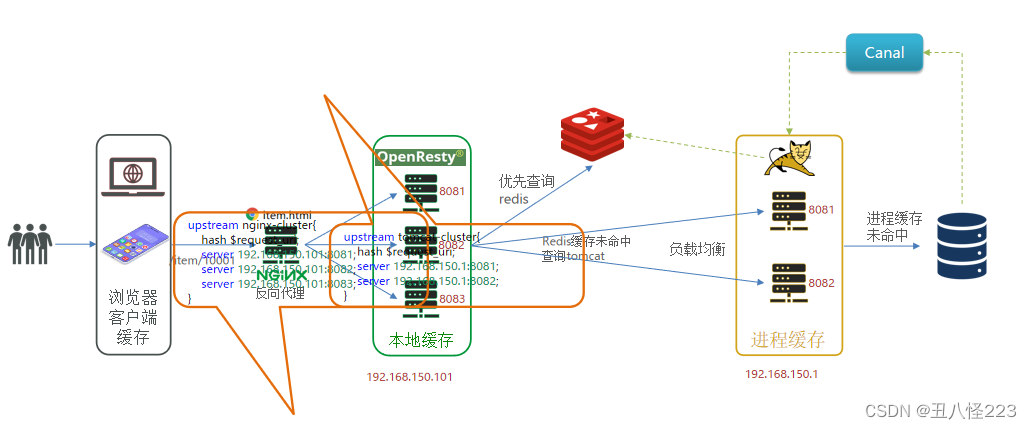

多级缓存就是充分利用请求处理的每个环节,分别添加缓存,减轻 Tomcat 压力,提升服务性能:- 浏览器访问静态资源时,优先读取浏览器本地缓存

- 访问非静态资源(ajax查询数据)时,访问服务端

- 请求到达Nginx后,优先读取Nginx本地缓存

- 如果Nginx本地缓存未命中,则去直接查询Redis(不经过Tomcat)

- 如果Redis查询未命中,则查询Tomcat

- 请求进入Tomcat后,优先查询JVM进程缓存

- 如果JVM进程缓存未命中,则查询数据库

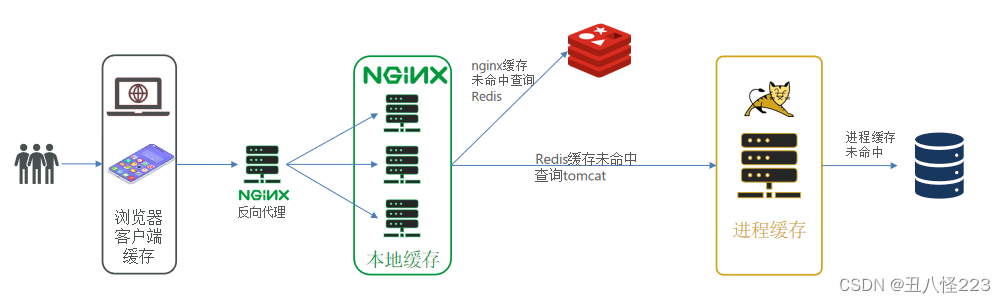

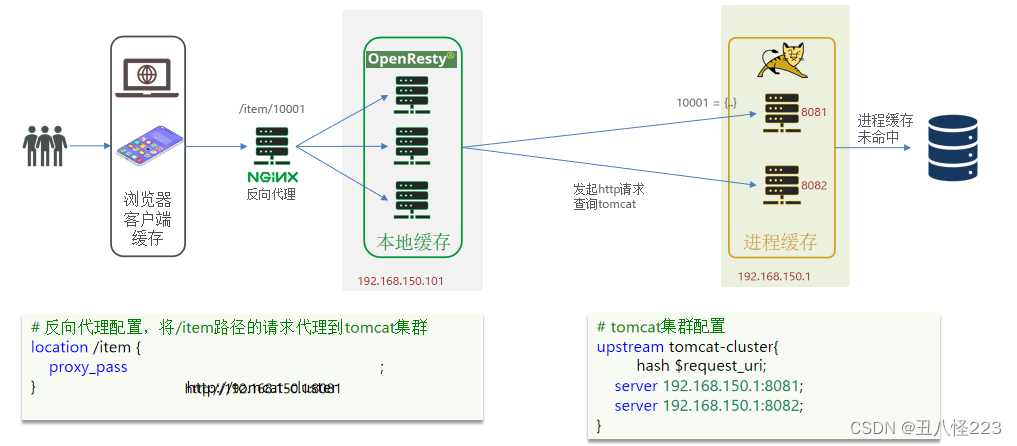

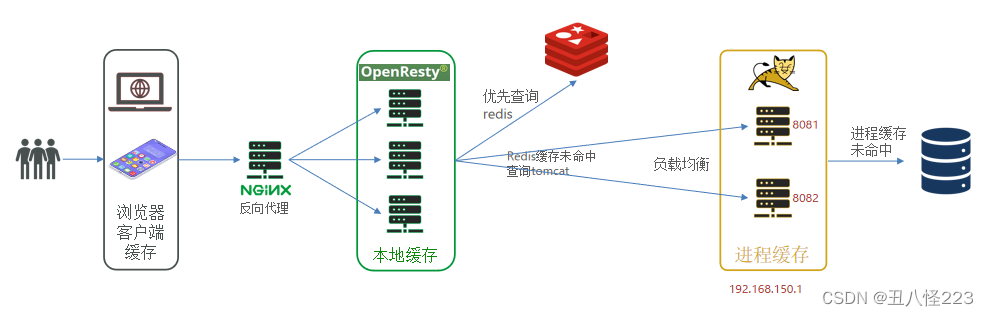

在多级缓存架构中, Nginx 内部需要编写本地缓存查询、 Redis 查询、 Tomcat 查询的业务逻辑,因此这样的 nginx 服务不再是一个反向代理服务器 ,而是一个编写 业务的 Web 服务器了 。因此这样的业务 Nginx 服务也需要搭建集群来提高并发,再有专门的 nginx 服务来做反向代理,如图:

在多级缓存架构中, Nginx 内部需要编写本地缓存查询、 Redis 查询、 Tomcat 查询的业务逻辑,因此这样的 nginx 服务不再是一个反向代理服务器 ,而是一个编写 业务的 Web 服务器了 。因此这样的业务 Nginx 服务也需要搭建集群来提高并发,再有专门的 nginx 服务来做反向代理,如图: 另外,我们的 Tomcat 服务将来也会部署为集群模式:

另外,我们的 Tomcat 服务将来也会部署为集群模式: 可见,多级缓存的关键有两个:

可见,多级缓存的关键有两个:- 一个是在nginx中编写业务,实现nginx本地缓存、Redis、Tomcat的查询

- 另一个就是在Tomcat中实现JVM进程缓存

其中 Nginx 编程则会用到 OpenResty 框架结合 Lua 这样的语言。一、 JVM进程缓存

1.1导入商品案例

为了演示多级缓存,我们先导入一个商品管理的案例,其中包含商品的 CRUD 功能。我们将来会给查询商品添 加多级缓存。1.安装MySQL

后期做数据同步需要用到 MySQL 的主从功能,所以需要大家在虚拟机中,利用 Docker 来运行一个 MySQL 容器。1.1. 准备目录为了方便后期配置 MySQL ,我们先准备两个目录,用于挂载容器的数据和配置文件目录:# 进入 /tmp 目录cd /tmp# 创建文件夹mkdir mysql# 进入 mysql 目录cd mysql1.2. 运行命令进入 mysql 目录后,执行下面的 Docker 命令:docker run \-p 3306:3306 \--name mysql \-v $PWD /conf:/etc/mysql/conf.d \-v $PWD /logs:/logs \-v $PWD /data:/var/lib/mysql \-e MYSQL_ROOT_PASSWORD=123 \--privileged \-d \mysql:5.7.251.3. 修改配置在 /tmp/mysql/conf 目录添加一个 my.cnf 文件,作为 mysql 的配置文件:# 创建文件touch /tmp/mysql/conf/my.cnf文件的内容如下:[mysqld]skip-name-resolvecharacter_set_server=utf8datadir=/var/lib/mysqlserver-id= 10001.4. 重启配置修改后,必须重启容器:docker restart mysql2.导入SQL

接下来,利用 Navicat 客户端连接 MySQL ,然后导入资料提供的 sql 文件: 其中包含两张表:

其中包含两张表:- tb_item:商品表,包含商品的基本信息

- tb_item_stock:商品库存表,包含商品的库存信息

之所以将库存分离出来,是因为库存是更新比较频繁的信息,写操作较多。而其他信息修改的频率非常低。3.导入Demo工程

下面导入课前资料提供的工程: 项目结构如图所示:

项目结构如图所示: 其中的业务包括:

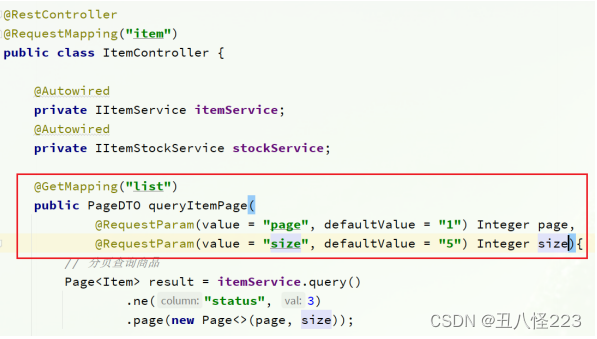

其中的业务包括:- 分页查询商品

- 新增商品

- 修改商品

- 修改库存

- 删除商品

- 根据id查询商品

- 根据id查询库存

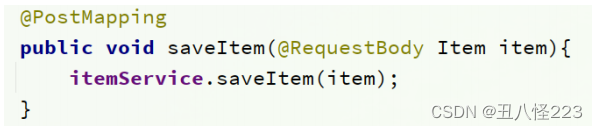

业务全部使用 mybatis-plus 来实现,如有需要请自行修改业务逻辑。3.1. 分页查询商品案例在 com.heima.item.web 包的 ItemController 中可以看到接口定义: 3.2. 新增商品在 com.heima.item.web 包的 ItemController 中可以看到接口定义:

3.2. 新增商品在 com.heima.item.web 包的 ItemController 中可以看到接口定义: 3.3. 修改商品在 com.heima.item.web 包的 ItemController 中可以看到接口定义:

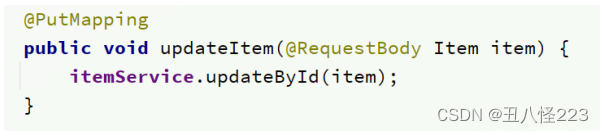

3.3. 修改商品在 com.heima.item.web 包的 ItemController 中可以看到接口定义: 3.4. 修改库存在 com.heima.item.web 包的 ItemController 中可以看到接口定义:

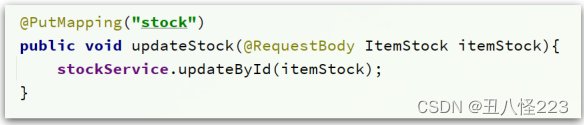

3.4. 修改库存在 com.heima.item.web 包的 ItemController 中可以看到接口定义: 3.5. 删除商品在 com.heima.item.web 包的 ItemController 中可以看到接口定义:

3.5. 删除商品在 com.heima.item.web 包的 ItemController 中可以看到接口定义: 这里是采用了逻辑删除,将商品状态修改为 33.6. 根据 id 查询商品在 com.heima.item.web 包的 ItemController 中可以看到接口定义:

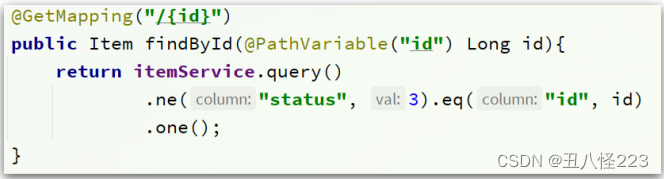

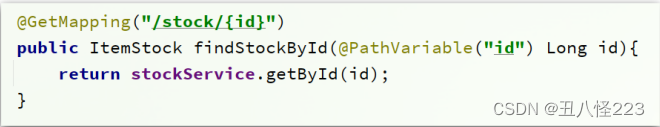

这里是采用了逻辑删除,将商品状态修改为 33.6. 根据 id 查询商品在 com.heima.item.web 包的 ItemController 中可以看到接口定义: 这里只返回了商品信息,不包含库存3.7. 根据 id 查询库存在 com.heima.item.web 包的 ItemController 中可以看到接口定义:

这里只返回了商品信息,不包含库存3.7. 根据 id 查询库存在 com.heima.item.web 包的 ItemController 中可以看到接口定义: 3.8. 启动注意修改 application.yml 文件中配置的 mysql 地址信息:

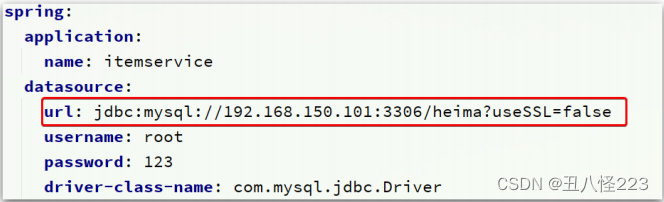

3.8. 启动注意修改 application.yml 文件中配置的 mysql 地址信息: 需要修改为自己的虚拟机地址信息、还有账号和密码。修改后,启动服务,访问: http://localhost:8081/item/10001 即可查询数据

需要修改为自己的虚拟机地址信息、还有账号和密码。修改后,启动服务,访问: http://localhost:8081/item/10001 即可查询数据4.导入商品查询页面

商品查询是购物页面,与商品管理的页面是分离的。部署方式如图: 我们需要准备一个反向代理的 nginx 服务器,如上图红框所示,将静态的商品页面放到 nginx 目录中。页面需要的数据通过 ajax 向服务端( nginx 业务集群)查询。4.1. 运行 nginx 服务这里我已经给大家准备好了 nginx 反向代理服务器和静态资源。我们找到课前资料的 nginx 目录:

我们需要准备一个反向代理的 nginx 服务器,如上图红框所示,将静态的商品页面放到 nginx 目录中。页面需要的数据通过 ajax 向服务端( nginx 业务集群)查询。4.1. 运行 nginx 服务这里我已经给大家准备好了 nginx 反向代理服务器和静态资源。我们找到课前资料的 nginx 目录: 将其拷贝到一个非中文目录下,运行这个 nginx 服务。运行命令:start nginx.exe然后访问 http://localhost/item.html?id=10001 即可:

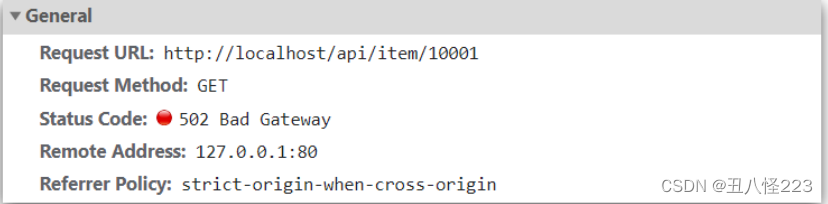

将其拷贝到一个非中文目录下,运行这个 nginx 服务。运行命令:start nginx.exe然后访问 http://localhost/item.html?id=10001 即可: 4.2. 反向代理现在,页面是假数据展示的。我们需要向服务器发送 ajax 请求,查询商品数据。打开控制台,可以看到页面有发起 ajax 查询数据:

4.2. 反向代理现在,页面是假数据展示的。我们需要向服务器发送 ajax 请求,查询商品数据。打开控制台,可以看到页面有发起 ajax 查询数据: 而这个请求地址同样是 80 端口,所以被当前的 nginx 反向代理了。查看 nginx 的 conf 目录下的 nginx.conf 文件:

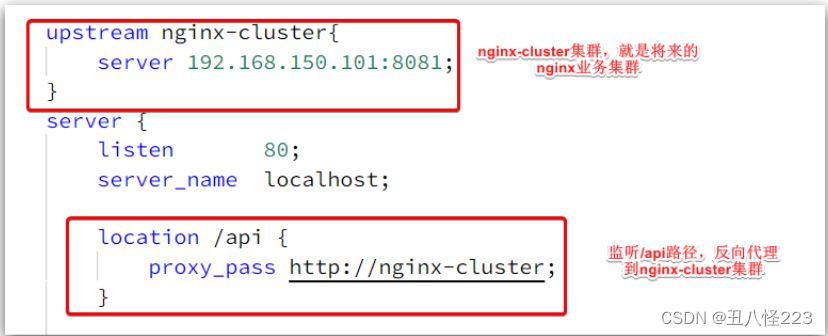

而这个请求地址同样是 80 端口,所以被当前的 nginx 反向代理了。查看 nginx 的 conf 目录下的 nginx.conf 文件: 其中的关键配置如下:

其中的关键配置如下: 其中的 192.168.150.101 是我的虚拟机 IP ,也就是我的 Nginx 业务集群要部署的地方:

其中的 192.168.150.101 是我的虚拟机 IP ,也就是我的 Nginx 业务集群要部署的地方: 完整内容如下:#user nobody;worker_processes 1 ;events {worker_connections 1024 ;}http {include mime.types;default_type application/octet-stream;sendfile on ;#tcp_nopush on;keepalive_timeout 65 ;upstream nginx-cluster{server 192.168.150.101:8081 ;}server {listen 80 ;server_name localhost;location /api {proxy_pass http://nginx-cluster;}location / {root html;index index.html index.htm;}error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}

完整内容如下:#user nobody;worker_processes 1 ;events {worker_connections 1024 ;}http {include mime.types;default_type application/octet-stream;sendfile on ;#tcp_nopush on;keepalive_timeout 65 ;upstream nginx-cluster{server 192.168.150.101:8081 ;}server {listen 80 ;server_name localhost;location /api {proxy_pass http://nginx-cluster;}location / {root html;index index.html index.htm;}error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}1.2初识Caffeine

本地进程缓存

缓存在日常开发中启动至关重要的作用,由于是存储在内存中,数据的读取速度是非常快的,能大量减少对数据库的访问,减少数据库的压力。我们把缓存分为两类:

分布式缓存,例如Redis:

- 优点:存储容量更大、可靠性更好、可以在集群间共享

- 缺点:访问缓存有网络开销

- 场景:缓存数据量较大、可靠性要求较高、需要在集群间共享

进程本地缓存,例如HashMap、GuavaCache:

- 优点:读取本地内存,没有网络开销,速度更快

- 缺点:存储容量有限、可靠性较低、无法共享

- 场景:性能要求较高,缓存数据量较小

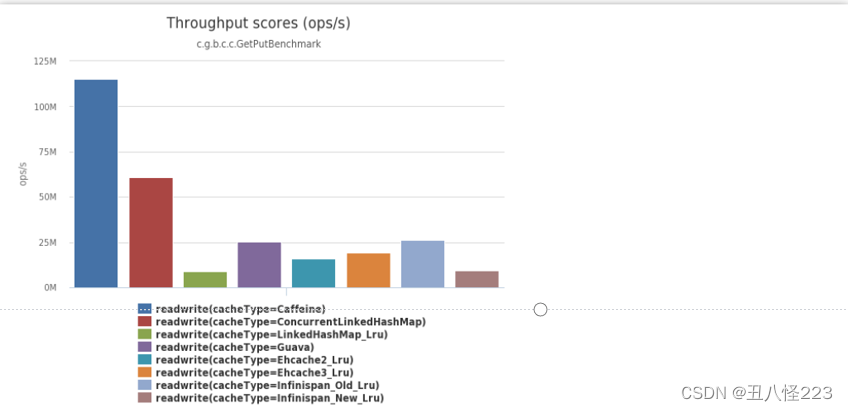

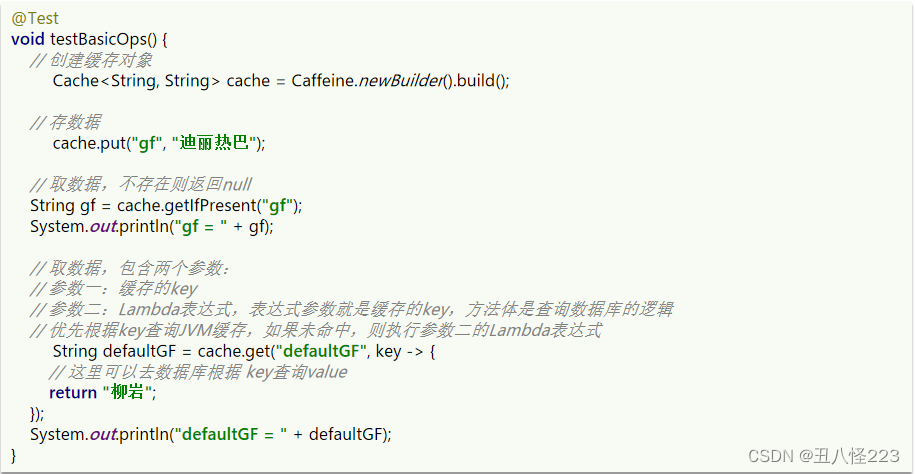

Caffeine是一个基于Java8开发的,提供了近乎最佳命中率的高性能的本地缓存库。目前Spring内部的缓存使用的就是Caffeine。

GitHub地址GitHub - ben-manes/caffeine: A high performance caching library for Java

Caffeine示例

可以通过item-service项目中的单元测试来学习Caffeine的使用:

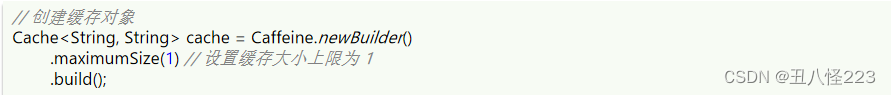

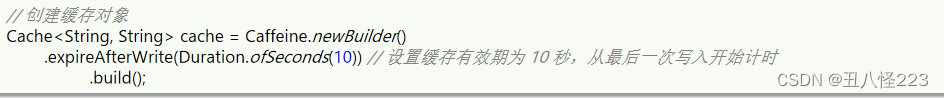

Caffeine提供了三种缓存驱逐策略:

基于容量:设置缓存的数量上限

基于时间:设置缓存的有效时间

基于引用:设置缓存为软引用或弱引用,利用GC来回收缓存数据。性能较差,不建议使用。

在默认情况下,当一个缓存元素过期的时候,Caffeine不会自动立即将其清理和驱逐。而是在一次读或写操作后,或者在空闲时间完成对失效数据的驱逐。

1.3实现进程缓存

案例:实现商品的查询的本地进程缓存

利用Caffeine实现下列需求:

- 给根据id查询商品的业务添加缓存,缓存未命中时查询数据库

- 给根据id查询商品库存的业务添加缓存,缓存未命中时查询数据库

- 缓存初始大小为100

- 缓存上限为10000

二、Lua语法入门

2.1初识Lua

Lua 是一种轻量小巧的脚本语言,用标准C语言编写并以源代码形式开放, 其设计目的是为了嵌入应用程序中,从而为应用程序提供灵活的扩展和定制功能。官网:The Programming Language Lua

HelloWorld

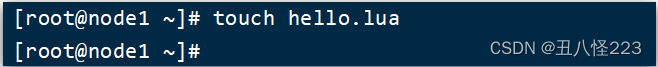

1. 在Linux虚拟机的任意目录下,新建一个hello.lua文件

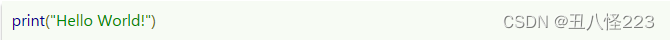

2.添加下面的内容

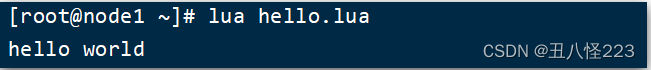

3.运行

2.2变量和循环

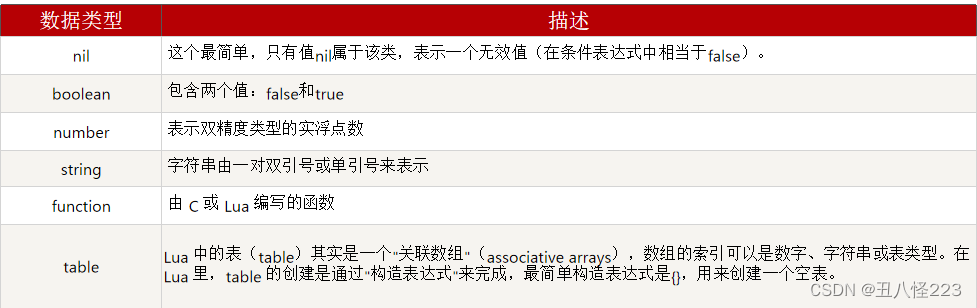

数据类型

可以利用type函数测试给定变量或者值的类型:

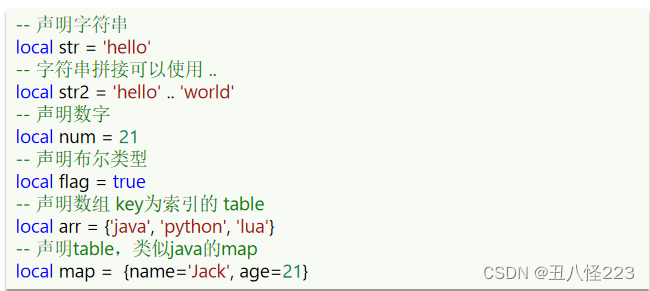

变量

Lua声明变量的时候,并不需要指定数据类型:

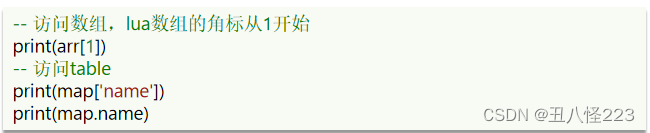

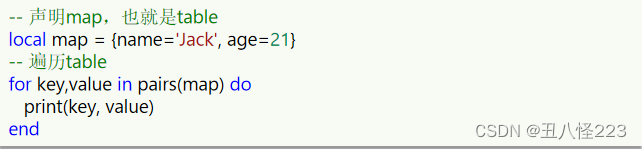

访问table:

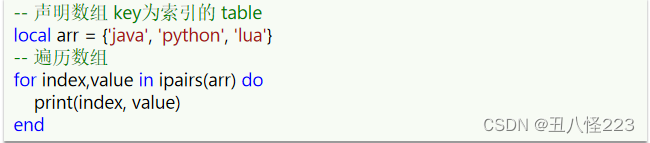

循环

数组、table都可以利用for循环来遍历:

- 遍历数组:

- 遍历table:

2.3条件控制、函数

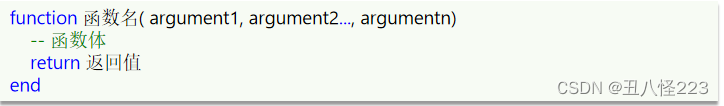

函数

定义函数的语法:

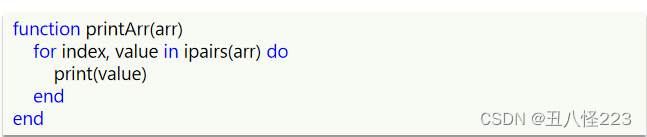

例如,定义一个函数,用来打印数组:

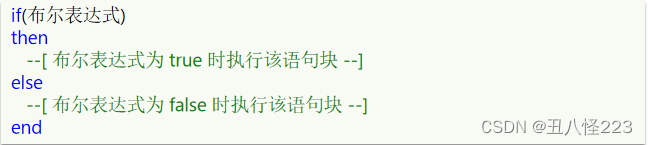

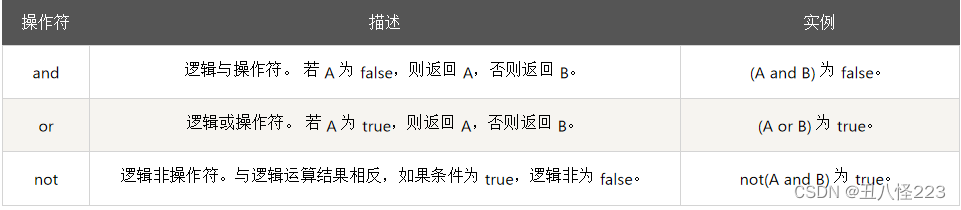

条件控制

类似Java的条件控制,例如if、else语法:

与java不同,布尔表达式中的逻辑运算是基于英文单词:

案例:自定义函数,打印table

需求:自定义一个函数,可以打印table,当参数为nil时,打印错误信息

三、多级缓存

3.1安装OpenResty

初识OpenResty

OpenResty® 是一个基于 Nginx的高性能 Web 平台,用于方便地搭建能够处理超高并发、扩展性极高的动态 Web 应用、Web 服务和动态网关。具备下列特点:

- 具备Nginx的完整功能

- 基于Lua语言进行扩展,集成了大量精良的 Lua 库、第三方模块

- 允许使用Lua自定义业务逻辑、自定义库

官方网站:OpenResty® - 中文官方站

安装 OpenResty

安装 OpenResty1.安装

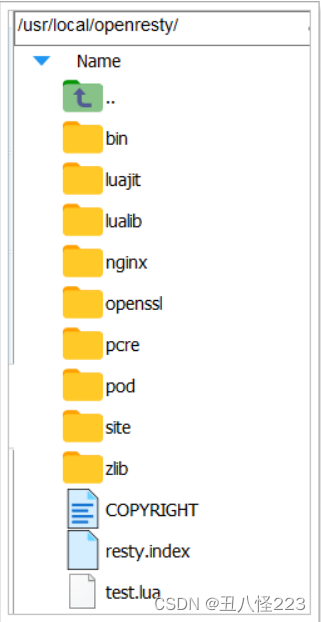

首先你的 Linux 虚拟机必须联网1 )安装开发库首先要安装 OpenResty 的依赖开发库,执行命令:yum install -y pcre-devel openssl-devel gcc --skip-broken2 )安装 OpenResty 仓库你可以在你的 CentOS 系统中添加 openresty 仓库,这样就可以便于未来安装或更新我们的软件包(通过 yum check-update 命令)。运行下面的命令就可以添加我们的仓库:yum-config-manager --add-repo https://openresty.org/package/centos/openresty.repo如果提示说命令不存在,则运行:yum install -y yum-utils然后再重复上面的命令3 )安装 OpenResty然后就可以像下面这样安装软件包,比如 openresty :yum install -y openresty4 )安装 opm 工具opm 是 OpenResty 的一个管理工具,可以帮助我们安装一个第三方的 Lua 模块。如果你想安装命令行工具 opm ,那么可以像下面这样安装 openresty-opm 包:yum install -y openresty-opm5 )目录结构默认情况下, OpenResty 安装的目录是: /usr/local/openresty 看到里面的 nginx 目录了吗, OpenResty 就是在 Nginx 基础上集成了一些 Lua 模块。6 )配置 nginx 的环境变量打开配置文件:vi /etc/profile在最下面加入两行:export NGINX_HOME=/usr/ local /openresty/nginxexport PATH= ${NGINX_HOME} /sbin: $PATHNGINX_HOME :后面是 OpenResty 安装目录下的 nginx 的目录然后让配置生效:source /etc/profile

看到里面的 nginx 目录了吗, OpenResty 就是在 Nginx 基础上集成了一些 Lua 模块。6 )配置 nginx 的环境变量打开配置文件:vi /etc/profile在最下面加入两行:export NGINX_HOME=/usr/ local /openresty/nginxexport PATH= ${NGINX_HOME} /sbin: $PATHNGINX_HOME :后面是 OpenResty 安装目录下的 nginx 的目录然后让配置生效:source /etc/profile2.启动和运行

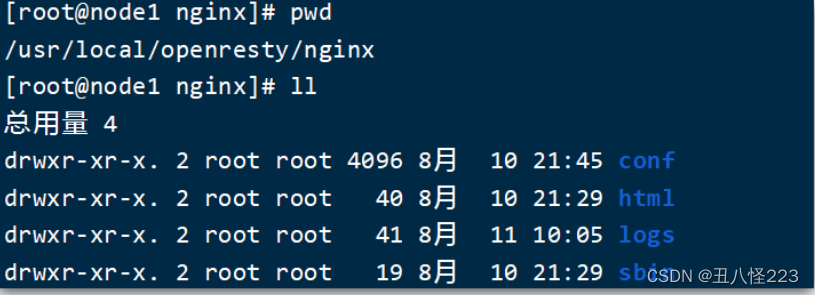

OpenResty 底层是基于 Nginx 的,查看 OpenResty 目录的 nginx 目录,结构与 windows 中安装的 nginx 基本一致: 所以运行方式与 nginx 基本一致:# 启动 nginxnginx# 重新加载配置nginx -s reload# 停止nginx -s stopnginx 的默认配置文件注释太多,影响后续我们的编辑,这里将 nginx.conf 中的注释部分删除,保留有效部分。修改 /usr/local/openresty/nginx/conf/nginx.conf 文件,内容如下:#user nobody;worker_processes 1 ;error_log logs/error.log;events {worker_connections 1024 ;}http {include mime.types;default_type application/octet-stream;sendfile on ;keepalive_timeout 65 ;server {listen 8081 ;server_name localhost;location / {root html;index index.html index.htm;}error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}在 Linux 的控制台输入命令以启动 nginx :nginx然后访问页面: http://192.168.150.101:8081 ,注意 ip 地址替换为你自己的虚拟机 IP :

所以运行方式与 nginx 基本一致:# 启动 nginxnginx# 重新加载配置nginx -s reload# 停止nginx -s stopnginx 的默认配置文件注释太多,影响后续我们的编辑,这里将 nginx.conf 中的注释部分删除,保留有效部分。修改 /usr/local/openresty/nginx/conf/nginx.conf 文件,内容如下:#user nobody;worker_processes 1 ;error_log logs/error.log;events {worker_connections 1024 ;}http {include mime.types;default_type application/octet-stream;sendfile on ;keepalive_timeout 65 ;server {listen 8081 ;server_name localhost;location / {root html;index index.html index.htm;}error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}在 Linux 的控制台输入命令以启动 nginx :nginx然后访问页面: http://192.168.150.101:8081 ,注意 ip 地址替换为你自己的虚拟机 IP :3.备注

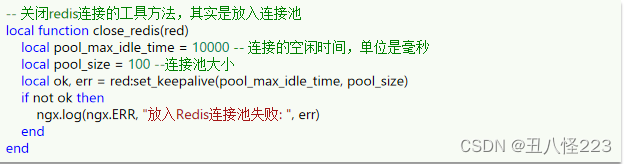

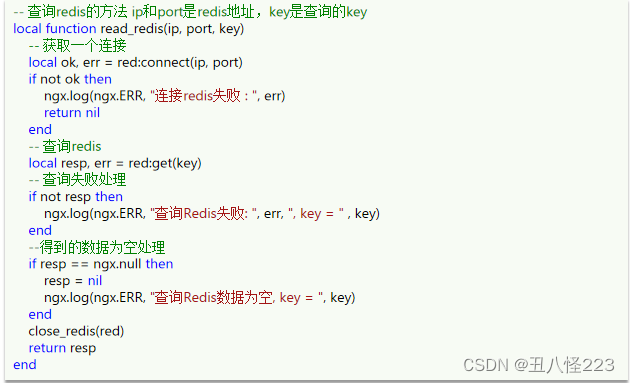

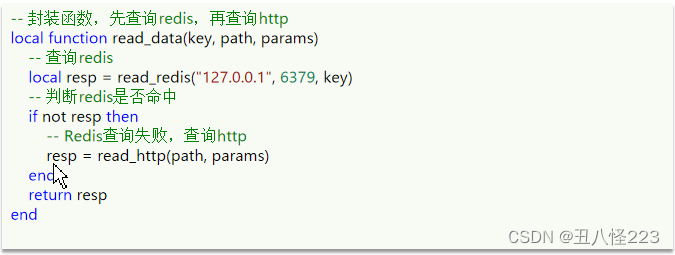

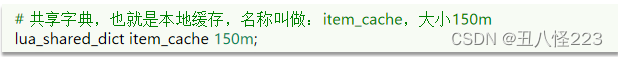

加载 OpenResty 的 lua 模块:#lua 模块lua_package_path "/usr/local/openresty/lualib/?.lua;;" ;#c 模块lua_package_cpath "/usr/local/openresty/lualib/?.so;;" ;common.lua-- 封装函数,发送 http 请求,并解析响应local function read_http (path, params)local resp = ngx.location.capture( path ,{method = ngx.HTTP_GET,args = params,})if not resp then-- 记录错误信息,返回 404ngx. log (ngx.ERR, "http not found, path: " , path , ", args: " , args)ngx. exit ( 404 )endreturn resp.bodyend-- 将方法导出local _M = {read_http = read_http}return _M释放 Redis 连接 API :-- 关闭 redis 连接的工具方法,其实是放入连接池local function close_redis (red)local pool_max_idle_time = 10000 -- 连接的空闲时间,单位是毫秒local pool_size = 100 -- 连接池大小local ok, err = red:set_keepalive(pool_max_idle_time, pool_size)if not ok thenngx. log (ngx.ERR, " 放入 redis 连接池失败 : " , err)endend读取 Redis 数据的 API :-- 查询 redis 的方法 ip 和 port 是 redis 地址, key 是查询的 keylocal function read_redis (ip, port, key)-- 获取一个连接local ok, err = red:connect(ip, port)if not ok thenngx. log (ngx.ERR, " 连接 redis 失败 : " , err)return nilend-- 查询 redislocal resp, err = red:get(key)-- 查询失败处理if not resp thenngx. log (ngx.ERR, " 查询 Redis 失败 : " , err, ", key = " , key)end-- 得到的数据为空处理if resp == ngx.null thenresp = nilngx. log (ngx.ERR, " 查询 Redis 数据为空 , key = " , key)endclose_redis(red)return respend开启共享词典:# 共享字典,也就是本地缓存,名称叫做: item_cache ,大小 150mlua_shared_dict item_cache 150m ;3.2OpenResty快速入门

案例:OpenResty快速入门,实现商品详情页数据查询

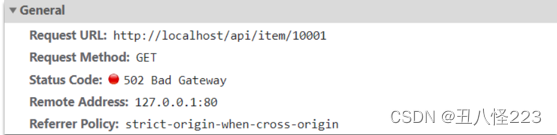

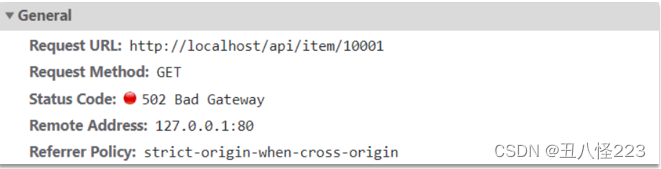

商品详情页面目前展示的是假数据,在浏览器的控制台可以看到查询商品信息的请求:

而这个请求最终被反向代理到虚拟机的OpenResty集群:

需求:在OpenResty中接收这个请求,并返回一段商品的假数据。

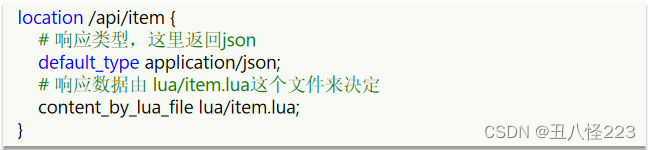

步骤 步骤一:修改nginx.conf文件

1.在nginx.conf的http下面,添加对OpenResty的Lua模块的加载:

2.在nginx.conf的server下面,添加对/api/item这个路径的监听

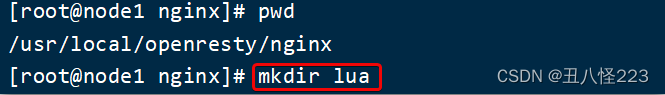

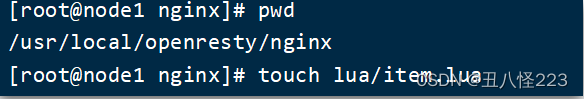

步骤 步骤二:编写item.lua文件

1.在nginx目录创建文件夹:lua

2.在lua文件夹下,新建文件:item.lua

3.内容如下:

4.重新加载配置

3.3请求参数处理

OpenResty获取请求参数

OpenResty提供了各种API用来获取不同类型的请求参数:

案例:获取请求路径中的商品id信息,拼接到json结果中返回

在查询商品信息的请求中,通过路径占位符的方式,传递了商品id到后台:

需求:在OpenResty中接收这个请求,并获取路径中的id信息,拼接到结果的json字符串中返回

3.4查询Tomcat

多级缓存需求

案例:获取请求路径中的商品id信息,根据id向Tomcat查询商品信息

这里要修改item.lua,满足下面的需求:

1.获取请求参数中的id

2.根据id向Tomcat服务发送请求,查询商品信息

3.根据id向Tomcat服务发送请求,查询库存信息

4.组装商品信息、库存信息,序列化为JSON格式并返回

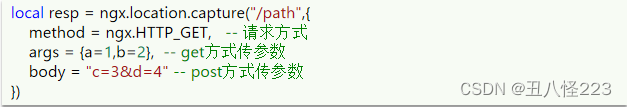

nginx内部发送Http请求

nginx提供了内部API用以发送http请求:

返回的响应内容包括:

- resp.status:响应状态码

- resp.header:响应头,是一个table

- resp.body:响应体,就是响应数据

注意:这里的path是路径,并不包含IP和端口。这个请求会被nginx内部的server监听并处理。

但是我们希望这个请求发送到Tomcat服务器,所以还需要编写一个server来对这个路径做反向代理:

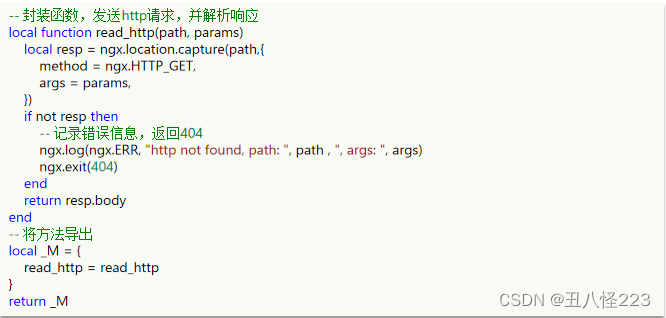

封装http查询的函数

我们可以把http查询的请求封装为一个函数,放到OpenResty函数库中,方便后期使用。

1.在/usr/local/openresty/lualib目录下创建common.lua文件:

2.在common.lua中封装http查询的函数

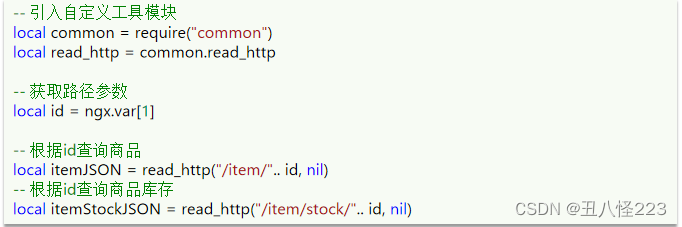

使用Http函数查询数据

我们刚才已经把http查询的请求封装为一个函数,放到OpenResty函数库中,接下来就可以使用这个库了。

- 修改item.lua文件

查询到的是商品、库存的json格式数据,我们需要将两部分数据组装,需要用到JSON处理函数库。

JSON结果处理

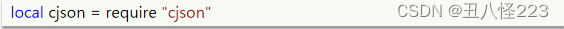

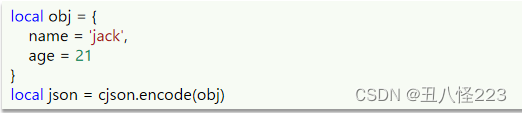

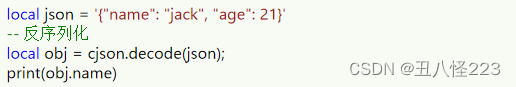

OpenResty提供了一个cjson的模块用来处理JSON的序列化和反序列化。

官方地址:https://github.com/openresty/lua-cjson/

- 引入cjson模块:

- 序列化:

- 反序列化:

Tomcat集群的负载均衡

3.5Redis缓存预热

添加redis缓存的需求

冷启动与缓存预热

冷启动:服务刚刚启动时,Redis中并没有缓存,如果所有商品数据都在第一次查询时添加缓存,可能会给数据库带来较大压力。

缓存预热:在实际开发中,我们可以利用大数据统计用户访问的热点数据,在项目启动时将这些热点数据提前查询并保存到Redis中。

我们数据量较少,可以在启动时将所有数据都放入缓存中。

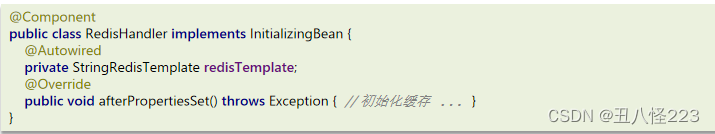

缓存预热

1.利用Docker安装Redis

2.在item-service服务中引入Redis依赖

3.配置Redis地址

4.编写初始化类

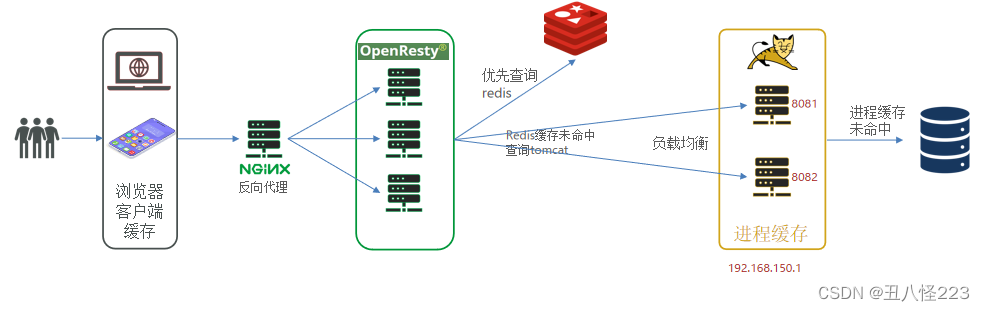

3.6查询Redis缓存

OpenResty的Redis模块

OpenResty提供了操作Redis的模块,我们只要引入该模块就能直接使用:

- 引入Redis模块,并初始化Redis对象

- 封装函数,用来释放Redis连接,其实是放入连接池

- 封装函数,从Redis读数据并返回

案例:查询商品时,优先Redis缓存查询

需求:

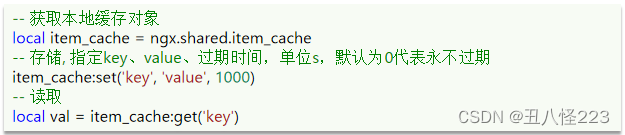

- 修改item.lua,封装一个函数read_data,实现先查询Redis,如果未命中,再查询tomcat

- 修改item.lua,查询商品和库存时都调用read_data这个函数

3.7Nginx本地缓存

Nginx本地缓存需求

nginx本地缓存

OpenResty为Nginx提供了shard dict的功能,可以在nginx的多个worker之间共享数据,实现缓存功能。

- 开启共享字典,在nginx.conf的http下添加配置:

- 操作共享字典:

案例:在查询商品时,优先查询OpenResty的本地缓存

需求:

- 修改item.lua中的read_data函数,优先查询本地缓存,未命中时再查询Redis、Tomcat

- 查询Redis或Tomcat成功后,将数据写入本地缓存,并设置有效期

- 商品基本信息,有效期30分钟

- 库存信息,有效期1分钟

nginx本地缓存

修改后的查询逻辑:

四、缓存同步策略

4.1数据同步策略

缓存同步策略

缓存数据同步的常见方式有三种:

设置有效期:给缓存设置有效期,到期后自动删除。再次查询时更新

- 优势:简单、方便

- 缺点:时效性差,缓存过期之前可能不一致

- 场景:更新频率较低,时效性要求低的业务

同步双写:在修改数据库的同时,直接修改缓存

- 优势:时效性强,缓存与数据库强一致

- 缺点:有代码侵入,耦合度高;

- 场景:对一致性、时效性要求较高的缓存数据

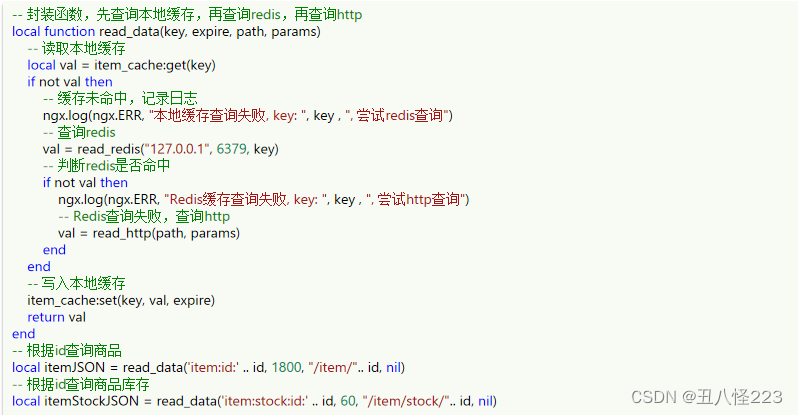

异步通知:修改数据库时发送事件通知,相关服务监听到通知后修改缓存数据

- 优势:低耦合,可以同时通知多个缓存服务

- 缺点:时效性一般,可能存在中间不一致状态

- 场景:时效性要求一般,有多个服务需要同步

缓存同步策略

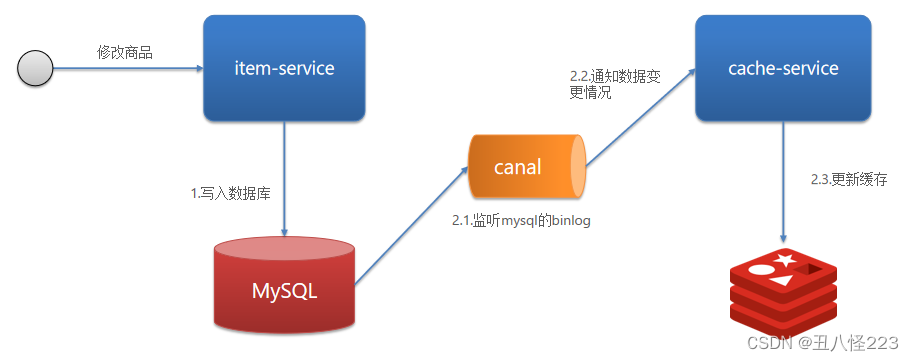

基于MQ的异步通知:

4.2安装Canal

初识Canal

Canal [kə'næl],译意为水道/管道/沟渠,canal是阿里巴巴旗下的一款开源项目,基于Java开发。基于数据库增量日志解析,提供增量数据订阅&消费。GitHub的地址:GitHub - alibaba/canal: 阿里巴巴 MySQL binlog 增量订阅&消费组件

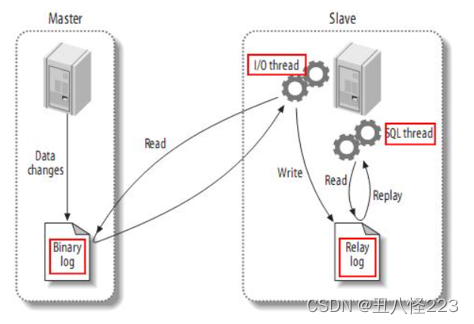

Canal是基于mysql的主从同步来实现的,MySQL主从同步的原理如下:

- MySQL master 将数据变更写入二进制日志( binary log),其中记录的数据叫做binary log events

- MySQL slave 将 master 的 binary log events拷贝到它的中继日志(relay log)

- MySQL slave 重放 relay log 中事件,将数据变更反映它自己的数据

Canal就是把自己伪装成MySQL的一个slave节点,从而监听master的binary log变化。再把得到的变化信息通知给Canal的客户端,进而完成对其它数据库的同步。

安装和配置Canal

下面我们就开启mysql的主从同步机制,让Canal来模拟salve

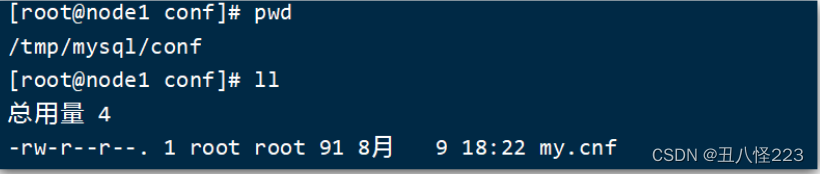

1.开启MySQL主从

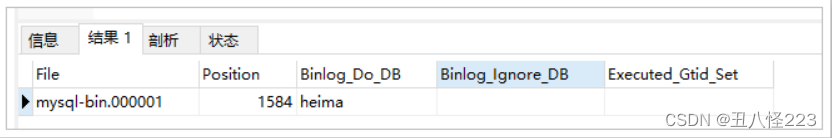

Canal 是基于 MySQL 的主从同步功能,因此必须先开启 MySQL 的主从功能才可以。这里以之前用 Docker 运行的 mysql 为例:1.1. 开启 binlog打开 mysql 容器挂载的日志文件,我的在 /tmp/mysql/conf 目录 : 修改文件:vi /tmp/mysql/conf/my.cnf添加内容:log-bin=/var/lib/mysql/mysql-binbinlog-do-db=heima配置解读:

修改文件:vi /tmp/mysql/conf/my.cnf添加内容:log-bin=/var/lib/mysql/mysql-binbinlog-do-db=heima配置解读:- log-bin=/var/lib/mysql/mysql-bin:设置binary log文件的存放地址和文件名,叫做mysql-bin

- binlog-do-db=heima:指定对哪个database记录binary log events,这里记录heima这个库

最终效果:[mysqld]skip-name-resolvecharacter_set_server=utf8datadir=/var/lib/mysqlserver-id= 1000log-bin=/var/lib/mysql/mysql-binbinlog-do-db=heima1.2. 设置用户权限接下来添加一个仅用于数据同步的账户,出于安全考虑,这里仅提供对 heima 这个库的操作权限。create user canal@'%' IDENTIFIED by 'canal';GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT,SUPER ON *.* TO 'canal'@'%'identified by 'canal';FLUSH PRIVILEGES;重启 mysql 容器即可docker restart mysql测试设置是否成功:在 mysql 控制台,或者 Navicat 中,输入命令:show master status;

2.安装Canal

2.1. 创建网络我们需要创建一个网络,将 MySQL 、 Canal 、 MQ 放到同一个 Docker 网络中:docker network create heima让 mysql 加入这个网络:docker network connect heima mysql2.3.安装Cana课前资料中提供了 canal 的镜像压缩包 : 大家可以上传到虚拟机,然后通过命令导入:docker load -i canal.tar然后运行命令创建 Canal 容器:docker run -p 11111:11111 --name canal \-e canal.destinations=heima \-e canal.instance.master.address=mysql:3306 \-e canal.instance.dbUsername=canal \-e canal.instance.dbPassword=canal \-e canal.instance.connectionCharset=UTF-8 \-e canal.instance.tsdb.enable= true \-e canal.instance.gtidon= false \-e canal.instance.filter.regex=heima\\..* \--network heima \-d canal/canal-server:v1.1.5说明 :

大家可以上传到虚拟机,然后通过命令导入:docker load -i canal.tar然后运行命令创建 Canal 容器:docker run -p 11111:11111 --name canal \-e canal.destinations=heima \-e canal.instance.master.address=mysql:3306 \-e canal.instance.dbUsername=canal \-e canal.instance.dbPassword=canal \-e canal.instance.connectionCharset=UTF-8 \-e canal.instance.tsdb.enable= true \-e canal.instance.gtidon= false \-e canal.instance.filter.regex=heima\\..* \--network heima \-d canal/canal-server:v1.1.5说明 :- -p 11111:11111:这是canal的默认监听端口

- -e canal.instance.master.address=mysql:3306:数据库地址和端口,如果不知道mysql容器地 址,可以通过docker inspect 容器id来查看

- -e canal.instance.dbUsername=canal:数据库用户名

- -e canal.instance.dbPassword=canal :数据库密码

- -e canal.instance.filter.regex=:要监听的表名称

表名称监听支持的语法:mysql 数据解析关注的表, Perl 正则表达式 .多个正则之间以逗号 (,) 分隔,转义符需要双斜杠 (\\)常见例子:1. 所有表: .* or .*\\..*2. canal schema 下所有表: canal\\..*3. canal 下的以 canal 打头的表: canal\\.canal.*4. canal schema 下的一张表: canal.test15. 多个规则组合使用然后以逗号隔开: canal\\..*,mysql.test1,mysql.test24.3监听Canal

Canal客户端

Canal提供了各种语言的客户端,当Canal监听到binlog变化时,会通知Canal的客户端。

Canal提供了各种语言的客户端,当Canal监听到binlog变化时,会通知Canal的客户端。不过这里我们会使用GitHub上的第三方开源的canal-starter。地址:GitHub - NormanGyllenhaal/canal-client: spring boot canal starter 易用的canal 客户端 canal client

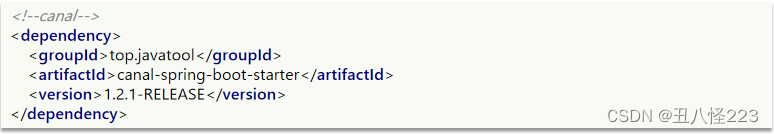

引入依赖:

编写配置:

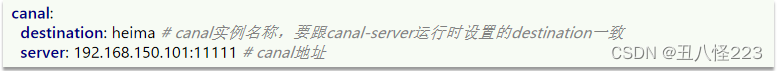

编写监听器,监听Canal消息:

Canal推送给canal-client的是被修改的这一行数据(row),而我们引入的canal-client则会帮我们把行数据封装到Item实体类中。这个过程中需要知道数据库与实体的映射关系,要用到JPA的几个注解:

多级缓存总结

-

相关阅读:

使用ASM修改组件化 ARouter

浅谈单点登录SSO实现方案 | StartDT Tech Lab 06

YOLO目标检测——谢韦尔钢材缺陷检测数据集下载分享【含对应voc、coco和yolo三种格式标签】

机器人路径规划:基于A*算法的机器人路径规划(提供Python代码)

Web学习笔记-React(组合Components)

低代码平台如何兼顾开发速度与开发质量

python opencv图像模糊

Mybatis的三种映射关系以及联表查询

地震数据处理研究(Matlab代码实现)

JS面试题----防抖函数

- 原文地址:https://blog.csdn.net/msn131420/article/details/126132947