-

【深度学习】实验5布置:滴滴出行-交通场景目标检测

DL_class

学堂在线《深度学习》实验课代码+报告(其中实验1和实验6有配套PPT),授课老师为胡晓林老师。课程链接:https://www.xuetangx.com/training/DP080910033751/619488?channel=i.area.manual_search。

持续更新中。

所有代码为作者所写,并非最后的“标准答案”,只有实验6被扣了1分,其余皆是满分。仓库链接:https://github.com/W-caner/DL_classs。 此外,欢迎关注我的CSDN:https://blog.csdn.net/Can__er?type=blog。

部分数据集由于过大无法上传,我会在博客中给出下载链接。如果对代码有疑问,有更好的思路等,也非常欢迎在评论区与我交流~实验5:滴滴出行-交通场景目标检测

1 任务和数据简介

本次案例将使用深度学习技术来完成城市交通场景下的目标检测任务,案例所使用的数据集由滴滴出行提供,基于D2-City大规模行车记录视频数据集[1],经过视频抽帧等预处理步骤得到。数据集共包含12,000张图像,每张图像的大小为1080×1920或720×1280,已划分为训练集(10,000张)、验证集(1,000张)、测试集(1,000张)。

其中训练集和验证集提供了检测标签,测试集仅提供图像,用于提交后测试模型效果。本数据集共包含12个待检测的物体类别,包括小汽车、公交车、自行车、行人等,具体定义及示例如图1所示。本任务的目标是在给定的交通场景图像中,尽可能完整、准确地检测出所有要求的物体,检测结果示例如图2所示。关于数据的更多细节可参考D2-City文献[1]。

为了方便使用,数据集的标注信息已被预处理成MS-COCO格式,MS-COCO是通用物体检测领域最常用的数据集,如需深入理解数据集格式,请自行学习:MS-COCO数据集官网[2]、MS-COCO数据集文献[3]、MS-COCO标注格式[4]。

模型的评估指标也使用MS-COCO常用指标mAP(meanaverageprecision),请自行学习其定义及计算方式(无需自己实现):mAP定义[5],mAP计算方式[6]。

2 参考程序及使用说明

本次案例提供了完整、可供运行的参考程序,选取了带FPN[8]结构的FasterR-CNN[9]模型,基于MMDetection物体检测框架[10]实现,各程序简介如下:

-

faster_rcnn_r50_fpn_1x_didi.py为模型配置文件,安装MMDetection后置于mmdetection/configs/faster_rcnn路径下;

-

didi_detection.py 为数据集配置文件,置于 mmdetection/configs/base/datasets 路径下,并将 data_root 变量修改为数据集所在路径;

-

didi_demo.ipynb 用于可视化模型的检测结果。

参考程序的使用步骤及说明:

-

自行安装 MMDetection 最新版(v2.1.0)及其全部依赖库,包括 PyTorch 等 (MMDetection GitHub: [10],安装指南: [11]);学习必要的使用说明: MMDetection 文档[12] (请务必仔细阅读 Getting Started 章节);

图1: 待检测的 12 个物体类别及其示例

图2: 检测结果示例,不同颜色的框代表不同类别 -

下载案例数据集,链接:https://pan.baidu.com/s/1TQTLl8GoyE0Qkw8dkbtzfg ,密码:n1nn。配置上述文件并置于 MMDetection 目录下的指定位置;

-

以参考程序(Faster R-CNN with FPN)为例,训练模型: python tools/train.py configs/faster_rcnn/faster_rcnn_r50_fpn_1x_didi.py

-

根据训练得到的模型(.pth 文件,训练后自动保存于 work_dirs/路径下),在测 试集上进行推理并得到.json 格式的输出文件:

python tools/test.py configs/faster_rcnn/faster_rcnn_r50_fpn_1x_didi.py \ ./work_dirs/faster_rcnn_r50_fpn_1x_didi/latest.pth \ --format-only --options "jsonfile_prefix=./test_results"该命令会生成 test_results.json 文件,用于最终提交和评分。

-

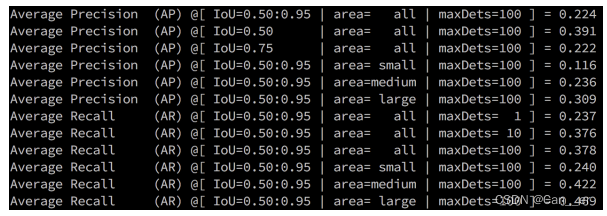

参考程序的超参数沿用了MS-COCO数据集上的配置,可能在本案例数据集上表现不够好,仅以此为例展示如何完成本案例;图3是参考程序训练完成后在验证集上的结果(每轮训练结束后自动输出),图4是测试集上的结果(学生不可见,用于最后评分)。

图3: 参考程序训练完成后在验证集上的mAP结果

图4:参考程序训练完成后在测试集上的mAP结果(学生不可见)

3 要求和建议

在参考程序的基础上,综合使用深度学习各项技术,尝试提升该模型在城市交通场景目标检测任务上的效果,以最后提交的.json输出结果对应的测试集mAP值为评价标准。

可从物体检测领域的各个方面着手对模型进行提升,如尝试其它的检测算法(替换FasterR-CNN),如FCOS,CascadeR-CNN等;或者尝试改进FasterR-CNN算法本身的部件,如尝试其它网络结构(替换ResNet50)、其它更适合本案例数据集的超参数(训练图像分辨率、anchor设置、训练策略等)。

建议参考MMDetection已经实现好的若干模型[13],以及通用物体检测领域的其它常用方法和技巧[14]。

4 注意事项

- 提交所有代码和一份案例报告,提交 test_results.json 文件;

- 案例报告应详细介绍所有改进尝试及对应的结果(包括验证集 mAP 值和若 干检测结果示例图),无论是否成功提升模型效果,并对结果作出分析;

- 禁止任何形式的抄袭,借鉴开源程序务必加以说明。

5 参考资料

[1] Che et al. D2 -City: A Large-Scale Dashcam Video Dataset of Diverse Traffic Scenarios. arXiv 2019.

[2] MS-COCO 数据集: https://cocodataset.org/

[3] Lin et al. Microsoft COCO: Common Objects in Context. ECCV 2014.

[4] MS-COCO 标注格式: https://www.immersivelimit.com/tutorials/create-coco-annotations-from-scratch

[5] MS-COCO mAP 定义: https://cocodataset.org/#detection-eval

[6] mAP 计算方式: https://www.zhihu.com/question/53405779

[7] mAP 计算方式: https://github.com/rafaelpadilla/Object-Detection-Metrics/

[8] Lin et al. Feature pyramid networks for object detection. CVPR 2017.

[9] Ren et al. Faster r-cnn: Towards real-time object detection with region proposal networks. NIPS 2015.

[10] MMDetection: https://github.com/open-mmlab/mmdetection

[11] MMDetection 安装指南: https://github.com/open-mmlab/mmdetection/blob/master/docs/install.md

[12] MMDetection 文档: https://mmdetection.readthedocs.io/

[13] MMDetection Model Zoo: https://github.com/open-mmlab/mmdetection/blob/master/docs/model_zoo.m

-

-

相关阅读:

如何将vue-element-admin中的excel导入导出功能模块, 单独拿出来用 更新中...

k8s组件证书续期

基于双向长短期记忆 BiLSTM 实现股票单变量时间序列预测(PyTorch版)

flex布局与float布局

ElasticSearch入门

Spring系列-bean标签内autowire属性应用

Java流程结构

【Linux】服务器部署:阿里云服务器购买配置与报价参考

css一个图片上面加上遮罩蒙板,只修改img的样式不多写标签

若依vue前端 报错error:0308010C:digital envelope routines::unsupported

- 原文地址:https://blog.csdn.net/Can__er/article/details/127985550