-

《HDMapNet:An Online HD Map Construction and Evaluation Framework》论文笔记

参考代码:HDMapNet

1. 概述

介绍:在这篇文章中提出一种生成向量化高精地图(verctorized HD map)的方案,通过如IMU、GPS、Lidar等传感器数据融合可以生成全局的高精度定位信息,对于局部的信息是通过相机和Lidar实现的,其中最为关键便是行车过程中的车道信息。对于局部信息的获取方法是这篇文章的重点,其通过编码器处理环视图像和Lidar数据,之后将其映射到bev空间并引入时序得到融合信息表达,之后用于预测车道实例。

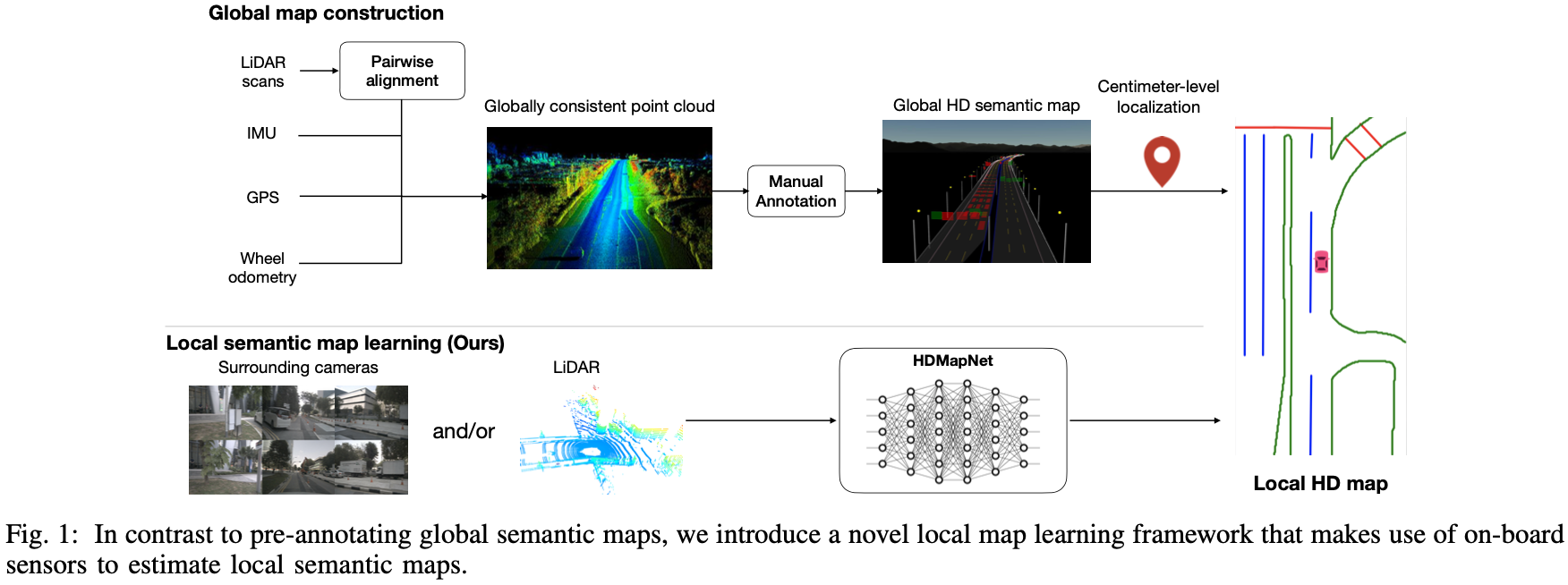

下图展示的便是生成高清地图的工作流程,通过将全局信息获取定位结果和局部信息融合得到精细化高精地图:

这里如何使用 全局信息获取部分定位并不是关注点重点,局部信息获取才是这篇文章着力想探讨的东西。2. 方法设计

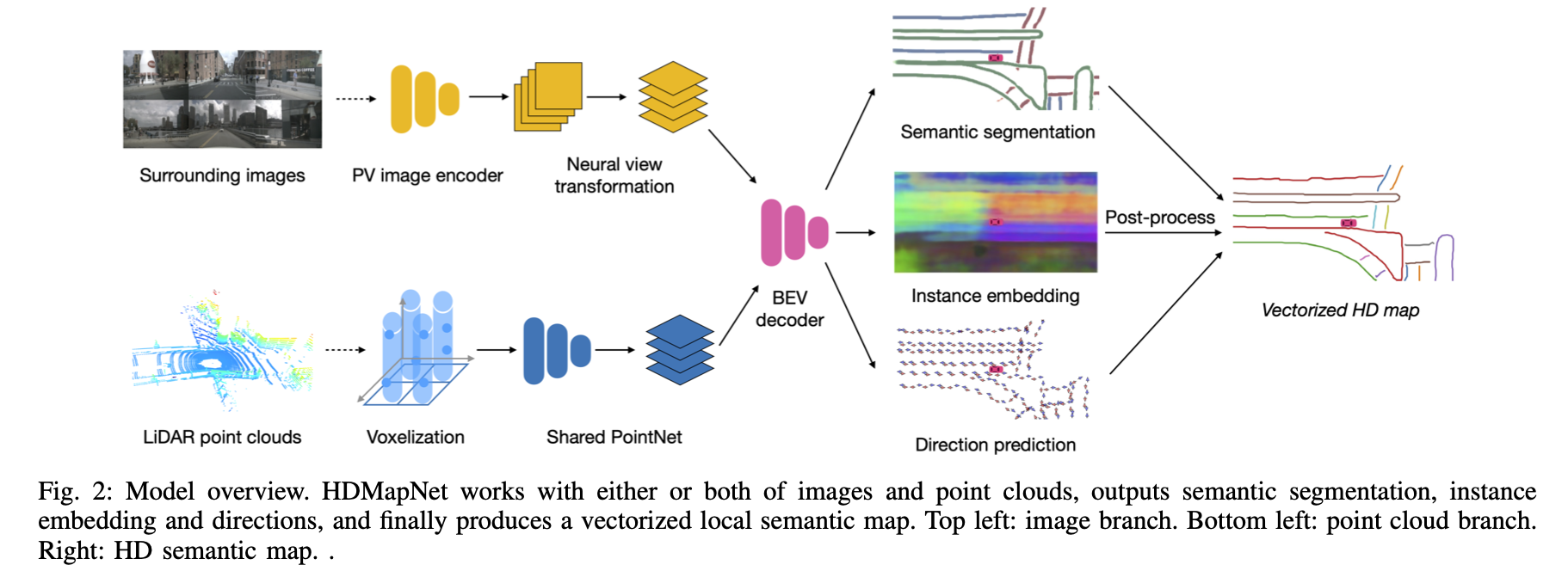

在局部信息获取流程中输入环视相机数据或者附加Lidar数据,各自经过对应编码器之后在bev下实现特征融合 ,之后用于预测车道实例。

2.1 编码器

图像数据编码:

图像数据经过CNN网络编码之后得到语义特征图,但是由于单纯的2D图像是很难获取实际深度值的,直接使用相机内外参数(假设深度为1)会导致投影出现偏差,对此文章中采用的是一种多层全连接将图像坐标数据映射到相机坐标下:

F I i c [ h ] [ w ] = ϕ V i h w ( F I i p v [ 1 ] [ 1 ] , … , F I i p v [ H p v ] [ W p v ] ) F_{I_i}^c[h][w]=\phi_{V_i}^{hw}(F_{I_i}^{pv}[1][1],\dots,F_{I_i}^{pv}[H_{pv}][W_{pv}]) FIic[h][w]=ϕVihw(FIipv[1][1],…,FIipv -

相关阅读:

SpringCloud 微服务全栈体系(二)

端口配置错误,导致RabbitMq启动报错

java计算机毕业设计学生社团管理与评价系统源码+系统+lw+数据库+调试运行

Jenkins 构建的时候提示 DOCKER_HOST 错误

Java架构师缓存性能优化

Apache Hudi vs Delta Lake:透明TPC-DS Lakehouse性能基准

PAL8像素格式

学生Dreamweaver静态网页设计 基于HTML+CSS+JavaScript制作简食餐厅美食网站制作

设计模式最佳实践代码总结 - 结构型设计模式篇 - 代理模式最佳实践

NumPy(二)

- 原文地址:https://blog.csdn.net/m_buddy/article/details/127644335