-

深度学习-卷积神经网络

- 看b站up主霹雳吧啦Wz视频,所做笔记

- 视频链接 :1.1 卷积神经网络基础

- 卷积神经网络历史

- CNN发展

- 1986年:Rumelhart和Hinton等人提出了反向传播(Back Propagation, BP)

- 1998年 :LeCun等利用BP算法训练LeNet5网络,标志着CNN的真正面试(硬件跟不上)

- 2006年:Hinton在他们的Science Paper中首次提出了Deep Learning的概念

- 2012年:Hinton的学生Alex Krizhevsky在寝室用GPU死磕了一个Deep Learning模型,一举摘下了视觉领域竞赛ILSVRC 2012的桂冠,效果大幅度超过传统的方法,传统的70%多提升到80%多

- 有GPU资源尽量使用GPU,因为测试中GPU和CPU的速度相差很大,GPU提升效率在20倍以上

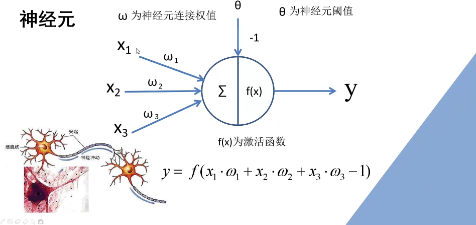

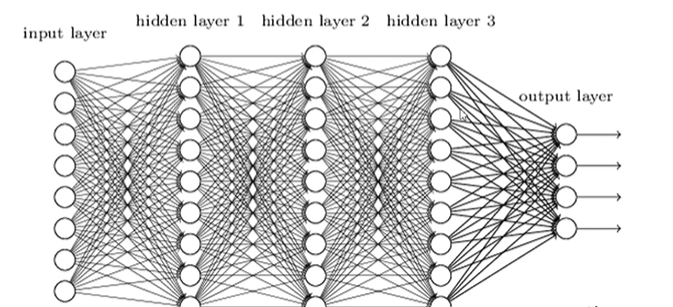

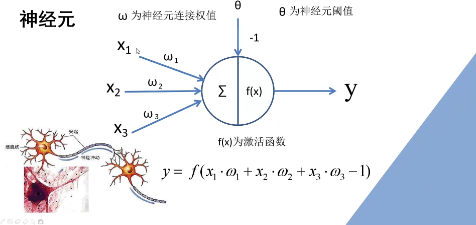

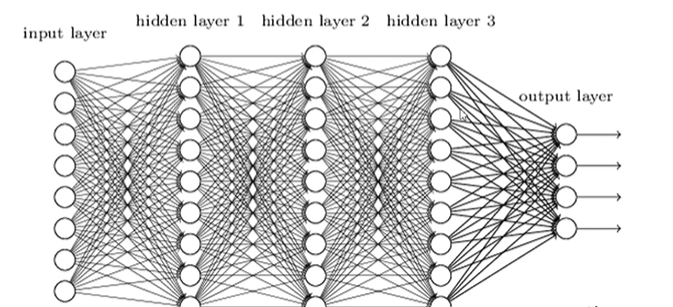

- 全连接层

- -1是偏置

- BP(back propagation)算法包括信号的前向传播和误差的反向传播两个过程,即计算误差输出时按从输入到输出的方向进行,而调整权值和阈值则从输出到输入的方向进行

- 3层BP神经网络可以实现多维单位立方体R^m到R^n的映射,即能够逼近任何有理函数。

- 卷积层

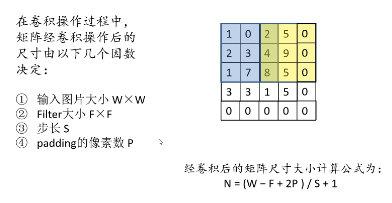

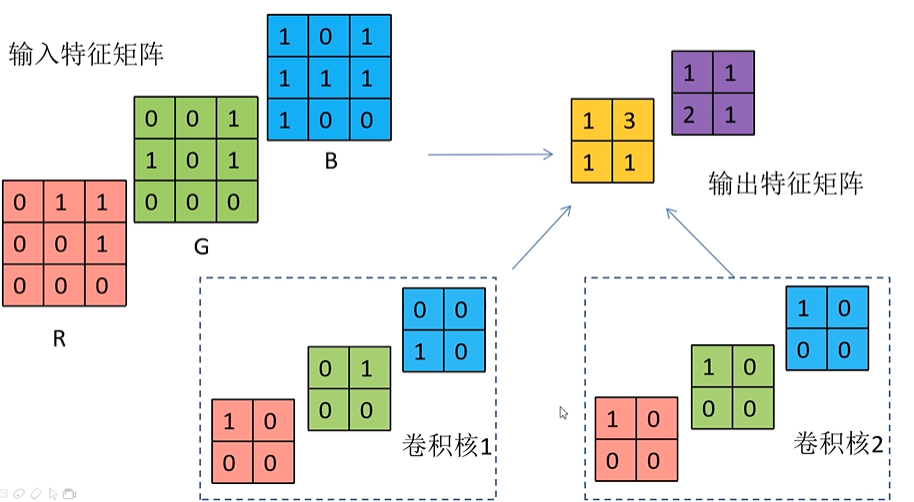

- CNN中独特的网络结构,其实是一个滑动窗口在特征图上进行滑动并计算

- 计算过程:卷积核的值和特征图上的值进行相乘然后相加得到一个值,每滑动一个窗口计算得到一个值,最后得到一个卷积特征图

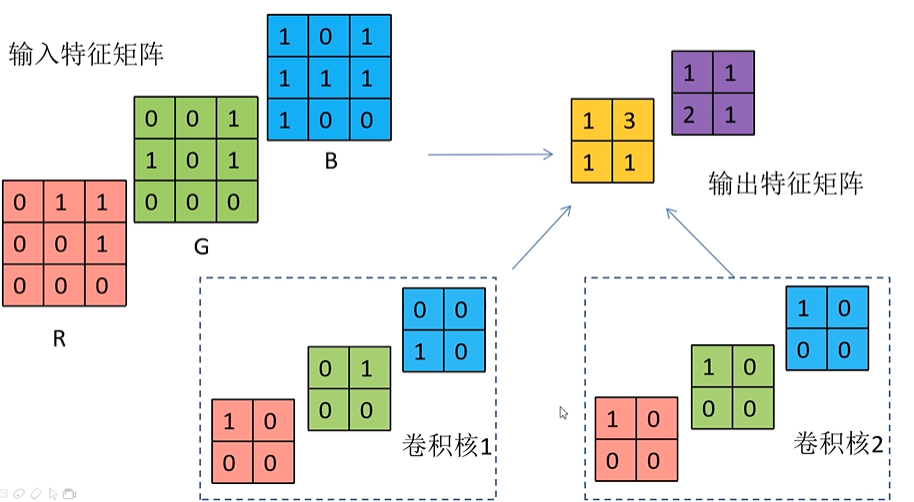

- 多维卷积操作

- 卷积核维度要和输入特征矩阵维度保持一致

- 卷积后进行求和操作得到一个卷积层,不同卷积核进行卷积得到不同输出特征矩阵,然后将不同卷积核得到的输出特征矩阵进行拼接,得到整个输出的特征矩阵

如卷积核1的每个层与对应层卷积,得到的值相加,即可得到特征矩阵1

- 总结

- 卷积核的channel与输入特征层的channel相同

- 思考

- 加上激活函数后该如何计算

- 加入激活函数后,可以引入非线性因素,具备解决非线性问题的能力

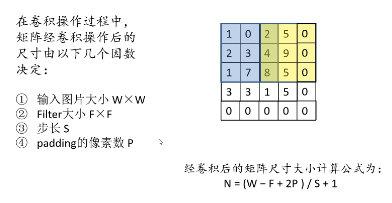

- 如果卷积过程中出现越界的情况怎么办

- 使用padding方式在周围补上0

- 池化层

- 池化方法

- 平均下采样层(AveragePooling):相加取平均值

- 池化层特点:

- 只改变特征矩阵的w和h,不改变深度(channel)

- 一般池化核(poolsize)和步长(stride)相同

-

相关阅读:

PCB阻抗计算

Firefox浏览器:我不卖

开发属于自己的node包

Gitlab服务器配置LDAP指导

【1++的C++进阶】之特殊类设计

云原生之容器编排实践-通过IDEA连接Docker服务

JAVA项目中什么是DTO、DAO、PO、Controller、Common

【困难】42. 接雨水-单调栈、动态规划、数学法、双指针

Android MVI架构的深入解析与对比

Springboot 加密方案探讨

-

原文地址:https://blog.csdn.net/qq_61897309/article/details/127590088