-

Apollo星火计划学习笔记第五讲——Apollo感知模块详解实践1

零、目录

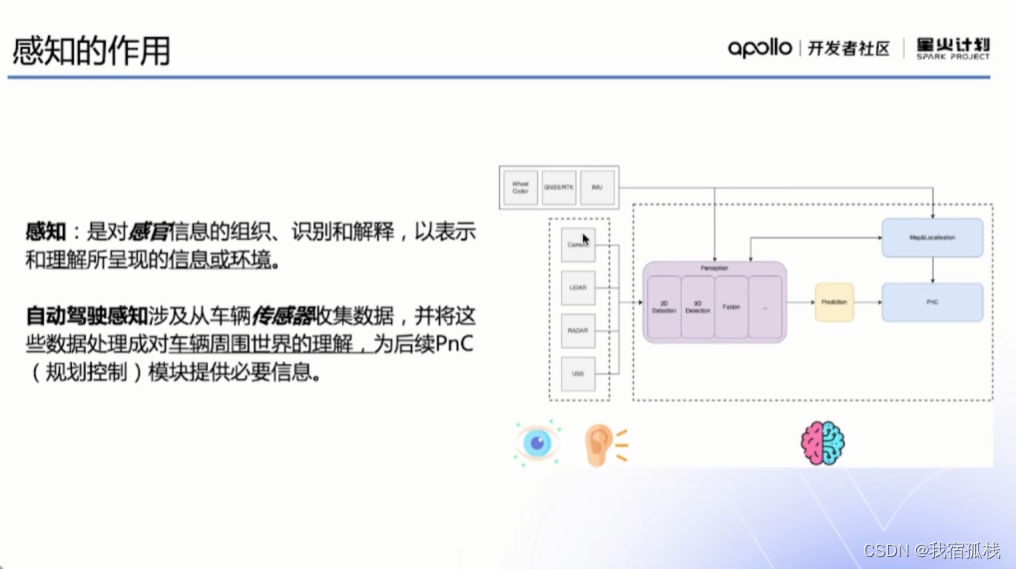

一、感知的作用

何为必要信息?

下图为驾驶过程中,从人的角度来说必要信息的解读:

左图第一层:4D毫米波雷达点云图

左图中间层:摄像头

左图第三层:激光雷达点云数据图右图:三层融合后输出鸟瞰图

右图给到工控模块进行路径规划、障碍物躲避等等。

二、常见传感器介绍

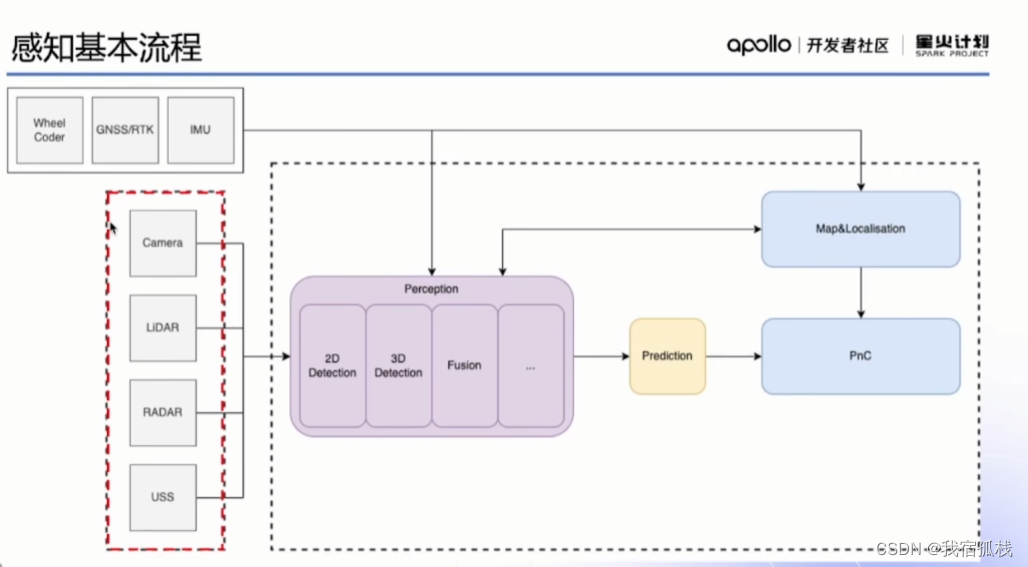

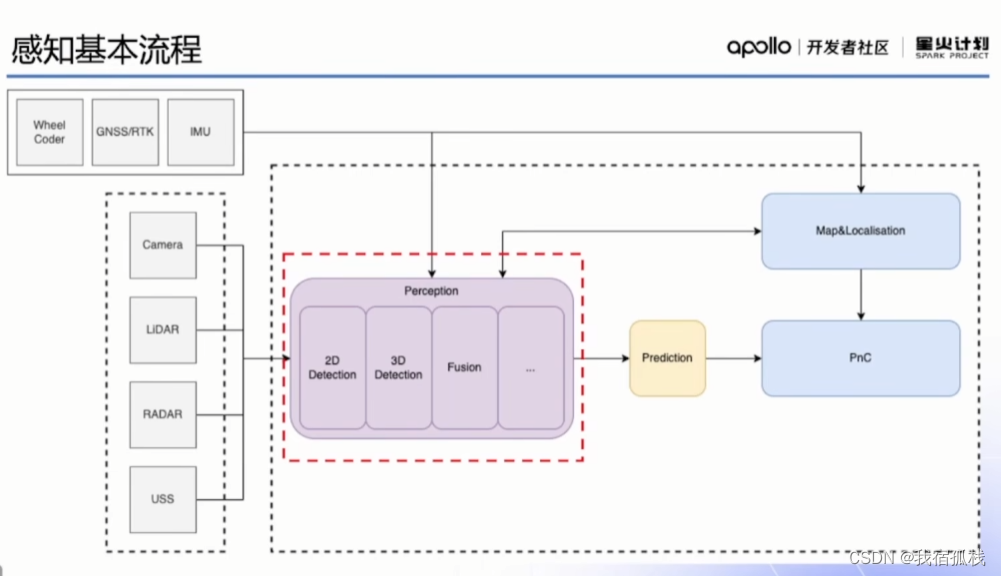

常说的感知传感器一般就包含上述环境传感器中的四种;实际操作时用到的感知框架则还包含自车传感器。

没有完美的传感器,所以基本都是多传感器融合。

2.1 相机

双目摄像头可通过几何关系得到深度信息。

2.2 激光雷达

光源的选择影响测距性能,自然干扰情况;

堆叠了多少发射器决定了其性能,64线/128线雷达即堆叠了多少个发射器,即在同一水平角度能一次性发出去多少线。

只接受一个波段信息,所以缺乏颜色信息、纹理等信息。

2.3 摄像头和激光雷达比较

挡板被挡住或过曝时激光雷达仍可正常工作。

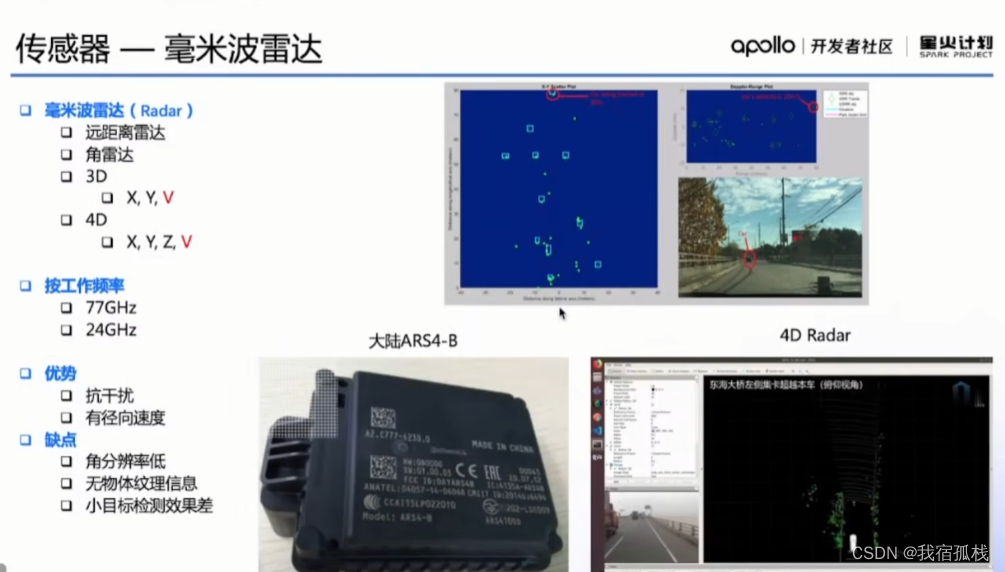

2.4 毫米波雷达

2.5 部署方案

5:目标探测更加准确

4:目标探测良好;

3:辅助作用或者存在功能缺陷

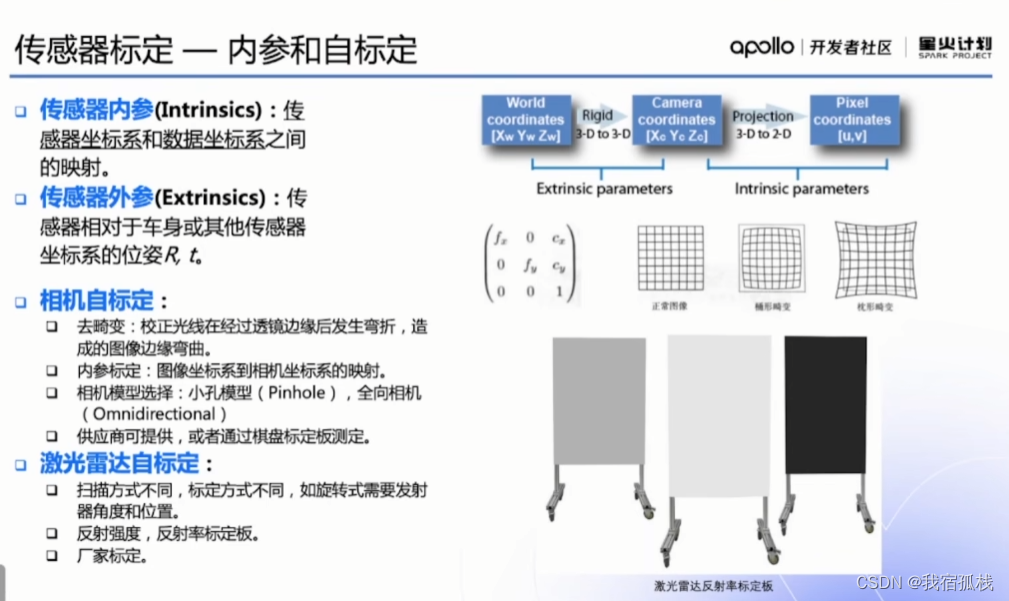

三、传感器标定

传感器的安装位置根据不同的车型、不同的使用均有各自的特殊性。

标定目的:将所有传感器坐标同一到车身坐标系下。

3.1 坐标系

坐标系可参见博主的另一篇博文:坐标系及标定。

3.2 内参和自标定

有时候供应商会提供内参参数,若没有可通过OpenCV、标定板等测取内参。激光雷达最原始的输出是极坐标输出,正常情况下,极坐标转到笛卡尔坐标是在驱动中完成的一个转换。

完成这一步即完成了所有数据到传感器坐标下的一个转换。

3.3 Camera2Camera

传感器坐标→车身坐标

3.4 LiDAR2LiDAR

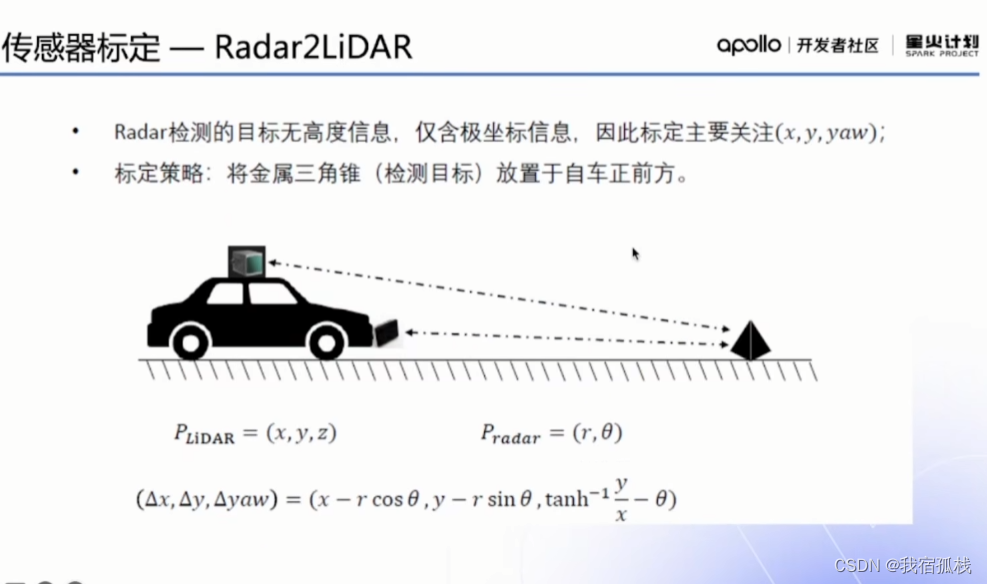

3.5 Radar2LiDAR

毫米波雷达给到信息:二维的,x,y和速度信息,即(x,y,yaw),没有高度信息。3.6 Camera2LiDAR

一个较新的联合标定方法。同一块打了四个圆点的棋盘格进行相机和激光雷达的联合标定(且包含内参标定,用棋盘格求解相机内参)。

该论文工作室还开源了此标定工具。

3.7 无目标方法

四、感知流程和算法

至此,可以认为已经具备一辆安装好了传感器且传感器也标定好了的车,下一步即正式进入感知模块。

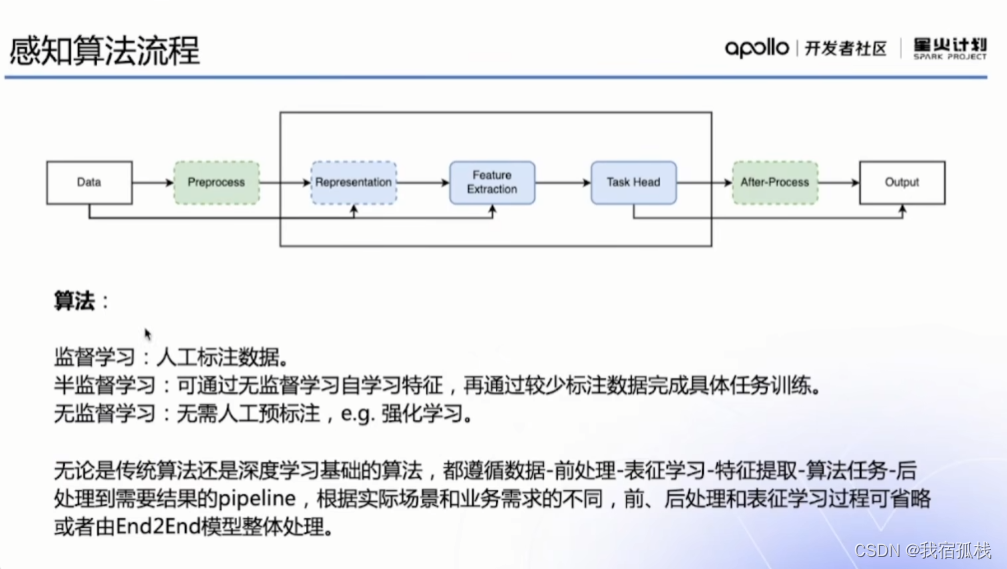

4.1 感知算法流程

这里主要针对监督学习。

4.2 CV任务

freespace:可行驶区域。

实例分割:目标检测+语义分割

4.3 全景分割

4.4 激光雷达点云算法前处理

激光雷达处理的特殊之处:数据前处理有个点云补偿(motion compensation)部分,因为每个激光束发射时间有间隔(垂直和水平方向都有间隔)会导致误差。

4.5 激光雷达点云检测常见算法

左侧Point_based算法:在数据自动标注等对时间没有高要求时会考虑准确度更高的算法即Point_based算法。

右下两个算法用得相对较少。

4.6 激光雷达点云分割常见算法

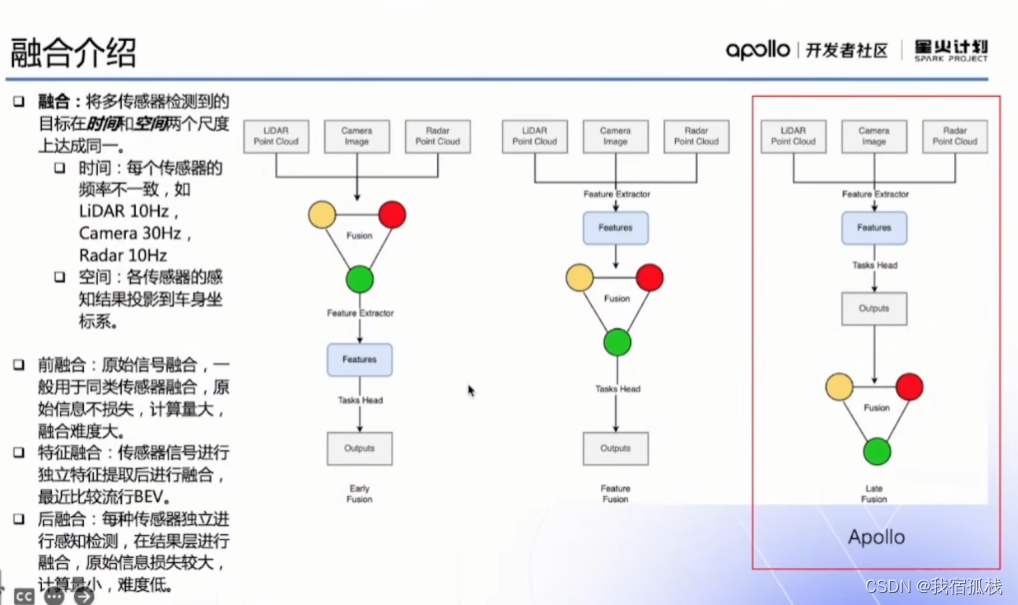

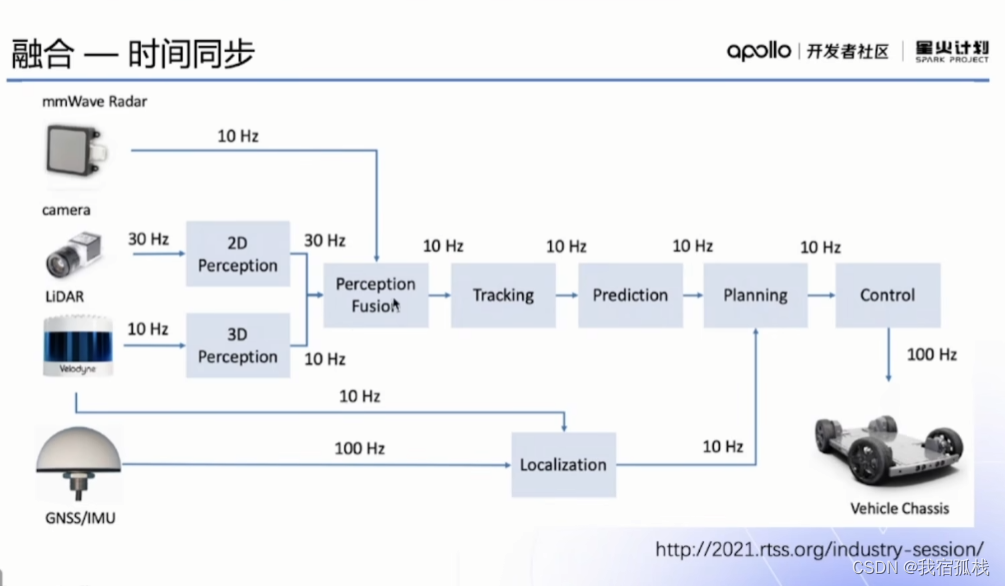

4.7 融合介绍

BEV融合前景相对较广。4.8 数据集

4.9 算法——评价和测试

整体评价测试大抵经过上述三种测试:数据测试、场景测试和实车测试。

左一绿色框为数据来源:开源数据、自采数据和仿真数据。

中间为场景测试:偏模块和软件的功能性测试,模型在环,软件在环,硬件在环。

右边框:ivista和中汽研给出了场景定义。

4.10 数据闭环

4.11 训练、优化到部署

ONNX:较为通用TensorRT:转为NVIDIA设计。

OpenVINO和NCCC:基于安卓平台的边缘就算。

4.12 未来:端到端

前文所描述是基于模块化的方式;

未来可能发展方向:端到端。

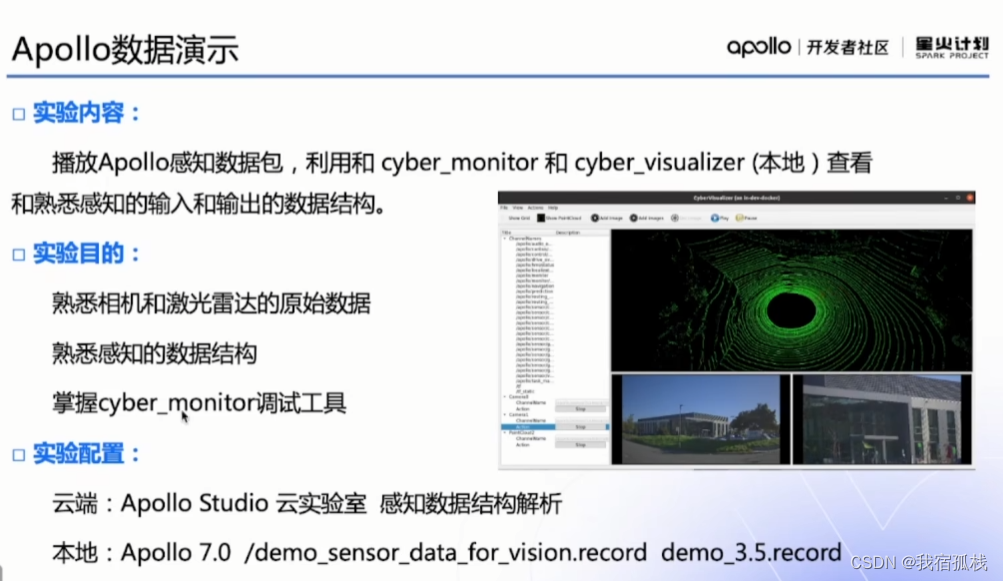

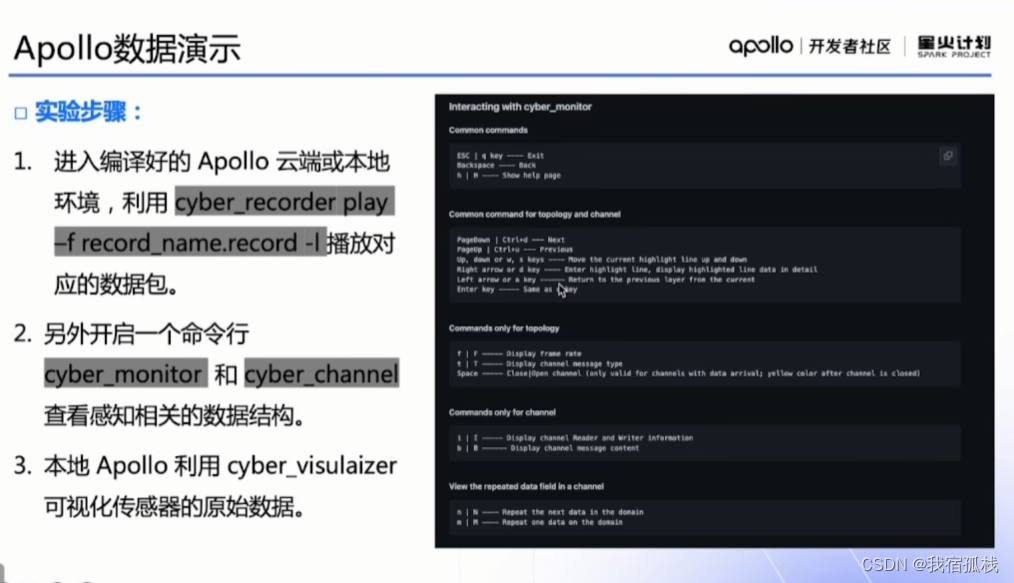

五、实验部分

-

相关阅读:

什么是 CASB,在网络安全中的作用

2020美亚个人赛复盘

Java JavaMail通过SMPT发送邮件

@WebFilter两种使用方法和失效解决方案

[在线文档]学习编程常见的在线教程和文档

Edge官方鼠标手势

自己动手写编译器:实现命令行模块

docker入门加实战—Docker镜像和Dockerfile语法

我的世界Bukkit服务器插件开发教程(九)NMS

太多了,咖啡加盟哪个品牌好,投资者怎么选择?

- 原文地址:https://blog.csdn.net/qq_37346140/article/details/127539593