-

部署LVS-DR集群

文章目录

一、LVS-DR工作原理

LVS-DR(Linux Virtual Server Director Server)工作模式,是生产环境中最常用的一种工作模式

- LVS-DR模式,Director Server 作为集群的访问入口,不作为网关使用

- 节点Director Server与Real Server需要在同一个网络中,返回给客户端的数据不需要经过Director Server

- 为了响应整个集群的访问,Director Server与Real Server都需要配置VIP地址

客户机发起请求,经过调度服务器(LVS),经过算法调度,去访问真是服务器(RS)

由于不原路返回,客户机不知道,真实主机的IP地址,

所以只能通过调度服务器的外网IP(vip)去返回报文信息Director Server作为集群的访问入口,但不作为网关使用,后端服务器池中的Real Server与 Director Server在同一物理网络中,发给客户机的数据包不需要经过Director Server。为了响应对整个集群的访问,DS(前端负载均衡节点服务器)与RS(后端真实服务器)都需要配置有VIP地址。

每个Real Server上都有两个IP:VIP(负载均衡对外提供访问的IP地址)和RIP(负载均衡后端的真实服务器IP地址),但是VIP是隐藏的,就是不能提供解析等功能,只是用来做请求恢复的源IP的,Director上只需要一个网卡,然后利用别名来配置两个IP:VIP和DIP(负载均衡与后端服务器通信的IP地址),在DIR接收到客户端的请求后,DIR根据负载均衡算法选择一台RS的网卡mac作为客户端请求包中的目标mac,通过arp转交给后端RS处理,后端再通过自己的路由网关回复给客户端

二、LVS-DR数据流向

数据流向分析- 用户发送请求到Director Server,请求的数据报文(源IP是client客户端IP,目标IP是VIP)到达内核空间

- 由于DS和RS在用一个网络中,所以是通过二层数据链路层来传输

- 内核空间判断数据包的目标IP是本机IP,此时IPVS比对数据包请求的服务是否为集群服务,若是,重新封装数据包,修改源MAC地址为DS的MAC地址,目标MAC地址为RS的MAC地址,源IP地址与目标IP地址没有改变,然后将数据包发送给Real Server

- RS发现请求报文的MAC地址是自己的MAC地址,就接收此报文,重新封装报文(源IP地址为VIP,目标IP为CIP)将响应报文通过io传送给ens33网卡然后向外发出

- RS直接将响应报文传送到客户端

三、DR模式特点即优缺点

1.DR模式特点

- Director Server和Real Server必须在同一物理网络中

- Real Server可以使用私有地址,也可以使用公网地址。如果使用公网地址,可以通过互联网对RIP进行直接访问

- Director Server作为集群的访问入口,但不能作为网关使用

- 所有的请求报文经由Director Server IP,即Real Server发送的数据包不允许经过Director Server

- Real Server上的io接口配置VIP的IP地址

2.LVS-DR的优缺点

优点:

负载均衡器只负责将数据包分发给物理服务器,而物理服务器将应答包直接分发给用户。所以,负责均衡器能处理很巨大的请求量,这种方式,一台负载均衡能为超过100台物理服务器服务,负载均衡器不再是系统的瓶颈。使用LVS-DR方式,如果你的负载均衡器拥有100M的全双工网卡的话,就能使得整个Virtual Server能达到1G的拓土良,甚至更高

缺点

这种方式需要所有的DIR和RIP都在同一广播域;不支持异地容灾四、ARP解析问题

1.问题一:IP地址冲突

在LVS-DR负载均衡集群中,负载均衡与节点服务器要配置相同的VIP地址,在局域网中具有相同的IP地址。势必会造成各服务器ARP通信的紊乱

- 当ARP广播发送到LVS-DR集群时,因为负载均衡器和节点服务器都是连接到相同的网络上,它们都会接收到ARP广播

- 只有前端的负载均衡器进行响应,其他节点服务器不应该响应ARP广播

解决办法: - 对节点服务器进行处理,使其不响应针对VIP的ARP请求

- 用虚拟接口lo:0承载VIP地址

- 设置内核参数arp_ignore=1:系统只响应目的IP为本地IP(真实网卡IP)的ARP请求

2.问题二:第二次再有访问请求

Real Server返回报文(源IP是VIP)经路由器转发,重新封装报文时,需要先获取路由器的MAC地址,发送ARP请求时,Linux默认使用IP包的源IP地址(VIP)作为ARP请求包中的源IP地址,而不使用发送接口的IP地址,路由器收到ARP请求后,将更新ARP表项,原有的VIP对用Director的MAC地址会被更新为VIP对应的Real Server的MAC地址。路由器根据ARP表项,会将新来的请求报文转发给Real Server,导致Director的VIP失效

解决办法

对节点服务器进行处理,设置内核参数arp_announce=2:系统不使用IP包的源地址来设置ARP请求的源地址,而选择发送接口的IP地址路由器上绑定了真实服务器1的mac信息 请求到达真实服务器 在真实服务器上修改内核参数 只对所有服务器真实网卡上的地址进行反馈,解析- 1

- 2

- 3

- 4

五、部署LVS-DR集群

1.实验准备

LVS-DR服务器:192.168.100.11

web01:192.168.100.12

web02:192.168.100.13

vip(虚拟回环):192.168.100.100

NFS服务器:192.168.100.14

客户端:192.168.100.1102.环境准备

部署前关闭所有机器防火墙及核心防护

systemctl stop firewalld systemctl disable firewalld setenforce 0- 1

- 2

- 3

在内网的服务器无法直接通过yum下载,需要配置本地yum仓库,在机器中执行以下脚本

#!/bin/bash mount /dev/cdrom /mnt mkdir /etc/yum.repos.d/bak mv /etc/yum.repos.d/*.repo /etc/yum.repos.d/bak touch /etc/yum.repos.d/local.repo echo " [local] name=local baseurl=file:///mnt enabled=1 gpgcheck=0 " > /etc/yum.repos.d/local.repo yum clean all yum makecache- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

3.配置负载调度器LVS(192.168.100.11)

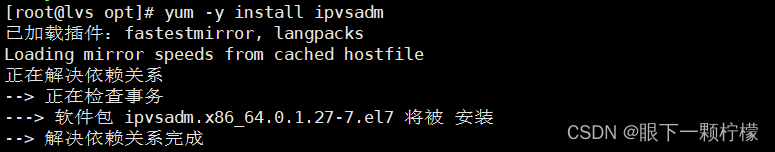

3.1安装ipvsadm工具

yum -y install ipvsadm- 1

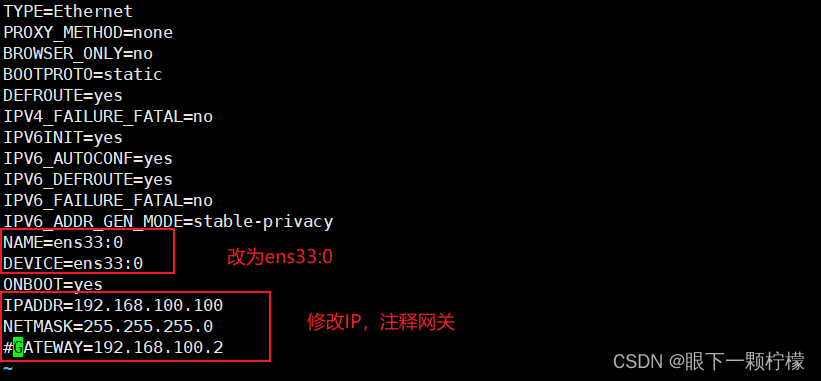

3.2配置虚拟IP地址(VIP:192.168.100.100)

cd /etc/sysconfig/network-scripts/ cp ifcfg-ens33 ifcfg-ens33:0 vim ifcfg-ens33:0- 1

- 2

- 3

ifup ens33:0 #启动虚拟IP ifconfig- 1

- 2

启动成功

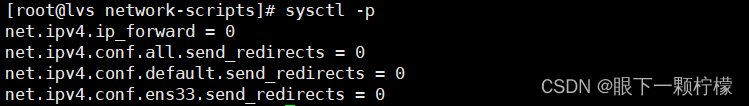

3.3调整内核(proc)响应参数

由于LVS负载均衡器和各个节点需要共用vip地址,应该关闭Linux内核的重定向响应参数,不充当路由器,这样当DS收到客户端发来的数据包时,就不会立马转发给后台RS服务器,而是转发给自己的虚拟子接口。

vim /etc/sysctl.conf #编辑内核proc参数 修改以下内容 net.ipv4.ip_forward = 0 #关闭路由转发功能 net.ipv4.conf.all.send_redirects = 0 #关闭所有send重定向 net.ipv4.conf.default.send_redirects = 0 #关闭默认重定向 net.ipv4.conf.ens33.send_redirects = 0 #关闭网卡重定向 sysctl -p #查看内核参数- 1

- 2

- 3

- 4

- 5

- 6

- 7

3.4配置负载分配策略

ipvsadm -C #清空规则 ipvsadm -A -t 192.168.100.100:80 -s rr #创建虚拟主机,指定ip地址,并指定分流模式为轮询 ipvsadm -a -t 192.168.100.100:80 -r 192.168.100.12:80 -g #添加真实服务器ip地址,并指定负载均衡模式为DR ipvsadm -a -t 192.168.100.100:80 -r 192.168.100.13:80 -g #添加真实服务器ip地址,并指定负载均衡模式为DR ipvsadm #启动策略 ipvsadm-save > /etc/sysconfig/ipvsadm #保存策略- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

4.部署共享存储NFS(192.168.100.14)

4.1安装nfs和rpcbind

yum -y install nfs-utils rpcbind systemctl start nfs systemctl start rpcbind- 1

- 2

- 3

4.2创建共享目录,并设置权限

mkdir /opt/web01 /opt/web02 chmod 777 /opt/web01 /opt/web02- 1

- 2

4.3输入网页内容

echo "this is web01" > /opt/web01/index.html echo "this is web02" > /opt/web02/index.html- 1

- 2

4.4设置共享目录并发布共享

vim /etc/exports 添加以下内容 /opt/web01 192.168.100.0/24(rw,sync) /opt/web02 192.168.100.0/24(rw,sync)- 1

- 2

- 3

- 4

4.5发布共享

exportfs -rv- 1

4.6查看共享

showmount -e localhost- 1

5.配置节点服务器(web01 和 web02)

以下步骤web01和web02都要配置

5.1配置虚拟IP地址(vip:192.168.100.100)

此地址仅作为发送web响应数据包的源地址,并不需要监听客户机的访问请求(改由调度器监听并分发),因此使用虚拟接口lo:0来承载VIP,并为本机添加一条路由记录,并将访问的VIP的数据限制在本地,以免通信紊乱

cd /etc/sysconfig/network-scripts/ cp ifcfg-lo ifcfg-lo:0 vim ifcfg-lo:0 编写以下内容 DEVICE=lo:0 ONBOOT=yes IPADDR=192.168.100.100 NETMASK=255.255.255.255 ifup lo:0 #启动环回网卡 ifconfig lo:0 #查看环回网卡- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

5.2添加vip本地访问路由,设置系统自动识别,并设置执行权限

route add -host 192.168.100.100 dev lo:0 或者下面方式,都可实现路由禁锢,下面为永久添加 vim /etc/rc.local #Linux在开机启动时,会加载的内容 /sbin/route add -host 192.168.100.100 dev lo:0 chmod +x /etc/rc.d/rc/local- 1

- 2

- 3

- 4

- 5

5.3调整内核的ARP响应参数以阻止更新vip的MAC地址,避免冲突

vim /etc/sysctl.conf 添加以下内容 net.ipv4.conf.all.arp_ignore = 1 net.ipv4.conf.all.arp_announce = 2 net.ipv4.conf.default.arp_ignore = 1 net.ipv4.conf.default.arp_announce = 2 net.ipv4.conf.lo.arp_ignore = 1 net.ipv4.conf.lo.arp_announce = 2- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

sysctl -p #立即生效- 1

5.4安装nfs、rpcbind和httpd服务

yum -y install nfs-utils rpcbind httpd- 1

以上步骤 web01 和 web02 一样5.5开启相关服务,并挂载共享目录

web01

systemctl start nfs systemctl start rpcbind systemctl start httpd mount.nfs 192.168.100.14:/opt/web01 /var/www/html df -hT- 1

- 2

- 3

- 4

- 5

web02systemctl start nfs systemctl start rpcbind systemctl start httpd mount.nfs 192.168.100.14:/opt/web02 /var/www/html df -hT- 1

- 2

- 3

- 4

- 5

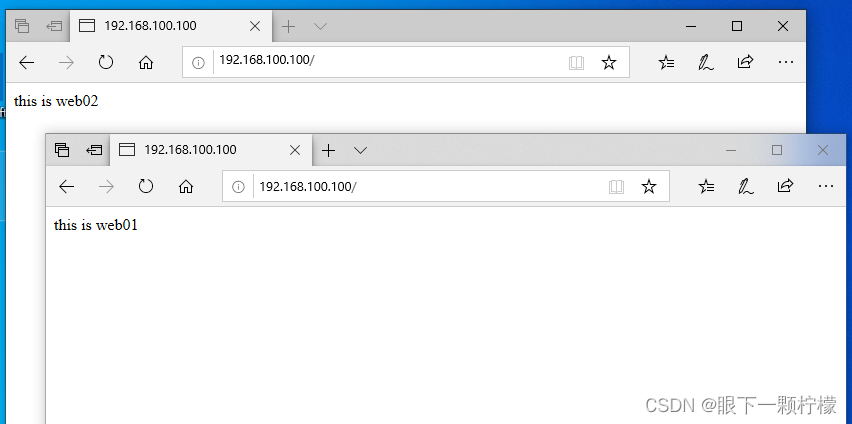

6.客户端测试

用一台win10机器(vmnet1网卡)

访问192.168.100.100

测试成功六、LVS-DR问题总结

1.LVS-DR如何处理请求报文,会修改IP包内容吗?

vs/dr本身不会关心IP层以上的信息,即使是端口号也是tcp/ip协议栈去判断是否正确,vs/dr本身主要做这么几个事:

接收client的请求,根据你设定的负载均衡算法选取一台realserver的ip;

以选取的这个ip对应的mac地址作为目标mac,然后重新将IP包封装成帧转发给这台RS;

在hash table中记录连接信息。

vs/dr做的事情很少,也很简单,所以它的效率很高,不比硬件负载均衡设备差多少,数据包、数据帧的大致流向是这样的:client –> VS –> RS –> clien2.Real Server为什么要在lo接口上配置VIP?在出口网卡上配置VIP可以吗?

既然要让RS能够处理目标地址为vip的IP包,首先必须要让RS能接收到这个包。在lo上配置vip能够完成接收包并将结果返回client。不可以将VIP设置在出口网卡上,否则会响应客户端的arp request,造成client/gateway arp table紊乱,以至于整个load balance都不能正常工作

3.Real Server为什么要一直arp帧?

我们知道仰制arp帧需要在server上执行以下命令,如下:

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce- 1

- 2

- 3

- 4

因为arp对逻辑口没有意义。实际上起作用的只有以下两条:

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce- 1

- 2

即对所有的物理网卡设置arp仰制。对仰制所有的物理网卡设置arp仰制是为了让CIP发送的请求顺利转交给DIR以及防止整个LVS环境arp表混乱,不然容易导致整个lvs不能工作

4.LVS/DR load balancer(director)与RS为什么要在同一网段中?

lvs/dr它是在数据链路层来实现的,即RIP必须能够接受到DIR的arp请求,如果不在同一网段则会隔离arp,这样arp请求就不能转发到指定的RIP上,所以director必须和RS在同一网段里面

5.为什么director上eth0接口除了VIP另外还要配一个ip(即DIP)?

如果是用了keepalived等工具做HA或者Load Balance,则在健康检查时需要用到DIP。 没有健康检查机制的HA或者Load Balance则没有存在的实际意义

6.director的vip的netmask一定要是255.255.255.255吗?

lvs/dr里,director的vip的netmask 没必要设置为255.255.255.255,director的vip本来就是要像正常的ip地址一样对外通告的,不要搞得这么特殊

7.RS设置lo:0而不设置ens33:0的原因

因为“负载调度机”转发时并不会改写数据包的目的IP,所以“节点服务器”收到的数据包的目的IP仍是“负载调度器”的虚拟服务IP。为了保证“节点服务器”能够正确处理该数据包,而不是丢弃,必须在“节点服务器”的环回网卡上绑定“负载调度器”的虚拟服务IP。这样“节点服务器”会认为这个虚拟服务IP是自己的IP,自己是能够处理这个数据包的。否则“节点服务器”会直接丢弃该数据包!

“节点服务器”上的业务进程必须监听在环回网卡的虚拟服务IP上,且端口必须和“负载调度机”上的虚拟服务端口一致。因为“负载调度机”不会改写数据包的目的端口,所以“节点服务器”服务的监听端口必须和虚拟服务端口一致,否则“节点服务器”会直接拒绝该数据包。

“节点服务器”处理完请求后,响应直接回给客户端,不再经过“负载调度机”。因为“节点服务器”收到的请求数据包的源IP是客户端的IP,所以理所当然“节点服务器”的响应会直接回给客户端,而不会再经过“负载调度机”。这时候要求“节点服务器”和客户端之间的网络是可达的。

“负载调度机”和“节点服务器”须位于同一个子网。因为“负载调度机”在转发过程中需要改写数据包的MAC为“节点服务器”的MAC地址,所以要能够查询到“节点服务器”的MAC。而要获取到“节点服务器”的MAC,则需要保证二者位于一个子网,否则“负载调度机”只能获取到“节点服务器”网关的MAC地址。

-

相关阅读:

简单记录一下Splunk ES 升级

MapStruct与lombok加载顺序问题与annotationProcessorPaths的关系?

《vue3第四章》Composition API 的优势,包含Options API 存在的问题、Composition API 的优势

论文笔记:ST2Vec: Spatio-Temporal Trajectory SimilarityLearning in Road Networks

软文怎样写?写软文的技巧是什么?

第三章 C程序设计

Android 12 进程native crash流程分析

从一个页面跳转到目标页面之后,对应的顶部路由高亮

Element封装Table和Pagination

etcd学习笔记 - 入门

- 原文地址:https://blog.csdn.net/S314118142/article/details/126744393