-

AI制药中的一些思考和想法

自监督直接和具体任务的结合(Task Related Self-Supervised Learning)是个可探索的方向,已经在很多任务中初露头角,也比较符合审稿人的口味。

自监督学习与vision transformer结合

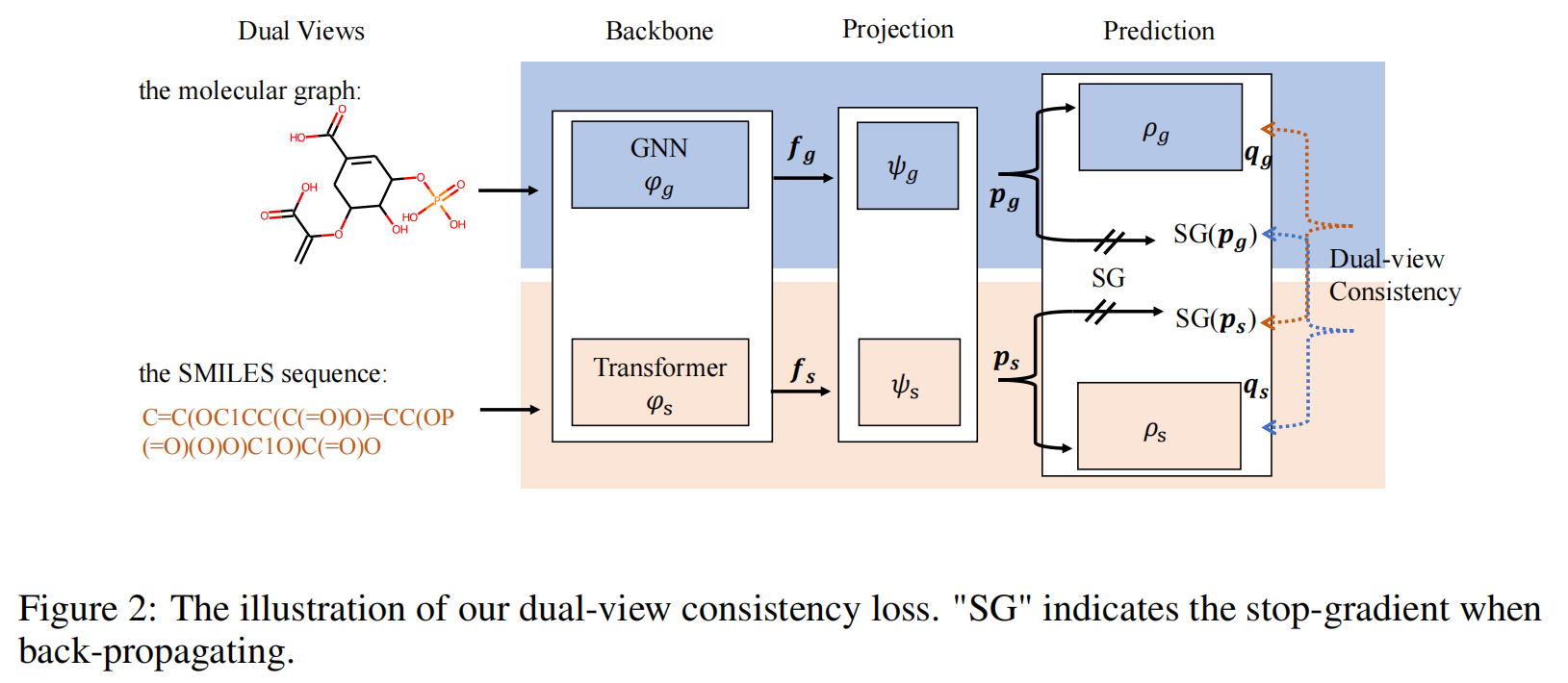

我们可以说 GNN 实际上偏爱结构丰富的分子。例如,三个以上的环串联在一起,但不利于链较长的分子。相比之下,transformer 偏爱相对较长的分子,但不偏爱具有重组的分子。它们是互补的,受此启发,我们提出了一个新模型,将这两种模型结合在一起。这就是我们称为双视图分子预训练的解决方案。

Dual-view molecule pre-training(双视图分子预训练)

原文使用的是第二种方式,我们是否可以将MCL改成第一种,或者他们的结合?

1、分子建模的第一种方式(通过1D的 SMILES mask)

如果我们把一个分子看作一个 SMILES 字符串,我们可以使用transformer来处理这个分子。让我们在这里以蛋白质为例。为了输入它的 SMILES 序列,我们随机屏蔽了一些标记,并使用transformer重建屏蔽标记。2、分子建模的第二种方式(通过2D的图像mask)

我们也可以将分子视为二维图。我们还可以mask一些原子和字母 G 模型来恢复被屏蔽的原子。对于未来,有很多有趣的方向,

首先,我们将在药物开发方面尝试multitasks,

其次是我们将设计更先进的模型。例如,如何设计更强大的 GNN 模型,以及如何使用单个模型同时涵盖 Transformer和 GNN。

第三,我们将尝试更多的数据。目前,我们使用了1 亿个数据,我们希望在未来尝试更多。局限性:

(1)在分子图像中整合更大规模的生物医学数据和更大容量的模型(如ViT)必然是工作的重点;

(2) multi-view learning of joint images 和 other representations(e.g. SMILES and graph)的多视图学习是一个重要的研究方向;

(3)引入更多的化学知识(包括原子性质、3D信息等)也是一个值得研究的问题。【将额外的化学知识(如原子属性和3D结构信息)集成到每个图像或像素区域可以进一步提高ImageMol的性能】 -

相关阅读:

【技术积累】Linux中的命令行【理论篇】【一】

JVM中jhat虚拟机堆转储快照分析工具

ndnSIM学习(十二)——底层数据包逐字节分析字段

QT商业播放器

家庭实验室系列文章-如何迁移树莓派系统到更大的 SD 卡?

qt+opengl 着色器VAO、VBO、EBO(四)

【Java】线程&程序计数器

GraalVM + Springboot3 + IDEA 在widow10 上完成构建本地化服务

【Rust】——【面向对象语言的特征】

RANKGEN: Improving Text Generation with Large Ranking Models论文

- 原文地址:https://blog.csdn.net/weixin_43135178/article/details/126469949