-

神经网络(五)卷积神经网络

一、前馈神经网络的缺点

①权重矩阵的参数非常多(每层之间两两连接)

②局部不变特征(难以提取不改变性质的操作<如旋转、缩放、平移>或局部特征)

二、卷积

给定一个输入信号序列x和滤波器w,卷积的输出为:

卷积的作用:

①近似微分

当令滤波器w=[1/2,0,-1/2]时,可以近似信号序列的一阶微分方程

当令滤波器w=[1,-2,1]时,可以近似信号序列的二阶微分

②低通滤波\高通滤波

滤波器w=[1/3,1/3,1/3]可以检测低频信息

滤波器w=[1,-2,1]可以检测高频信息

③卷积扩展

引入滤波器的滑动步长S和零填充P

滑动步长:窗口的长度

零填充:为了窗口取整,在两端补若干个0

④卷积类型

窄卷积:步长S=1,两端不补零P=0,输出长度为M-K+1

宽卷积:步长S=1,两端补零P=K-1,输出长度为M+K-1

等宽卷积:步长S=1,两端补零P=(K-1)/2,输出长度M

⑤二维卷积

Y=W*X

三、卷积神经网络

是一种前馈神经网络;受生物学感受野机制(只有特定区域接收刺激才能激活神经元)提出

特征: ①局部连接 ②权重共享 ③空间或时间上的次采样

使用卷积层代替全连接层

①互相关

计算卷积需要进行卷积核翻转;卷积操作的目标:提取特征-->并不一定需要翻转

互相关:

除非特别申明,卷积一般指“互相关”

除非特别申明,卷积一般指“互相关”②多个卷积核

卷积核可以视为一个特征提取器,为了增强卷积层的能力,可以引入多个卷积核

以二维为例:特征映射(图像讲过卷积后得到的特征)

卷积层输入:D个特征映射M × N × D

卷积层输出:P个特征映射

M ′ × N ′ \timeP " role="presentation">③卷积层的映射关系

各输入信号通过卷积后,再汇总得到输出信号,虽然卷积方式为单连接,但是输出和输入之间可以等效为全连接。

典型的卷积层为3维结构

④汇聚层

卷积层的作用:减少连接数量(但无法减少特征映射的神经元)

可以通过增加步长来减少神经元的数量

汇聚:将数据划分为若干区域,每个区域选取一个具有代表性的数据

⑤卷积神经网络的结构

卷积层 + 汇聚层 + 全连接层 堆叠形成

典型结构: ①趋于小卷积、大深度

②趋于全卷积

四、特殊的卷积神经网络

①空洞卷积

作用:增加输出单元的感受野

在卷积核中插入空洞,变相的增加卷积核的大小(投射的时候增加空位)

②转置卷积/微步卷积

低维特征映射到高维特征(放大)

减小步长,在输入上插入空洞(S=1/2)

五、经典卷积神经网络

1.LeNet-5

LeNet-5主要用于识别手写数字,共7层

2.AlexNet

使用GPU进行并行训练,采用ReLU作为非线性激活函数,使用Dropout防止过拟合

一共5个卷积层、3个汇聚层、3个全连接层

3.Inception网络

由大量的inception模块和少量的汇聚层堆叠而成

inception模块

包含多个大小不同的卷积操作(1x1、3x3、5x5等大小不同的卷积核),并将得到的特征映射在深度上拼接(堆叠)起来作为输出特征映射。

1X1的作用:让不同深度的特征进行融合

inception模块V3

用多层的小卷积核来替代大的卷积核,减少计算量和参数量(两层3X3来替代5X5,用连续的nX1和1Xn替代nXn)

4.残差网络(ResNet)

层数极多(152层)

通过给非线性卷积层增加直连边来提高信息的传播率

将目标函数拆分为两个部分:恒等函数、残差函数

残差单元

由于每个单元有一条直连边(x),所以即使堆叠得很深也不会出现梯度消失的问题。

六、卷积在文本上的应用

1.Ngram特征与卷积

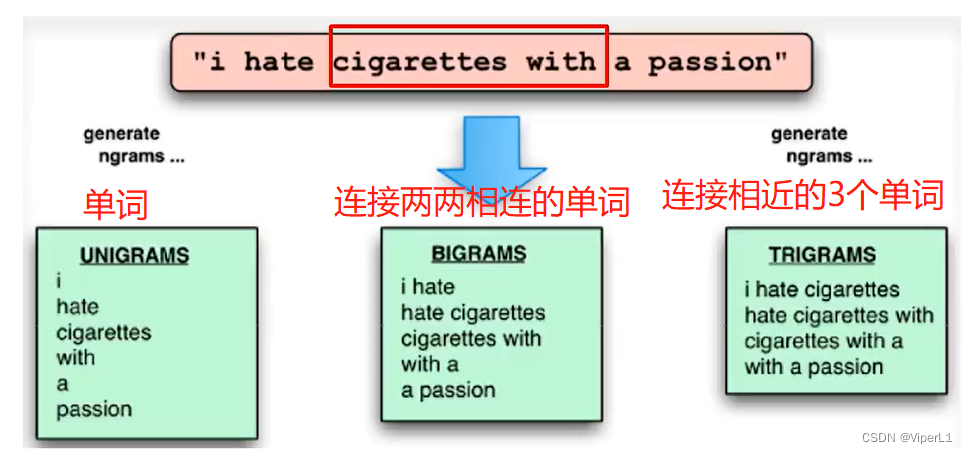

Ngram:连接相邻的n个单词(滑动窗口)

2.文本序列的卷积

使用Lookuptable将词转换为向量。

可将其视为一维卷积(窗口大小为k,深度为d)或二维卷积(卷积核大小为dxk)

3.基于卷积模型的句子表示

4.文本序列的卷积模型

-

相关阅读:

【语音识别】基于动态时间规整算法(DTW)实现中文语音识别系统含Matlab源码

java毕业设计俄语等级考试管理系统.Mybatis+系统+数据库+调试部署

python面向对象之类和对象相关知识

牛客NC233 加起来和为目标值的组合(四)【中等 DFS C++、Java、Go、PHP】

在vscode中配置ros环境

docker安装nacos

Java手写双向广度优先和双向广度优先应用拓展案例

【MySQL】字符串截取函数 SUBSTR() 详解

吃鸡大作战:绝密攻略《揭秘吃鸡要领与细节,国际服全方位指南只在此!

数据结构:二叉树(3):相关oj题目

- 原文地址:https://blog.csdn.net/weixin_37878740/article/details/126447572