-

【PyTorch】深度学习实践之多维度输入Multiple Dimension Input

多维度特征的数据集

每一行代表一个样本,每一列代表一重要特征Feature

![[图片]](https://1000bd.com/contentImg/2024/03/29/da2b5454416082fa.png)

![[图片]](https://1000bd.com/contentImg/2024/03/29/4f8fbd171026915a.png)

在机器学习和数据库中处理数据的方式略有不同。在机器学习里面,拿到数据表之后,把内容分成两部分,一部分作为输入x,另一部分作为输入y。如果训练是从数据库读数据,就把x读出来构成一个矩阵,把y字段读出来构成一个矩阵,就把输入的数据集准备好了。

如下图:Anaconda的安装目录下已经给我们准备好了一些数据集,gz是linux下非常流行的压缩格式。

![[图片]](https://1000bd.com/contentImg/2024/03/29/b6d61cd4b56981e0.png)

一个样本多个特征的计算图,如图所示:

![[图片]](https://1000bd.com/contentImg/2024/03/29/63362507c41a4e10.png)

多个样本多个特征的计算图,如下:

![[图片]](https://1000bd.com/contentImg/2024/03/29/e5427236e6be4152.png)

模型采用一层线性函数self.linear = torch.nn.Linear(8, 1),函数的输入的特征维度为8,输出的维度为1,如下图:

![[图片]](https://1000bd.com/contentImg/2024/03/29/50a1048b4ac3aaaf.png)

中间线性层加入了sigmoid非线性函数进行非线性变化。

![[图片]](https://1000bd.com/contentImg/2024/03/29/c54b96e392ccc632.png)

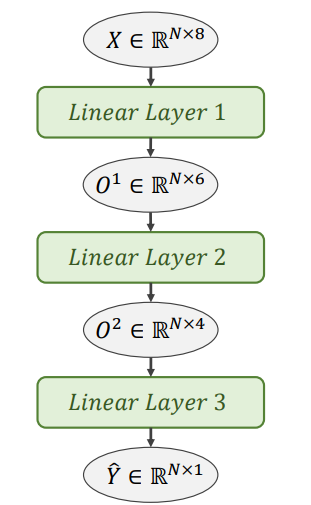

多层神经网络的计算图

中间隐层越多,中间步骤越多,神经元越多,学习能力越强。与此同时,也会学会更多噪声。

![[图片]](https://1000bd.com/contentImg/2024/03/29/02c99d404e3ba9cd.png)

![[图片]](https://1000bd.com/contentImg/2024/03/29/5bb78b42eb911316.png)

实现糖尿病预测:

代码:

![[图片]](https://1000bd.com/contentImg/2024/03/29/9fb9a088f1946c6a.png)

import numpy as np import torch import matplotlib.pyplot as plt #1.Prepare Dataset xy = np.loadtxt('diabetes.csv.gz', delimiter=',', dtype=np.float32) x_data = torch.from_numpy(xy[:,:-1]) y_data = torch.from_numpy(xy[:, [-1]]) #2. Define Model class Model(torch.nn.Module): def __init__(self): super(Model, self).__init__() self.linear1 = torch.nn.Linear(8, 6) self.linear2 = torch.nn.Linear(6, 4) self.linear3 = torch.nn.Linear(4, 1) self.sigmoid = torch.nn.Sigmoid() def forward(self, x): x = self.sigmoid(self.linear1(x)) x = self.sigmoid(self.linear2(x)) x = self.sigmoid(self.linear3(x)) return x model = Model() #3.Construct Loss and Optimizer criterion = torch.nn.BCELoss(size_average=True) optimizer = torch.optim.SGD(model.parameters(), lr=0.1) #4. Train Cycle epoch_list=[] loss_list=[] for epoch in range(100): # Forward y_pred = model(x_data) loss = criterion(y_pred, y_data) print(epoch, loss.item()) # Backward optimizer.zero_grad() loss.backward() # Update optimizer.step() epoch_list.append(epoch+1) loss_list.append(loss.item()) # 画图 plt.plot(epoch_list,loss_list) plt.xlabel("epoch") plt.ylabel("'loss") plt.grid() plt.show()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

结果:

![[图片]](https://1000bd.com/contentImg/2024/03/29/fa4454805e6784fa.png)

补充知识:

查看参数

- 如果想查看某些层的参数,以神经网络的第一层参数为例,可按照以下方法进行:

# 参数说明 # 第一层的参数: layer1_weight = model.linear1.weight.data layer1_bias = model.linear1.bias.data print("layer1_weight", layer1_weight) print("layer1_weight.shape", layer1_weight.shape) print("layer1_bias", layer1_bias) print("layer1_bias.shape", layer1_bias.shape)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

![[图片]](https://1000bd.com/contentImg/2024/03/29/b48992d4edfa1ab2.png)

更改评估指标

- 更改epoch为100000,以准确率acc为评价指标,源代码和结果如下:

import numpy as np import torch import matplotlib.pyplot as plt # prepare dataset xy = np.loadtxt('diabetes.csv', delimiter=',', dtype=np.float32) x_data = torch.from_numpy(xy[:, :-1]) # 第一个‘:’是指读取所有行,第二个‘:’是指从第一列开始,最后一列不要 print("input data.shape", x_data.shape) y_data = torch.from_numpy(xy[:, [-1]]) # [-1] 最后得到的是个矩阵 # print(x_data.shape) # design model using class class Model(torch.nn.Module): def __init__(self): super(Model, self).__init__() self.linear1 = torch.nn.Linear(8, 6) self.linear2 = torch.nn.Linear(6, 4) self.linear3 = torch.nn.Linear(4, 2) self.linear4 = torch.nn.Linear(2, 1) self.sigmoid = torch.nn.Sigmoid() def forward(self, x): x = self.sigmoid(self.linear1(x)) x = self.sigmoid(self.linear2(x)) x = self.sigmoid(self.linear3(x)) # y hat x = self.sigmoid(self.linear4(x)) # y hat return x model = Model() # construct loss and optimizer # criterion = torch.nn.BCELoss(size_average = True) criterion = torch.nn.BCELoss(reduction='mean') optimizer = torch.optim.SGD(model.parameters(), lr=0.1) # training cycle forward, backward, update for epoch in range(100000): y_pred = model(x_data) loss = criterion(y_pred, y_data) # print(epoch, loss.item()) optimizer.zero_grad() loss.backward() optimizer.step() if epoch%100000 == 99999: y_pred_label = torch.where(y_pred>=0.5,torch.tensor([1.0]),torch.tensor([0.0])) acc = torch.eq(y_pred_label, y_data).sum().item()/y_data.size(0) print("loss = ",loss.item(), "acc = ",acc)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

![[图片]](https://1000bd.com/contentImg/2024/03/29/7796aa45fcbf3d46.png)

练习:尝试不同的激活函数

采用不同的激活函数进行训练,并画出不同激活函数的损失曲线进行比较。

![[图片]](https://1000bd.com/contentImg/2024/03/29/614c039858545fb6.png)

![[图片]](https://1000bd.com/contentImg/2024/03/29/7e37499b9bffa9b8.png)

tips:

注意:(激活函数种类很多,采用RuLU激活函数时需要注意)

现在非常流行使用RuLU激活函数,但是RuLU存在的问题是当激活函数的输入为小于0时,激活函数的梯度就变为0,不会继续更新维度,所以采用RuLU需要注意。

一般如果做分类,采用RuLU激活函数都是在前面的层数,最后一层激活函数不要使用RuLU,一般会采用sigmoid的。代码:

数据集diabetes.csv.gz需要在anaconda中找到放在代码目录下。

激活函数最后一层统一采用sigmoid。import numpy as np import torch import matplotlib.pyplot as plt #1.Prepare Dataset xy = np.loadtxt('diabetes.csv.gz', delimiter=',', dtype=np.float32) x_data = torch.from_numpy(xy[:,:-1]) y_data = torch.from_numpy(xy[:, [-1]]) #2. Define Model class Model(torch.nn.Module): def __init__(self): super(Model, self).__init__() self.linear1 = torch.nn.Linear(8, 6) self.linear2 = torch.nn.Linear(6, 4) self.linear3 = torch.nn.Linear(4, 1) self.activate = torch.nn.ReLU() def forward(self, x): x = self.activate(self.linear1(x)) x = self.activate(self.linear2(x)) x = F.sigmoid(self.linear3(x)) return x model = Model() #3.Construct Loss and Optimizer criterion = torch.nn.BCELoss(size_average=True) optimizer = torch.optim.SGD(model.parameters(), lr=0.1) #4. Train Cycle epoch_list=[] loss_relu=[] for epoch in range(100): # Forward y_pred = model(x_data) loss = criterion(y_pred, y_data) print(epoch, loss.item()) # Backward optimizer.zero_grad() loss.backward() # Update optimizer.step() epoch_list.append(epoch+1) loss_relu.append(loss.item()) # 画图 plt.plot(epoch_list,loss_relu) plt.xlabel("epoch") plt.ylabel("'loss") plt.grid() plt.show()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

结果:

-

Sigmoid

![[图片]](https://1000bd.com/contentImg/2024/03/29/b9ee540cc49e51b3.png)

-

ReLu

![[图片]](https://1000bd.com/contentImg/2024/03/29/91ce4652e4b4f887.png)

学习资料

- https://blog.csdn.net/qq_42585108/article/details/108150913

- https://blog.csdn.net/qq_42764492/article/details/112745651

- https://blog.csdn.net/bit452/article/details/109682078?spm=1001.2101.3001.6650.3&utm_medium=distribute.pc_relevant.none-task-blog-2%7Edefault%7ECTRLIST%7ERate-3-109682078-blog-123956650.pc_relevant_multi_platform_whitelistv3&depth_1-utm_source=distribute.pc_relevant.none-task-blog-2%7Edefault%7ECTRLIST%7ERate-3-109682078-blog-123956650.pc_relevant_multi_platform_whitelistv3&utm_relevant_index=5

系列文章索引

教程指路:【《PyTorch深度学习实践》完结合集】 https://www.bilibili.com/video/BV1Y7411d7Ys?share_source=copy_web&vd_source=3d4224b4fa4af57813fe954f52f8fbe7

-

相关阅读:

OpenGLES:单纹理贴图

【C#排序算法】(二)插入排序

Java责任链模式

三大网络简介

导电滑环材料选型要注意的因素

Java使用FFmpeg对视频文件打标记

C语言之文件操作【万字详解】

TensorRT Build Samples for QNX AArch64

HTML(23)——垂直对齐方式

字符串Hash学习笔记

- 原文地址:https://blog.csdn.net/qq_43800119/article/details/126415596