标题党一下,顺便蹭一下 OpenAI Sora大模型的热点,主要也是回顾一下扩散模型的原理。

1. 简单理解扩散模型

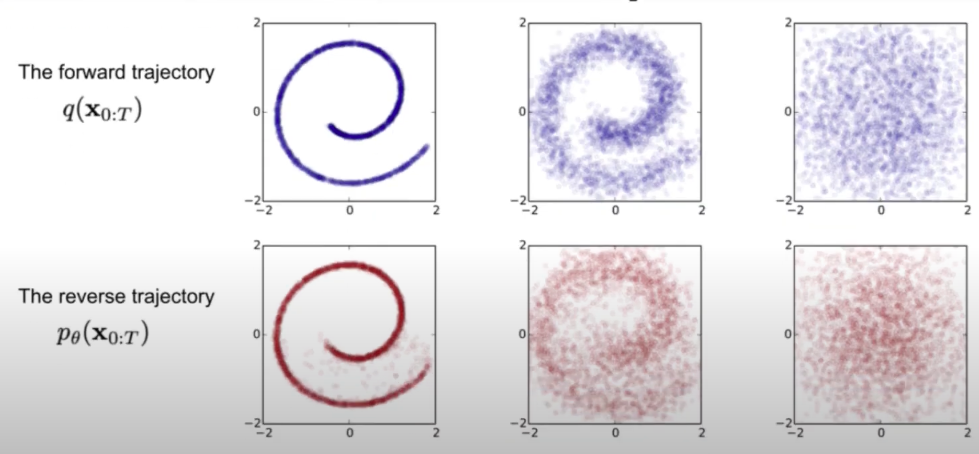

简单理解,扩散模型如下图所示可以分成两部分,一个是 forward,另一个是 reverse 过程:

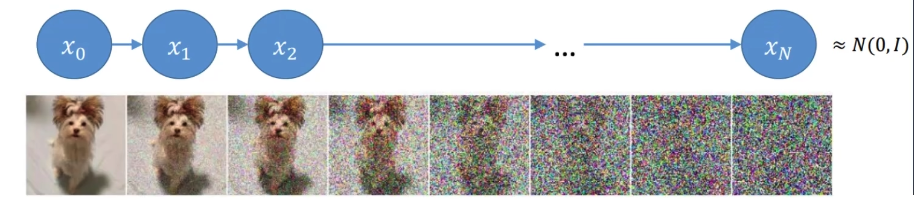

- forward:这是加噪声的过程,表示为q(X0:T),即在原图(假设是t0时刻的数据,即X0)的基础上分时刻(一般是 T 个时刻)逐步加上噪声数据,最终得到tT时刻的数据XT。具体来说我们每次加一点噪声,可能加了 200 次噪声后得到服从正态分布的隐变量,即Xt=X0+z0+z1+...+zt−1每个时刻加的噪声会作为标签用来在逆向过程的时候训练模型。

- reverse:这很好理解,其实就是去噪过程,是q(X0:T)的逆过程,表示为Pθ(X0:T),即逐步对数据XT逆向地去噪,尽可能还原得到原图像。逆向过程其实就是需要训练一个模型来预测每个时刻的噪声 zT,从而得到上一时刻的图像,通过迭代多次得到原始图像,即X0=Xt−zt−zt−2−...−z1。模型训练会迭代多次,每次的输入是当前时刻数据Xt,输出是噪声zt,对应标签数据是¯zt−1,损失函数是mse(zt,¯zt−1)

怎么理解这两个过程呢?一种简单的理解方法是我们可以假设世界上所有图像都是可以通过加密(就是 forward 过程)表示成隐变量,这些隐变量人眼看上去就是一堆噪声点。我们可以通过神经网络模型逐渐把这些噪声去掉,从而得到对应的原图(即 reverse 过程)。

2. 前向过程的数学表示

前向过程简单理解就是不断加噪声,加噪声的特点是越加越多:

- 前期加的噪声要少一点,这样是为了避免加太多噪声会导致模型不太好学习;

- 而当噪声量加的足够多后应该增加噪声的量,因为如果还是每次只加一点点,其实差别不大,而且这会导致前向过程太长,那么对应逆向过程也长,最终会增加计算量。所以噪声的量会有超参数βt控制。t 越大,βt的值也就越大。

那我们可以很自然地知道,t 时刻的图像应该跟 t-1时刻的图像和噪声相关,所以有

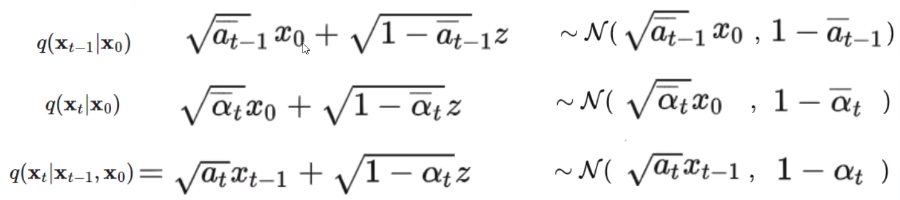

其中αt=1−βt, z1是服从 (0,1) 正太分布的随机变量。常见的参数设置是βt从 0.0001 逐渐增加到0.002,所以αt对应越来越小,也就是说噪声的占比逐渐增大。

我们同样有Xt−1=√αt−1Xt−2+√1−αt−1z2,此时我们有

因为z1,z2都服从正太分布,且N(0,σ21)+N(0,σ22)∼N(0,(σ21+σ22)),所以公式(2)的括号内的两项之和得到一个新的服从均值为 0, 方差是√(at(1−αt−1)2+√1−αt2=1−αtαt−1的变量˜z2∼N(0,1−αtαt−1)。

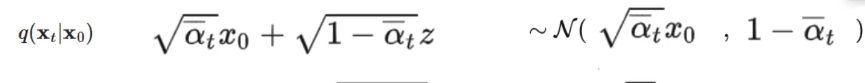

我们不断递归能够得到Xt和X0的关系如下:

其中¯αt=αtαt−1...α1, ¯zt是均值为 0,方差σ=1−¯αt的高斯变量, zt服从(0,1)正态分布。可以看到给定0 时刻的图像数据X0,我们可以求得任意t时刻的¯αt和与之有关的¯zt,进而得到对应的Xt数据,至此前向过程就结束了。

3. 逆向过程的数学表示

3.1 贝叶斯公式求解

扩散模型在应用的时候主要就是 reverse 过程,即给定一组随机噪声,通过逐步的还原得到想要的图像,可以表示为q(X0|Xt)。但是很显然,我们无法直接从 T 时刻还原得到 0 时刻的数据,所以退而求其次,先求q(Xt−1|Xt)。但是这个也没那么容易求得,但是由贝叶斯公式我们可以知道

我们这里考虑扩散模型训练过程,我们默认是知道Xo的,所以有

解释一下上面的公式:因为我们可以人为设置噪声分布,所以正向过程中每个时刻的数据也是知道的。例如,假设噪声z是服从高斯分布的,那么X1=X0+z,所以q(X1,X0)是可以知道的,同样q(Xt−1,X0),q(Xt,X0)也都是已知的,更一般地,q(Xt|Xt−1,X0)也是已知的。所以上面公式的右边三项都是已知的,要计算出左边的结果,就只需要分别求出右边三项的数学表达式了。

上面三个公式是推导后的结果,省略了亿些步骤,我们待会解释怎么来的,这里先简单解释一下含义,我们看第一行,z就是服从正态分布(均值为 0,方差为 1)的变量,为方便理解其它的可以看成常数,我们知道 a+√bz会得到均值为 a,方差为 b 的服从高斯分布的变量,那么第一行最右边的高斯分布应该就好理解了。其余两行不做赘述,同理。

3.2 高斯分布概率密度分布计算

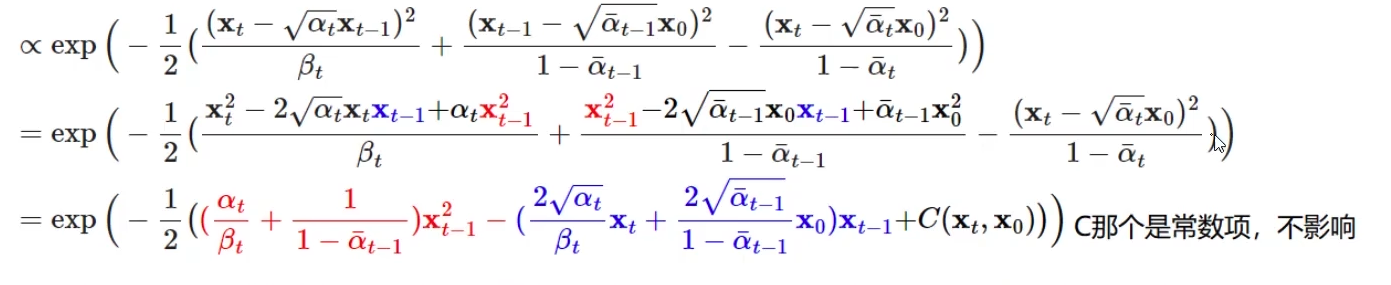

下面公式中左边的概率分布其实就是右边三项概率分布的计算结果。

我们假设了噪声数据服从高斯分布N(μ,σ2),并且知道高斯分布的概率密度函数是exp(−12(x−μ)2σ2)。结合上面已经给出的三项的高斯分布情况,例如

我们可以求得q(Xt|X0)的概率密度函数为exp(−12(Xt−√¯atX0)21−¯at),其它两项同理,它们计算后得到的最终的概率密度函数为:

其中上面公式中βt=1−αt。接着我们把上面公式的平方项展开,以Xt−1为变量(因为此时我们的目的是求得Xt−1)合并同类项整理一下最后可以得到

我们在对比一下exp(−12(x−μ)2σ2)=exp(−12(1σ2x2−2μσ2x+μ2σ2))就能知道上面公式中对应的方差和均值:

- 方差

方差等式中的α,β都是与分布相关的固定值,即给定高斯分布后,这些变量的值是固定的,所以方差是固定值。

- 均值

均值跟Xt和X0有关 ,但是此时的已知量是Xt,而X0是未知的。不过我们可以估计一下X0的值,通过前向过程我们知道 Xt=√¯atX0+√1−¯atzt,那么可以逆向估计一下 X0=1√¯at(Xt−√1−¯atzt)。不过需要注意的是,这里的X0只是通过Xt估算得到的,并不是真实值。所以均值表达式还可以进一步简化,即

每个时刻的均值和方差的表达式就都有了。不过,每个时刻的方差是个定值,很容易求解,而均值却跟变量zt相关。如果能求解得到zt,那么只要给定一个t 时刻的随机噪声填满的图像Xt,我们就能知道该时刻噪声的均值和方差,那么我们就可以通过采样得到上一时刻的噪声数据

ϵ是服从(0,1)的正态分布的随机变量。至此,我们只需要引入神经网络模型来预测 t 时刻的zt,即zt=diffusion_model(xt),模型训练好后就能得到前一时刻的Xt−1了。

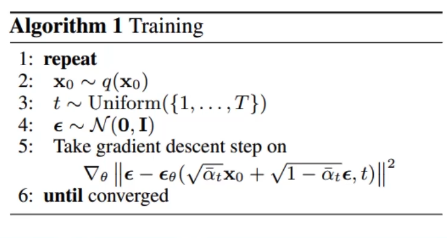

那么要训练模型,我们肯定得有标签和损失函数啊。具体而言:

- xt是模型的输入

- zt就是模型的输出

- 标签其实就是 forward 过程中每个时刻产生的噪声数据ˆzt

- 所以损失函数等于loss=mse(zt,ˆzt)

4. 代码实现

接下来我们结合代码来理解一下上述过程。

4.1 前向过程(加噪过程)

给定原始图像X0和加噪的超参数αt=1−βt可以求得任意时刻对应的加噪后的数据Xt,即

其中¯αt=αtαt−1...α1, ¯zt是均值为 0,标准差σ=√1−¯αt的高斯变量。

下面是具体的代码实现,首先是与噪声相关超参数的设置和提前计算:

from PIL import Image

接下来是具体的前向过程的计算,其中get_index_from_list函数是为了快速获得指定 t 时刻对应的超参数的值,支持批量图像操作。forward_diffusion_sample则是前向扩散采样函数。

def get_index_from_list(vals, time_step, x_shape):

4.2 训练

我们忽略具体的模型结构细节,先看看训练流程是怎样的:

if __name__ == "__main__":

这里我们忽略模型架构的具体细节,只需要知道每次模型的计算需要 噪声图像(x_noisy) 和 对应的时刻t即可。

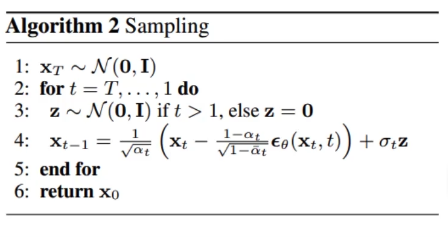

4.2 逆向过程(去噪采样过程)

给定某一时刻的数据Xt,该时刻的均值μ和方差σ如下

通过对N(˜μt,˜σ2t)分布进行采样得到上一时刻的数据Xt−1=˜μt+˜σtϵ,zt是模型训练收敛后,在给定噪声图像和对应时刻 t 后计算得到的噪声数据,ϵ是正态分布随机变量。

实现代码如下:

@torch.no_grad()

5. 总结

- 前向过程:

给定原始图像X0和加噪的超参数αt=1−βt可以求得任意时刻对应的加噪后的数据Xt,即

其中¯αt=αtαt−1...α1, ¯zt是均值为 0,标准差σ=√1−¯αt的高斯变量。

- 逆向过程

给定某一时刻的数据Xt,该时刻的均值μ和方差σ如下

通过对N(˜μt,˜σ2t)分布进行采样得到上一时刻的数据Xt−1=˜μt+˜σtϵ,zt是模型训练收敛后,在给定噪声图像和对应时刻 t 后计算得到的噪声数据,ϵ是正态分布随机变量。迭代 t 次后即可得到 0 时刻的图像了。

参考

- 文章参考:https://www.bilibili.com/video/BV14o4y1e7a6/?vd_source=ab1abaf624904be0ec84e180d5b6bd9a

- 代码参考:https://github.com/chunyu-li/ddpm/blob/HEAD

__EOF__