-

时序预测 | MATLAB实现基于LSTM-AdaBoost长短期记忆网络结合AdaBoost时间序列预测

时序预测 | MATLAB实现基于LSTM-AdaBoost长短期记忆网络结合AdaBoost时间序列预测

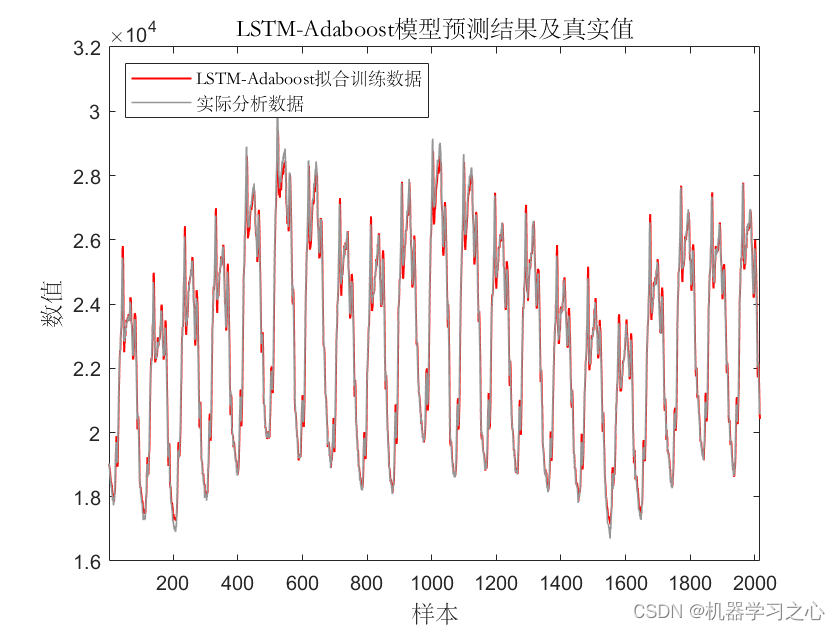

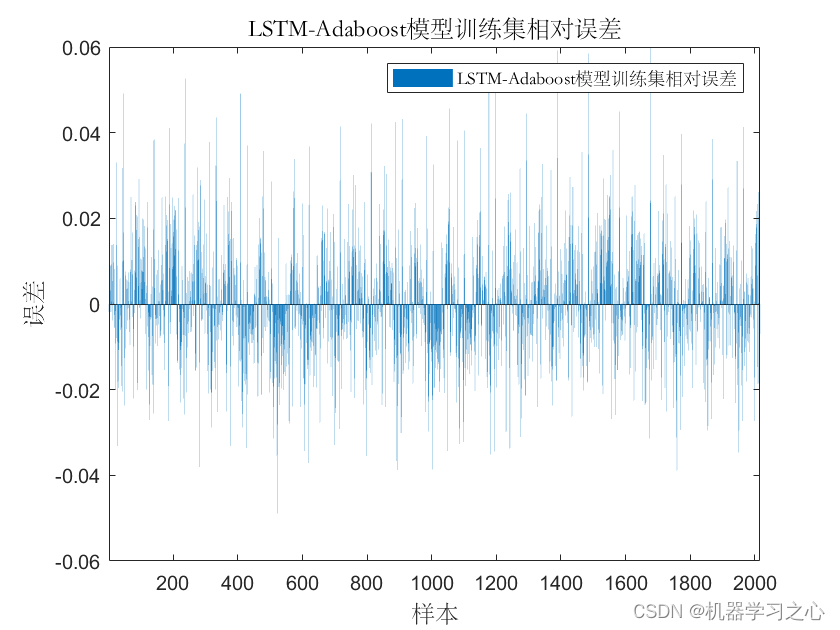

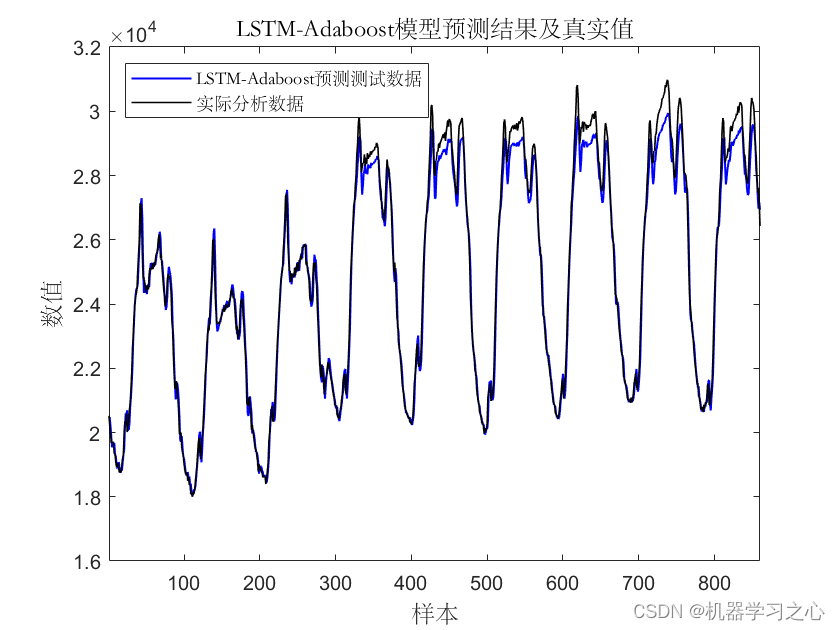

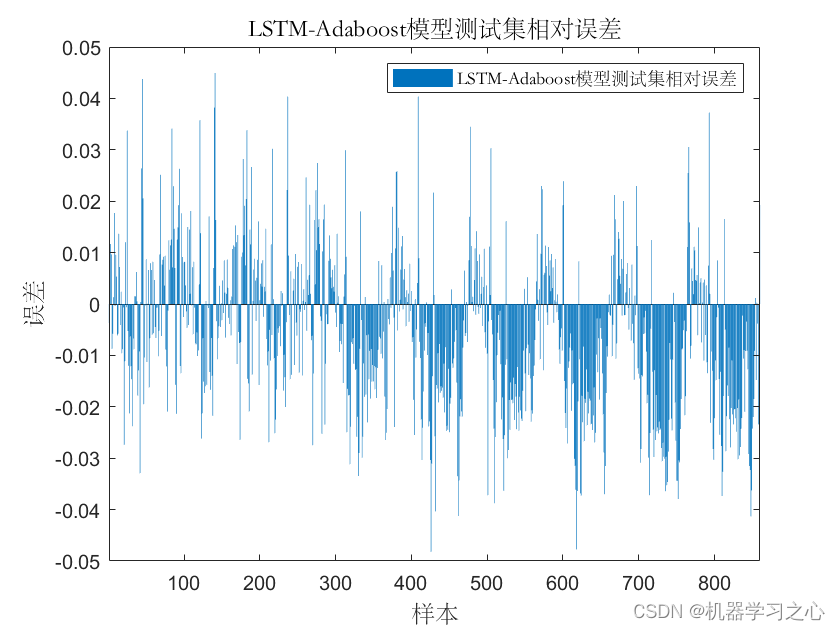

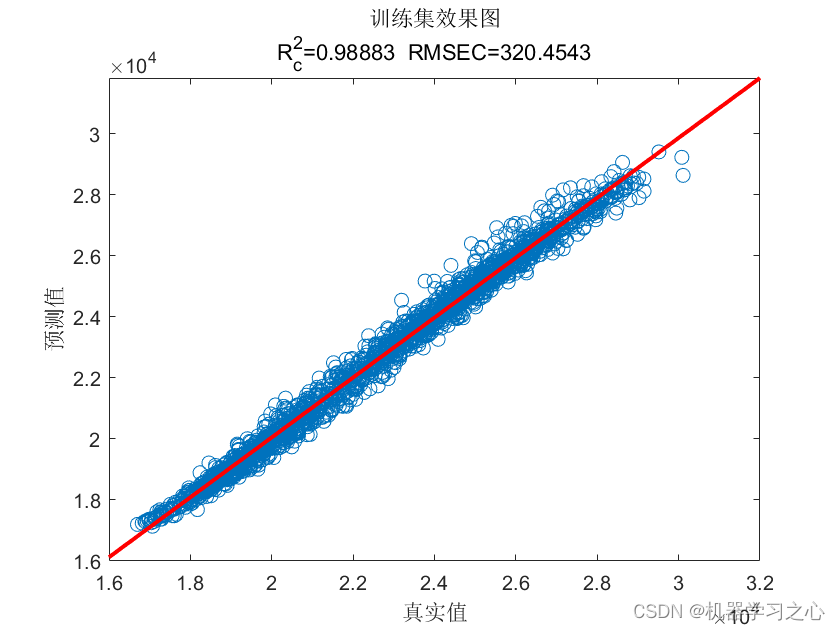

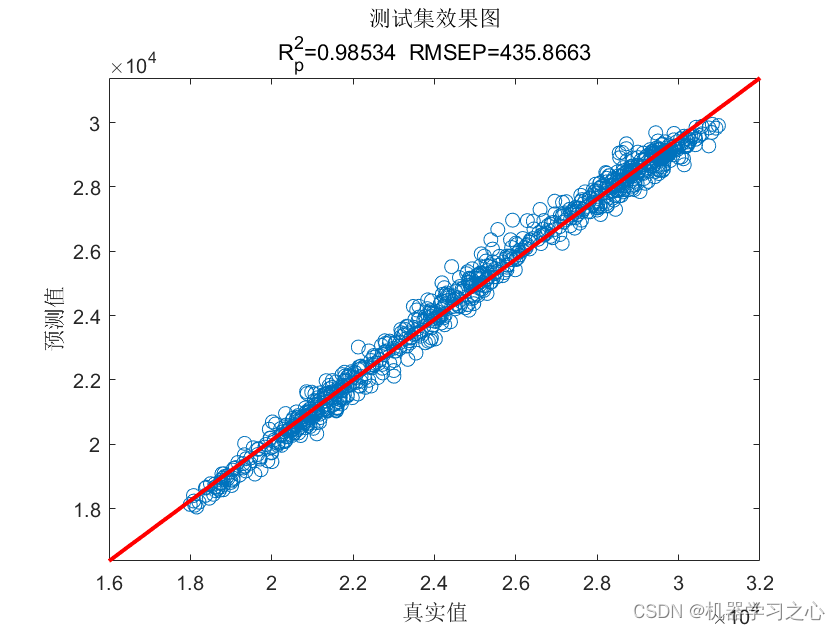

预测效果

x

基本介绍

1.Matlab实现LSTM-Adaboost时间序列预测,长短期记忆神经网络结合AdaBoost时间序列预测(风电功率预测);

2.运行环境为Matlab2020b;

3.data为数据集,excel数据,单变量时间序列数据,LSTM_AdaboostTS.m为主程序,运行即可,所有文件放在一个文件夹;

4.命令窗口输出R2、MAE、MAPE、RMSE多指标评价;模型描述

LSTM-AdaBoost是一种将LSTM和AdaBoost两种机器学习技术结合起来使用的方法,旨在提高模型的性能和鲁棒性。具体而言,AdaBoost则是一种集成学习方法,它将多个弱学习器组合起来形成一个强学习器,其中每个学习器都是针对不同数据集和特征表示训练的。LSTM-AdaBoost算法的基本思想是将LSTM作为基模型,利用AdaBoost算法对其进行增强。具体而言,我们可以训练多个LSTM模型,每个模型使用不同的数据集和特征表示,然后将它们的预测结果组合起来,形成一个更准确和鲁棒的模型。

程序设计

- 完整源码和数据获取方式:私信博主回复MATLAB实现基于LSTM-AdaBoost长短期记忆网络结合AdaBoost时间序列预测。

%% 预测 t_sim1 = predict(net, p_train); t_sim2 = predict(net, p_test ); %% 数据反归一化 T_sim1 = mapminmax('reverse', t_sim1, ps_output); T_sim2 = mapminmax('reverse', t_sim2, ps_output); %% 均方根误差 error1 = sqrt(sum((T_sim1' - T_train).^2) ./ M); error2 = sqrt(sum((T_sim2' - T_test ).^2) ./ N); %% 相关指标计算 % R2 R1 = 1 - norm(T_train - T_sim1')^2 / norm(T_train - mean(T_train))^2; R2 = 1 - norm(T_test - T_sim2')^2 / norm(T_test - mean(T_test ))^2; disp(['训练集数据的R2为:', num2str(R1)]) disp(['测试集数据的R2为:', num2str(R2)]) % MAE mae1 = sum(abs(T_sim1' - T_train)) ./ M ; mae2 = sum(abs(T_sim2' - T_test )) ./ N ; disp(['训练集数据的MAE为:', num2str(mae1)]) disp(['测试集数据的MAE为:', num2str(mae2)]) %% 平均绝对百分比误差MAPE MAPE1 = mean(abs((T_train - T_sim1')./T_train)); MAPE2 = mean(abs((T_test - T_sim2')./T_test)); disp(['训练集数据的MAPE为:', num2str(MAPE1)]) disp(['测试集数据的MAPE为:', num2str(MAPE2)]) % MBE mbe1 = sum(abs(T_sim1' - T_train)) ./ M ; mbe2 = sum(abs(T_sim1' - T_train)) ./ N ; disp(['训练集数据的MBE为:', num2str(mbe1)]) disp(['测试集数据的MBE为:', num2str(mbe2)]) %均方误差 MSE mse1 = sum((T_sim1' - T_train).^2)./M; mse2 = sum((T_sim2' - T_test).^2)./N; disp(['训练集数据的MSE为:', num2str(mse1)]) disp(['测试集数据的MSE为:', num2str(mse2)])- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/128577926?spm=1001.2014.3001.5501

[2] https://blog.csdn.net/kjm13182345320/article/details/128573597?spm=1001.2014.3001.5501 -

相关阅读:

pandas笔记:读写excel

Kotlin 数据类型详解:数字、字符、布尔值与类型转换指南

C语言实现一个简单的点歌系统

稠密连接网络(DenseNet)

【leetcode】【剑指offer Ⅱ】045. 二叉树最底层最左边的值

Arduino之ESP8266编程学习总结体会

使用Ceres进行slam必须要弄清楚的几个类和函数

【教程】EasyConnect 在 20.04.1-Ubuntu 安装实战

睡眠剥夺后皮层微结构的广泛变化

JavaCV人脸识别三部曲之二:训练

- 原文地址:https://blog.csdn.net/kjm13182345320/article/details/134539154