-

Ceph应用

Ceph应用

一、资源池 Pool 管理

Pool 数据池/资源池/存储池,可理解成一个存放PG的命名空间,一个Pool可以多个PG,不同Pool的PG可以同名- 1

1.1、ceph存储池概念

首先我们需要在 Ceph 中定义一个 Pool 资源池 Pool 是 Ceph 中存储 Object 对象抽象概念 我们可以将其理解为 Ceph 存储上划分的逻辑分区,Pool 由多个 PG 组成 而 PG 通过 CRUSH 算法映射到不同的 OSD 上 同时 Pool 可以设置副本 size 大小,默认副本数量为 3。- 1

- 2

- 3

- 4

- 5

1.2、原理

- Ceph 客户端向 monitor 请求集群的状态,并向 Pool 中写入数据,数据根据 PGs 的数量,通过 CRUSH 算法将其映射到不同的 OSD 节点上,实现数据的存储。

- 这里我们可以把 Pool 理解为存储 Object 数据的逻辑单元;当然,当前集群没有资源池,因此需要进行定义。

1.3、 一个Pool资源池应该包含多少PG数?

OSD总数 PG数 小于 5 个 推荐为 128 5~10 个 推荐为 512 10~50 个 推荐为 4096 大于 50 个 参考公式 ( Target PGs per OSD ) x ( OSD # ) x ( %Data ) / ( Size ) ##公式详解## -Target PGs per OSD # 每个OSD对应的PG数(近期不扩容OSD数量设置为100,近期要扩容OSD数量设置为200) -OSD #OSD总数 -%Data #当前Pool会占用Ceph集群总空间的百分比 -Size #当前Pool的副本数 #举个例子 100 * 60 * 50% / 3 = 1000 ->取最接近2的次方值 1024- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

1.4、 Ceph 存储池相关管理命令

1.4.1、 创建

#创建一个 Pool 资源池 #其名字为 mypool #PGs 数量设置为 64, #设置 PGs 的同时还需要设置 PGP(通常PGs和PGP的值是相同的): #PG (Placement Group),pg 是一个虚拟的概念,用于存放 object,PGP(Placement Group for Placement purpose),相当于是 pg 存放的一种 osd 排列组合 cd /etc/ceph ceph osd pool create mypool 64 64- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

1.4.2、 查看

#查看集群 Pool 信息 #方式一 ceph osd pool ls #方式二 rados lspools #方式三 ceph osd lspools- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

#查看资源池副本的数量 ceph osd pool get mypool size- 1

- 2

- 3

#查看 PG 和 PGP 数量 ceph osd pool get mypool pg_num ceph osd pool get mypool pgp_num- 1

- 2

- 3

- 4

1.4.3、 修改

#修改 pg_num 和 pgp_num 的数量为 128 ceph osd pool set mypool pg_num 128 ceph osd pool set mypool pgp_num 128 ceph osd pool get mypool pg_num ceph osd pool get mypool pgp_num- 1

- 2

- 3

- 4

- 5

- 6

- 7

#修改 Pool 副本数量为 2 ceph osd pool set mypool size 2 ceph osd pool get mypool size- 1

- 2

- 3

- 4

- 5

#修改默认副本数为 2 vim ceph.conf ...... osd_pool_default_size = 2 ceph-deploy --overwrite-conf config push node01 node02 node03- 1

- 2

- 3

- 4

- 5

- 6

- 7

1.4.4、 删除

修改ceph配置文件,开启删除存储池 删除存储池命令存在数据丢失的风险,Ceph 默认禁止此类操作。 需要管理员在 ceph.conf 配置文件中开启支持删除存储池的操作。- 1

- 2

- 3

- 4

- 5

vim ceph.conf ...... [mon] mon allow pool delete = true- 1

- 2

- 3

- 4

- 5

推送 ceph.conf 配置文件给所有 mon 节点- 1

ceph-deploy --overwrite-conf config push node01 node02 node03- 1

- 2

所有 mon 节点重启 ceph-mon 服务- 1

systemctl restart ceph-mon.target- 1

- 2

执行删除 Pool 命令- 1

ceph osd pool rm mypool mypool --yes-i-really-really-mean-it- 1

- 2

二、 CephFS文件系统MDS接口

-

CephFS(Ceph文件系统)是Ceph存储集群中用于支持分布式文件存储的组件。

-

MDS(Metadata Server)是CephFS的元数据服务器,它负责管理文件系统的元数据,包括目录结构、文件属性和权限等信息。

-

CephFS的MDS接口允许用户通过客户端与MDS服务器进行交互,实现对文件系统的访问和管理。

-

MDS接口提供了一系列命令和API,用于创建、删除、移动和修改文件和目录、设置权限和ACL、查询文件和目录属性等操作。

-

通过MDS接口,用户可以以类似于传统文件系统的方式操作CephFS。

-

用户可以使用标准的文件系统操作命令(比如ls、cp、mv等)或者调用相应的API,通过MDS服务器访问和管理文件系统中的数据。

-

MDS接口还支持并发访问和多客户端操作,确保数据的一致性和安全性。

总的来说,CephFS的MDS接口提供了用户与Ceph存储集群中的元数据服务器进行交互的方式,实现对分布式文件系统的访问和管理。 通过MDS接口,用户可以实现对文件和目录的增删改查操作,并确保数据的可靠性和一致性。- 1

- 2

- 3

三、创建CephFS文件系统MDS接口

3.1 、服务端操作

#在管理节点创建 mds 服务 cd /etc/ceph ceph-deploy mds create node01 node02 node03 #查看各个节点的 mds 服务 ssh root@node01 systemctl status ceph-mds@node01 ssh root@node02 systemctl status ceph-mds@node02 ssh root@node03 systemctl status ceph-mds@node03- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

创建存储池,启用 ceph 文件系统 ceph 文件系统至少需要两个 rados 池,一个用于存储数据,一个用于存储元数据。 此时数据池就类似于文件系统的共享目录。- 1

- 2

- 3

ceph osd pool create cephfs_data 128 #创建数据Pool ceph osd pool create cephfs_metadata 128 #创建元数据Pool- 1

- 2

- 3

- 4

#创建 cephfs #命令格式:ceph fs new- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

ceph fs ls #查看cephfs- 1

- 2

查看mds状态 一个up,其余两个待命,目前的工作的是node01上的mds服务- 1

- 2

ceph -s- 1

- 2

创建用户- 1

#语法格式 ceph fs authorize <fs_name> client.<client_id> <path-in-cephfs> rw #账户为 client.zhangsan #用户 name 为 zhangsan #zhangsan 对ceph文件系统的 / 根目录(注意不是操作系统的根目录)有读写权限 ceph fs authorize mycephfs client.zhangsan / rw | tee /etc/ceph/zhangsan.keyring # 账户为 client.lisi #用户 name 为 lisi #lisi 对文件系统的 / 根目录只有读权限,对文件系统的根目录的子目录 /test 有读写权限 ceph fs authorize mycephfs client.lisi / r /test rw | tee /etc/ceph/lisi.keyring- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

3.2、 客户端操作

在客户端创建工作目录 客户端要在 public 网络内。- 1

- 2

mkdir /etc/ceph- 1

- 2

向客户端拷贝相关文件 在 ceph 的管理节点给客户端拷贝 ceph 的配置文件 ceph.conf 和账号的秘钥环文件 zhangsan.keyring、lisi.keyring- 1

- 2

- 3

scp ceph.conf zhangsan.keyring lisi.keyring root:/etc/ceph- 1

- 2

在客户端安装 ceph 软件包- 1

cd /opt wget https://download.ceph.com/rpm-nautilus/el7/noarch/ceph-release-1-1.el7.noarch.rpm --no-check-certificate rpm -ivh ceph-release-1-1.el7.noarch.rpm yum install -y ceph- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

在客户端制作秘钥文件- 1

cd /etc/ceph ceph-authtool -n client.zhangsan -p zhangsan.keyring > zhangsan.key #把 zhangsan 用户的秘钥导出到 zhangsan.keyl ceph-authtool -n client.lisi -p lisi.keyring > lisi.key #把 lisi 用户的秘钥导出到 lisi.key- 1

- 2

- 3

- 4

- 5

客户端挂载 方式一:基于内核- 1

- 2

语法格式: mount -t ceph node01:6789,node02:6789,node03:6789:/ <本地挂载点目录> -o name=<用户名>,secret=<秘钥> mount -t ceph node01:6789,node02:6789,node03:6789:/ <本地挂载点目录> -o name=<用户名>,secretfile=<秘钥文件> 示例一: mkdir -p /data/zhangsan mount -t ceph node01:6789,node02:6789,node03:6789:/ /data/zhangsan -o name=zhangsan,secretfile=/etc/ceph/zhangsan.key 示例二: mkdir -p /data/lisi mount -t ceph node01:6789,node02:6789,node03:6789:/ /data/lisi -o name=lisi,secretfile=/etc/ceph/lisi.key #验证用户权限 cd /data/lisi echo 123 > 2.txt -bash:2.txt:权限不够 echo 123 > test/2.txt cat test/2.txt 123 示例三: #停掉 node02 上的 mds 服务 ssh root "systemctl stop ceph-mds@node02" ceph -s #测试客户端的挂载点仍然是可以用的,如果停掉所有的 mds,客户端就不能用了- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

方式二:基于 fuse 工具 将管理员密钥文件ceph.client.admin.keyring拷贝给客户端- 1

- 2

scp ceph.client.admin.keyring root:/etc/ceph- 1

- 2

在客户端安装 ceph-fuse- 1

yum install -y ceph-fuse- 1

- 2

客户端挂载 挂载时,如果挂载点不为空会挂载失败,指定 -o nonempty 可以忽略。- 1

- 2

mkdir -p /data/aa cd /data/aa ceph-fuse -m node01:6789,node02:6789,node03:6789 /data/aa 本地文件系统访问和llc操作 Ceph 存储集群中的文件和目录 #starting ceph client 表示 Ceph 客户端正在启动,即将连接到 Ceph 存储集群。 #starting fuse 表示 FUSE 客户端正在启动,并准备挂载 CephFS- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

四、Ceph 块存储系统 RBD 接口

4.1、 RBD接口简介

-

Ceph 块存储系统(RBD)提供了一种与Ceph集群交互的接口,使用户可以在分布式存储环境中使用块设备。

-

RBD接口可以让用户创建、映射、快照、克隆和删除RBD镜像,就像使用本地块设备一样。

-

通过RBD接口,用户可以将Ceph集群中的存储资源虚拟化为块设备,从而为应用程序提供高性能、高可用性和可扩展性。

-

用户可以通过RBD接口操作RBD镜像,实现诸如数据备份、迁移和卷管理等功能。

-

通过这些协议,用户可以通过网络访问和管理RBD镜像,从而实现分布式存储的灵活性和可伸缩性。

4.2、 使用 RBD 的两种方式

通过内核模块KRBD将镜像映射为系统本地块设备,通常设置文件一般为:/dev/rbd* 另一种是通过librbd接口,通常KVM虚拟机使用这种接口。- 1

- 2

4.3、 镜像管理

4.3.1、 查看

1、创建一个名为 rbd-demo 的专门用于 RBD 的存储池 ceph osd pool create rbd-demo 64 64 2、将存储池转换为 RBD 模式 ceph osd pool application enable rbd-demo rbd 3、初始化存储池 rbd pool init -p rbd-demo # -p 等同于 --pool 4、创建镜像 rbd create -p rbd-demo --image rbd-demo1.img --size 10G 可简写为: rbd create rbd-demo/rbd-demo2.img --size 10G- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

#查看存储池下存在哪些镜像 rbd ls -l -p rbd-demo- 1

- 2

- 3

#查看镜像的详细信息 rbd info -p rbd-demo --image rbd-demo1.img rbd image 'rbd-demo.img': size 10 GiB in 2560 objects #镜像的大小与被分割成的条带数 order 22 (4 MiB objects) #条带的编号,有效范围是12到25,对应4K到32M,而22代表2的22次方,这样刚好是4M snapshot_count: 0 id: 5fc98fe1f304 #镜像的ID标识 block_name_prefix: rbd_data.5fc98fe1f304 #名称前缀 format: 2 #使用的镜像格式,默认为2 features: layering, exclusive-lock, object-map, fast-diff, deep-flatten #当前镜像的功能特性 op_features: #可选的功能特性 flags:- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

4.3.2、 修改镜像大小

#修改镜像大小 rbd resize -p rbd-demo --image rbd-demo1.img --size 20G rbd info -p rbd-demo --image rbd-demo1.img #使用 resize 调整镜像大小,一般建议只增不减,如果是减少的话需要加选项 --allow-shrink rbd resize -p rbd-demo --image rbd-demo1.img --size 5G --allow-shrink- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

4.3.3、 删除镜像

#直接删除镜像 rbd rm -p rbd-demo --image rbd-demo2.img rbd remove rbd-demo/rbd-demo2.img #推荐使用 trash 命令,这个命令删除是将镜像移动至回收站,如果想找回还可以恢复 rbd trash move rbd-demo/rbd-demo1.img rbd ls -l -p rbd-demo rbd trash list -p rbd-demo 5fc98fe1f304 rbd-demo1.img- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

4.3.4、 还原镜像

#还原镜像 rbd trash restore rbd-demo/5fc98fe1f304 rbd ls -l -p rbd-demo- 1

- 2

- 3

- 4

- 5

4.4、 快照管理

对RBD镜像进行快照,可以保留镜像的状态历史,另外还可以利用快照的分层技术,通过将快照克隆为新的镜像使用。- 1

4.4.1、 创建快照

rbd snap create --pool rbd-demo --image rbd-demo1.img --snap demo1_snap1 #可简写 rbd snap create rbd-demo/rbd-demo1.img- 1

- 2

- 3

- 4

- 5

4.4.2、 删除快照

#删除指定快照: rbd snap rm rbd-demo/rbd-demo1.img #删除所有快照: rbd snap purge rbd-demo/rbd-demo1.img- 1

- 2

- 3

- 4

- 5

- 6

4.4.3、 回滚到指定快照

rbd snap rollback rbd-demo/rbd-demo1.img- 1

- 2

4.4.4、 限制镜像可创建快照数

#限制镜像可创建快照数 rbd snap limit set rbd-demo/rbd-demo1.img --limit 3 #解除限制: rbd snap limit clear rbd-demo/rbd-demo1.img- 1

- 2

- 3

- 4

- 5

- 6

五、创建 Ceph 块存储系统 RBD 接口

5.1、 服务端操作

创建RBD存储池 创建一个名为 rbd-demo 的专门用于 RBD 的存储池- 1

- 2

ceph osd pool create rbd-demo 64 64- 1

- 2

将存储池转换为 RBD 模式- 1

ceph osd pool application enable rbd-demo rbd- 1

- 2

初始化存储池- 1

rbd pool init -p rbd-demo # -p 等同于 --pool- 1

- 2

- 3

用户授权- 1

#示例,指定用户标识为client.osd-mount,对另对OSD有所有的权限,对Mon有只读的权限 ceph auth get-or-create client.osd-mount osd "allow * pool=rbd-demo" mon "allow r" > /etc/ceph/ceph.client.osd-mount.keyrig- 1

- 2

- 3

创建镜像- 1

rbd create -p rbd-demo --image rbd-demo1.img --size 10G #可简写为 rbd create rbd-demo/rbd-demo2.img --size 10G #查看存储池下存在哪些镜像 rbd ls -l -p rbd-demo- 1

- 2

- 3

- 4

- 5

- 6

- 7

修改RBD镜像特性 CentOS7默认情况下只支持layering和striping特性,需要将其它的特性关闭。- 1

- 2

rbd feature disable rbd-demo/rbd-demo1.img object-map,fast-diff,deep-flatten- 1

- 2

远程传输相关文件到客户端 将用户的keyring文件和ceph.conf文件发送到客户端的/etc/ceph目录下。- 1

- 2

cd /etc/ceph scp ceph.client.osd-mount.keyring ceph.conf root:/etc/ceph- 1

- 2

- 3

- 4

在线扩容(可选)- 1

#在管理节点调整镜像的大小 rbd resize rbd-demo/rbd-demo1.img --size 30G- 1

- 2

- 3

客户端操作 执行客户端映射- 1

- 2

#安装 ceph-common 软件包 yum install -y ceph-common #执行客户端映射 cd /etc/ceph rbd map rbd-demo/rbd-demo1.img --keyring /etc/ceph/ceph.client.osd-mount.keyring --user osd-mount- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

#查看映射 rbd showmapped rbd device list - `id`: 表示RBD镜像的标识符。在此示例中,标识符为0。 - `pool`: 表示RBD镜像所在的存储池名称。在此示例中,存储池名称为`rbd-demo`。 - `namespace`: 表示RBD镜像所在的命名空间。在此示例中,未设定命名空间。 - `image`: 表示RBD镜像的名称。在此示例中,镜像名称为`rbd-demo1.img`。 - `snap`: 表示RBD镜像的快照名称。在此示例中,未设置快照,所以显示为`-`。 - `device`: 表示RBD镜像在操作系统中映射的设备路径。在此示例中,设备路径为`/dev/rbd0`。- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

5.3、 快照功能验证(回滚)

在客户端写入测试文件 echo 1111 > /data/aa/11.txt echo 2222 > /data/aa/22.txt echo 3333 > /data/aa/33.txt- 1

- 2

- 3

- 4

在管理节点对镜像创建快照- 1

rbd snap create --pool rbd-demo --image rbd-demo1.img --snap demo1_snap1 #可简写 rbd snap create rbd-demo/rbd-demo1.img ##命令详解## - `rbd snap create`: 这是用于创建RBD镜像快照的命令。 - `--pool rbd-demo`: 这表示指定快照所属的RBD镜像所在的存储池名称为 `rbd-demo`。 - `--image rbd-demo1.img`: 这表示指定要创建快照的RBD镜像名称为 `rbd-demo1.img`。 - `--snap demo1_snap1`: 这表示指定要创建的快照名称为 `demo1_snap1`。 在存储池 `rbd-demo` 中的镜像 `rbd-demo1.img` 上创建一个名为 `demo1_snap1` 的快照。- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

#列出指定镜像所有快照 rbd snap list rbd-demo/rbd-demo1.img ##输出信息详解## - `SNAPID`: 快照的唯一标识符,用于在存储系统中识别和管理快照 - `NAME`: 快照的名称 - `SIZE`: 快照的大小 - `PROTECTED`: 表示快照是否被保护 - `TIMESTAMP`: 快照的创建时间戳- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

#用json格式输出: rbd snap list rbd-demo/rbd-demo1.img --format json --pretty-format- 1

- 2

- 3

回滚RBD 镜像到指定的快照 在回滚快照之前,需要将镜像取消镜像的映射,然后再回滚。 在客户端解除挂载和映射- 1

- 2

- 3

#删除写入文件 rm -rf /data/bb/* #解挂载 umount /data/bb #取消映射 rbd unmap rbd-demo/rbd-demo1.img- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

在管理节点回滚RBD镜像 #RBD 镜像恢复到指定的快照状态 rbd snap rollback rbd-demo/rbd-demo1.img- 1

- 2

- 3

- 4

在客户端重新映射并挂载- 1

#重新映射 rbd map rbd-demo/rbd-demo1.img --keyring /etc/ceph/ceph.client.osd-mount.keyring --user osd-mount #挂载 mount /dev/rbd0 /data/bb- 1

- 2

- 3

- 4

- 5

- 6

观察数据是否恢复 ls /data/aa- 1

- 2

5.4、 镜像的导出导入

5.4.1、 导出镜像

#导出 RBD 镜像 rbd-demo/rbd-demo1.img 到/opt rbd export rbd-demo/rbd-demo1.img /opt/rbd-demo1.img- 1

- 2

- 3

5.4.2、 导入镜像

#卸载客户端挂载,并取消映射 umount /data/bb rbd unmap rbd-demo/rbd-demo1.img #清除镜像下的所有快照,并删除镜像 rbd snap purge rbd-demo/rbd-demo1.img rbd rm rbd-demo/rbd-demo1.img rbd ls -l -p rbd-demo- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

#导入镜像 rbd import /opt/rbd-demo1.img rbd-demo/rbd-demo1.img rbd ls -l -p rbd-demo- 1

- 2

- 3

- 4

- 5

六、对象存储RGW接口

6.1、 对象存储的概念

对象存储(object storage)是非结构数据的存储方法,对象存储中每一条数据都作为单独的对象存储,拥有唯一的地址来识别数据对象,通常用于云计算环境中。 不同于其他数据存储方法,基于对象的存储不使用目录树。- 1

- 2

- 3

6.2、 相关组件

从客户端的角度来看,分为以下几个逻辑单位 Amazon S3提供了 1、用户(User) 2、存储桶(Bucket) 3、对象(Object)- 1

- 2

- 3

- 4

- 5

- 6

三者的关系是:

-

User将Object存储到系统上的Bucket;

-

存储桶属于某个用户并可以容纳对象,一个存储桶用于存储多个对象;

-

同一个用户可以拥有多个存储桶,不同用户允许使用相同名称的Bucket,因此User名称即可做为Bucket的名称空间。

OpenStack Swift

- 提供了user、container和object分别对应于用户、存储桶和对象。

- 不过它还额外为user提供了父级组件account,用于表示一个项目或用户,因此一个account中可以包含一到多个user,它们可共享使用同一组container,并为container提供名称空间

RadosGW

- 提供了user、subuser、bucket和object。

其中的user对应于S3的user,而subuser则对应于Swift的user,不过user和subuser都不支持为bucket提供名称空间,因此不同用户的存储桶不允许同名; - 不过,自jewel版本起,RadosGW引入了tenant(租户)用于为user和bucket提供名称空间,但他是个可选组件

6.3、 组件之间的关系

-

S3和Swift可基于http或https完成数据交换,由RadosGW内建的Civetweb提供服务;

-

它还可以支持代理服务器包括nginx、haproxy等以代理的形式接收用户请求,再转发至RadosGW进程;

-

RGW 的功能依赖于对象网关守护进程实现,负责向客户端提供 REST API 接口;

-

出于冗余负载均衡的需求,一个 Ceph 集群上通常不止一个 RadosGW 守护进程。

七、创建RGW接口

7.1、 在管理节点创建一个 RGW 守护进程

cd /etc/ceph ceph-deploy rgw create node01- 1

- 2

- 3

- 4

ceph -s- 1

#创建成功后默认情况下会自动创建一系列用于 RGW 的存储池 ceph osd pool ls rgw.root default.rgw.control #控制器信息 default.rgw.meta #记录元数据 default.rgw.log #日志信息 default.rgw.buckets.index #为 rgw 的 bucket 信息,写入数据后生成 default.rgw.buckets.data #是实际存储的数据信息,写入数据后生成- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

#默认情况下 RGW 监听 7480 号端口 ssh root netstat -lntp | grep 7480 curl node01:7480- 1

- 2

- 3

- 4

- 5

7.2、 开启 http+https ,更改监听端口

RadosGW 守护进程内部由 Civetweb 实现,通过对 Civetweb 的配置可以完成对 RadosGW 的基本管理。

在rgw节点生成证书 要在 Civetweb 上启用SSL,首先需要一个证书。 生成CA证书私钥- 1

- 2

- 3

#在 rgw 节点生成证书 openssl genrsa -out civetweb.key 2048- 1

- 2

- 3

生成CA证书公钥- 1

openssl req -new -x509 -key civetweb.key -out civetweb.crt -days 3650 -subj "/CN=192.168.2.102"- 1

- 2

将生成的证书合并为pem- 1

cat civetweb.key civetweb.crt > /etc/ceph/civetweb.pem- 1

- 2

更改监听端口 Civetweb 默认监听在 7480 端口并提供 http 协议。 如果需要修改配置需要在管理节点编辑 ceph.conf 配置文件- 1

- 2

- 3

- 4

cd /etc/ceph vim ceph.conf ...... [client.rgw.node01] rgw_host = node01 rgw_frontends = "civetweb port=80+443s ssl_certificate=/etc/ceph/civetweb.pem num_threads=500 request_timeout_ms=60000" ------------------------------------------------------------ ●rgw_host:对应的RadosGW名称或者IP地址 ●rgw_frontends:这里配置监听的端口,是否使用https,以及一些常用配置: •port:如果是https端口,需要在端口后面加一个s。 •ssl_certificate:指定证书的路径。 •num_threads:最大并发连接数,默认为50,根据需求调整,通常在生产集群环境中此值应该更大 •request_timeout_ms:发送与接收超时时长,以ms为单位,默认为30000 •access_log_file:访问日志路径,默认为空 •error_log_file:错误日志路径,默认为空 ------------------------------------------------------------- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

#修改完 ceph.conf 配置文件后需要重启对应的 RadosGW 服务,再推送配置文件 ceph-deploy --overwrite-conf config push node0{1..3} ssh root systemctl restart ceph-radosgw.target- 1

- 2

- 3

- 4

- 5

#在 rgw 节点上查看端口 netstat -lntp | grep -w 80 netstat -lntp | grep 443- 1

- 2

- 3

- 4

在客户端访问验证- 1

curl http://192.168.11.11:80 curl -k https://192.168.11.11:443- 1

- 2

- 3

7.3、 创建 RadosGW 账户

在管理节点使用 radosgw-admin 命令创建 RadosGW 账户。- 1

radosgw-admin user create --uid="rgwuser" --display-name="rgw test user" #创建成功后将输出用户的基本信息, #其中最重要的两项信息为 #access_key #secret_key- 1

- 2

- 3

- 4

- 5

- 6

#用户创建成后功,如果忘记用户信息可以使用下面的命令查看 radosgw-admin user info --uid="rgwuser"- 1

- 2

- 3

7.4、 接口访问测试

在客户端安装 python3、python3-pip- 1

#安装 yum install -y python3 python3-pip #查看版本 python3 -V pip3 -V- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

安装 boto 模块,用于测试连接 S3- 1

编写测试脚本- 1

echo 123123 > /opt/123.txt- 1

- 2

#编写测试脚本 vim test.py #coding:utf-8 import ssl import boto.s3.connection from boto.s3.key import Key try: _create_unverified_https_context = ssl._create_unverified_context except AttributeError: pass else: ssl._create_default_https_context = _create_unverified_https_context #test用户的keys信息 access_key = "A74DIOBARKTREHQBMU0W" #输入 RadosGW 账户的 access_key secret_key = "yvvyTr1ZWjkOnY5rVfmO45Xd60E0MzJGzZhKAWf0" #输入 RadosGW 账户的 secret_key #rgw的ip与端口 host = "192.168.2.102" #输入 RGW 接口的 public 网络地址 #如果使用443端口,下述链接应设置is_secure=True port = 443 #如果使用80端口,下述链接应设置is_secure=False #port = 80 conn = boto.connect_s3( aws_access_key_id=access_key, aws_secret_access_key=secret_key, host=host, port=port, is_secure=True, validate_certs=False, calling_format=boto.s3.connection.OrdinaryCallingFormat() ) #一:创建存储桶 conn.create_bucket(bucket_name='bucket01') conn.create_bucket(bucket_name='bucket02') #二:判断是否存在,不存在返回None exists = conn.lookup('bucket01') print(exists) #exists = conn.lookup('bucket02') #print(exists) #三:获得一个存储桶 bucket1 = conn.get_bucket('bucket01') bucket2 = conn.get_bucket('bucket02') #四:查看一个bucket下的文件 print(list(bucket1.list())) print(list(bucket2.list())) #五:向s3上存储数据,数据来源可以是file、stream、or string #5.1、上传文件 bucket1 = conn.get_bucket('bucket01') # name的值是数据的key key = Key(bucket=bucket1, name='myfile') key.set_contents_from_filename('/opt/123.txt') # 读取 s3 中文件的内容,返回 string 即文件 123.txt 的内容 print(key.get_contents_as_string()) #5.2、上传字符串 #如果之前已经获取过对象,此处不需要重复获取 bucket2 = conn.get_bucket('bucket02') key = Key(bucket=bucket2, name='mystr') key.set_contents_from_string('hello world') print(key.get_contents_as_string()) #六:删除一个存储桶,在删除存储桶本身时必须删除该存储桶内的所有key bucket1 = conn.get_bucket('bucket01') for key in bucket1: key.delete() bucket1.delete()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

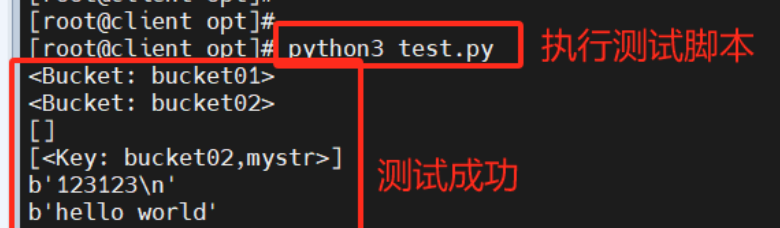

执行 python 脚本,测试访问 S3 接口- 1

python3 test.py- 1

- 2

八、OSD 故障模拟与恢复

如果 ceph 集群有上千个 osd,每天坏 2~3 个太正常了,我们可以模拟 down 掉一个 osd。- 1

8.1、 模拟 OSD 故障

#down 掉 osd ceph osd down 0 ceph osd tree #down 掉 osd ceph osd down 0 ceph osd tree- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

8.2、故障恢复

将坏掉的 osd 踢出集群- 1

#将 osd.0 移出集群,集群会开始自动同步数据 ceph osd out osd.0 #将 osd.0 移除 crushmap ceph osd crush remove osd.0- 1

- 2

- 3

- 4

- 5

- 6

#删除守护进程对应的账户信息 ceph auth rm osd.0 ceph auth list #删掉 osd.0 ceph osd rm osd.0- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

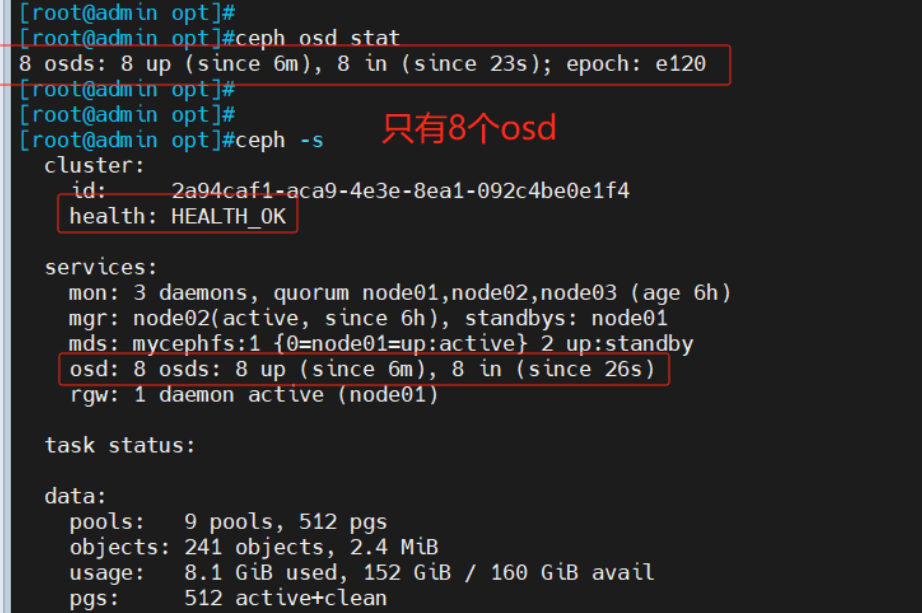

ceph osd stat ceph -s- 1

- 2

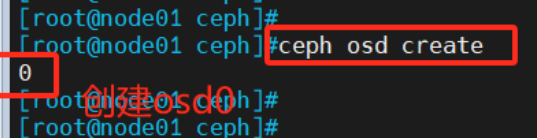

把原来坏掉的 osd 修复后重新加入集群- 1

#在 osd 节点创建 osd,无需指定名,会按序号自动生成 cd /etc/ceph ceph osd create- 1

- 2

- 3

- 4

- 5

#创建账户 ceph-authtool --create-keyring /etc/ceph/ceph.osd.0.keyring --gen-key -n osd.0 --cap mon 'allow profile osd' --cap mgr 'allow profile osd' --cap osd 'allow *' #导入新的账户秘钥 ceph auth import -i /etc/ceph/ceph.osd.0.keyring ceph auth list- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

#更新对应的 osd 文件夹中的密钥环文件 ceph auth get-or-create osd.0 -o /var/lib/ceph/osd/ceph-0/keyring #加入 crushmap ceph osd crush add osd.0 1.000 host=node01 #1.000 代表权重 #加入集群 ceph osd in osd.0 ceph osd tree- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

重启守护进程,观察故障是否恢复- 1

#重启 osd 守护进程 systemctl restart ceph-osd ceph osd tree #稍等片刻后 osd 状态为 up- 1

- 2

- 3

- 4

- 5

-

相关阅读:

angular2+ 集成系统利用服务作为模块通信中间件

Servlet规范之注解与可插拔性

java全局异常处理

网络层五大核心知识点

一步步来,如何提高语言表达能力,提高说服能力

【AI】创建自己的基于会话的自定义模型的ChatGPT

【Call for papers】DSN-2023(CCF-B/截稿日期: 2022年12月7日)

EPS功能开发与测试(基于ModelBase实现)

欧莱雅SAP系统成功合并

Go类型type

- 原文地址:https://blog.csdn.net/fyb012811/article/details/133824889