-

【python爬虫】15.Scrapy框架实战(热门职位爬取)

前言

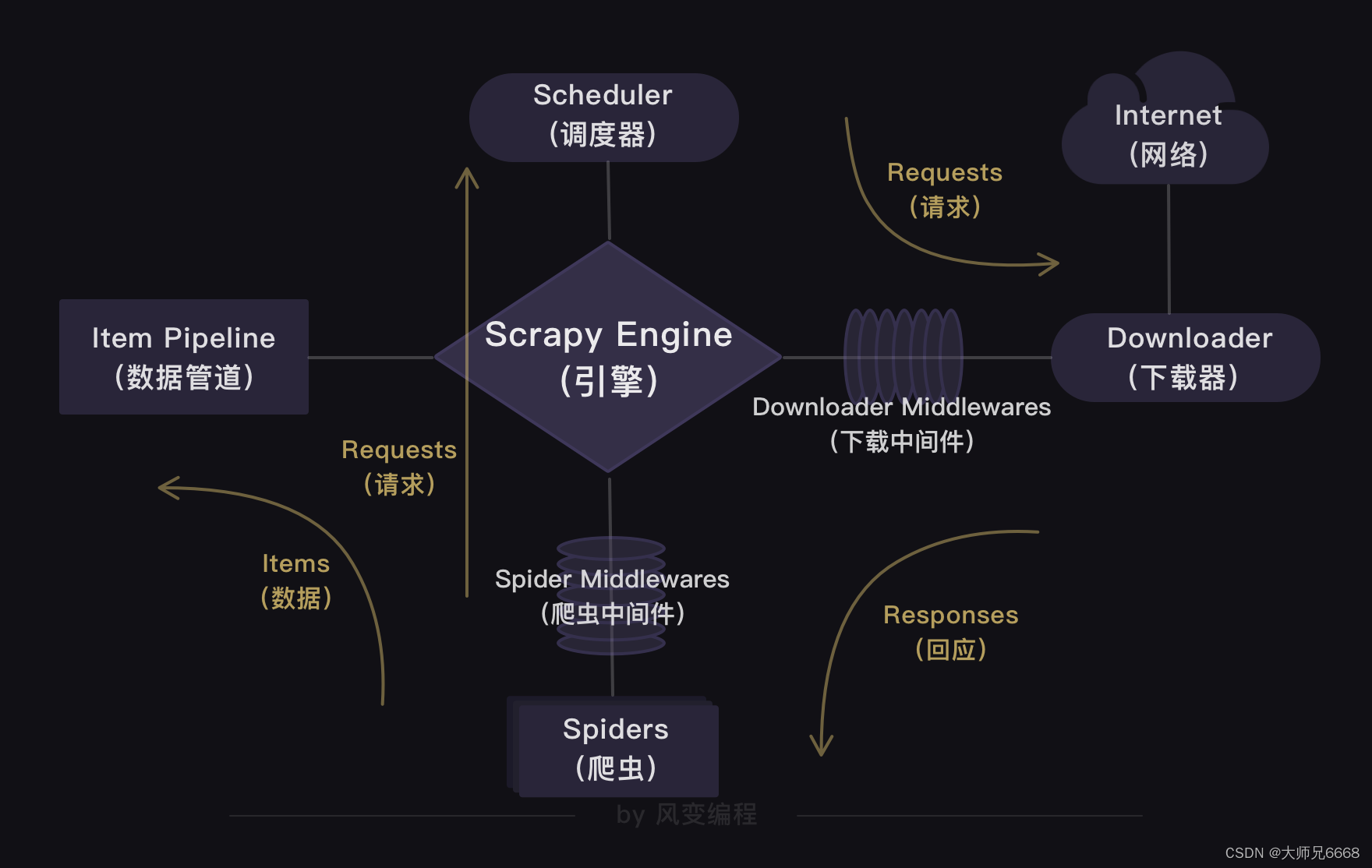

上一关,我们学习了Scrapy框架,知道了Scrapy爬虫公司的结构和工作原理。

在Scrapy爬虫公司里,引擎是最大的boss,统领着调度器、下载器、爬虫和数据管道四大部门。这四大部门都听命于引擎,视引擎的需求为最高需求。

我们还通过实操爬取豆瓣Top250图书的项目,熟悉了Scrapy的用法。

这一关,我会带你实操一个更大的项目——用Scrapy爬取招聘网站的招聘信息。你可以借此体验一把当Scrapy爬虫公司CEO的感觉,用代码控制并操作整个Scrapy的运行。

那我们爬取什么招聘网站呢?在众多招聘网站中,我挑选了职友集。这个网站可以通过索引的方式,搜索到全国上百家招聘网站的最新职位。

现在,请你用浏览器打开职友集的网址链接(一定要打开哦):https://www.jobui.com/rank/company/view/beijing/

我用的是北京的页面,大家可以根据自己的需要来进行更换地区。

我们先对这个网站做初步的观察,这样我们才能明确项目的爬取目标。

明确目标

打开网址后,你会发现:这是职友集网站的地区企业排行榜,里面含有本月人气企业榜。

点击【北京痘印信息服务有限公司】,会跳转到这家公司的详情页面,再点击【招聘】,就能看到这家公司正在招聘的所有岗位信息。

初步观察后,我们可以把爬取目标定为:先爬取企业排行榜四个榜单里的公司,再接着爬取这些公司的招聘信息。每个榜单有10家公司,四个榜单一共就是40家公司。也就是说,我们要先从企业排行榜爬取到这40家公司,再跳转到这40家公司的招聘信息页面,爬取到公司名称、职位、工作地点和招聘要求。

分析过程

明确完目标,我们开始分析过程。首先,要看企业排行榜里的公司信息藏在了哪里。

企业排行榜的公司信息

请你右击打开“检查”工具,点击Network,刷新页面。点开第0个请求beijing/,看Response,找一下有没有榜单的公司信息在里面。

一找,发现四个榜单的所有公司信息都在里面。说明企业排行榜的公司信息就藏在html里。现在请你点击Elements,点亮光标,再把鼠标移到【北京抖音信息服务有限公司】,这时就会定位到含有这家公司信息的

元素上。

点击href=“/company/10375749/”,会跳转到字节跳动这家公司的详情页面。详情页面的网址是:https://www.jobui.com/company/17376344/

我们可以猜到:/company/+数字/应该是公司id的标识。这么一观察,榜单上的公司详情页面的网址规律我们就得出来了。

那么,我们只要把

元素的href属性的值提取出来,就能构造出每家公司详情页面的网址。构造公司详情页面的网址是为了后面能获得详情页面里的招聘信息。

现在,我们来分析html的结构,看看怎样才能把

元素href属性的值提取出来。

仔细观察html的结构,你会发现,每个公司信息都藏在一个

元素里,这个div标签中包和两个div。我们想要的

标签,就在里面。我们想拿到所有

元素href属性的值。我们当然不能直接用find_all()抓取标签,原因也很简单:这个页面有太多的标签,会抓出来很多我们不想要的信息。一个稳妥的方案是:先抓取最外层的

标签,再抓取标签里的元素,最后提取到元素href属性的值。就像剥洋葱,要从最外面的一层开始剥一样。分析到这里,我们已经知道公司详情页面的网址规律,和如何提取

元素href属性的值。接下来,我们需要分析的就是,每家公司的详情页面。

公司详情页面的招聘信息

我们打开【北京字节跳动科技有限公司】的详情页面,点击【招聘】。这时,网址会发生变化,多了jobs的参数。

如果你多点击几家公司的详情页面,查看招聘信息,就会知道:公司招聘信息的网址规律也是有规律的。

接着,我们需要找找看公司的招聘信息都存在了哪里。还是在字节跳动公司的招聘信息页面,右击打开“检查”工具,点击Network,刷新页面。我们点击第0个请求jobs/,查看Response,翻找看看里面有没有这家公司的招聘信息。

在Response里我们找到了想要的招聘信息。这说明公司的招聘信息依旧是藏在了html里。

接下来,你应该知道要分析什么了吧。

分析的套路都是相同的,知道数据藏在html后,接着是分析html的结构,想办法提取出我们想要的数据。

那就按照惯例点击Elements,然后点亮光标,把鼠标移到公司名称吧。

公司名称藏在